par Sylvain Bouley | Jan 17, 2024 | Zoom Sur

L’observation des aurores polaires permet d’étudier à distance les planètes magnétisées et leur environnement, en complément de leur exploration in situ par des sondes spatiales. La magnétosphère de Saturne a été explorée de fond en comble entre 2004 et 2017 par la sonde spatiale internationale Cassini. La mission orbitale s’est conclue par une série inédite d’orbites polaires proches qui a fourni des observations uniques des régions aurorales, avec le soutien de télescopes terrestres comme Hubble. Un an après ce « Grand Finale », que sait-on des aurores kroniennes ?

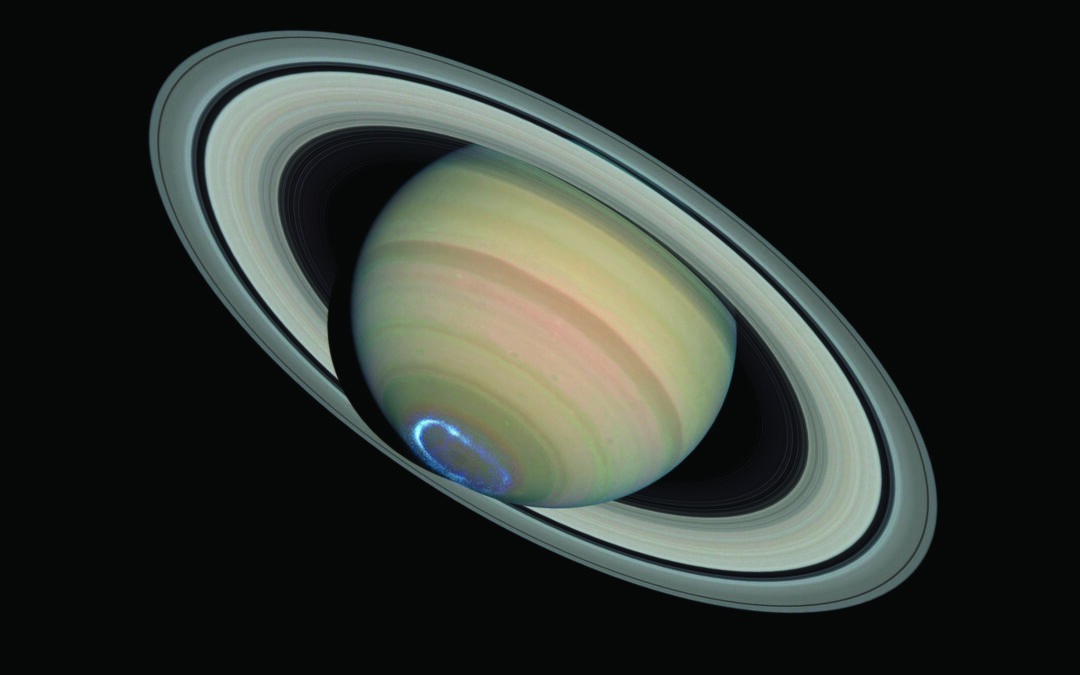

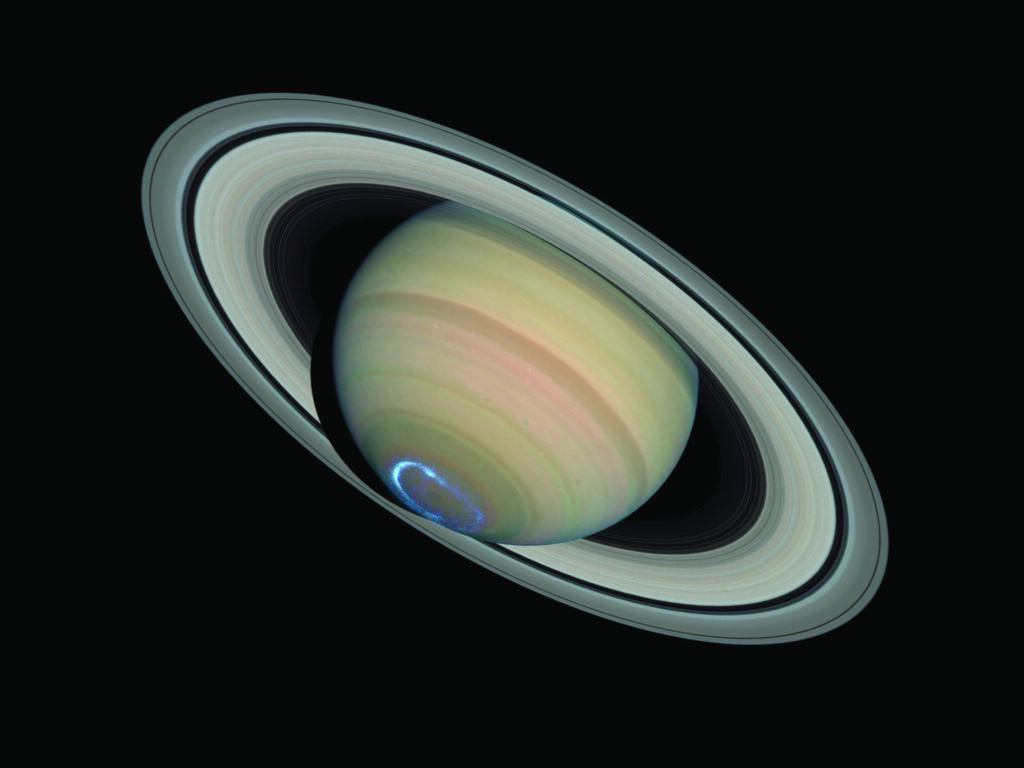

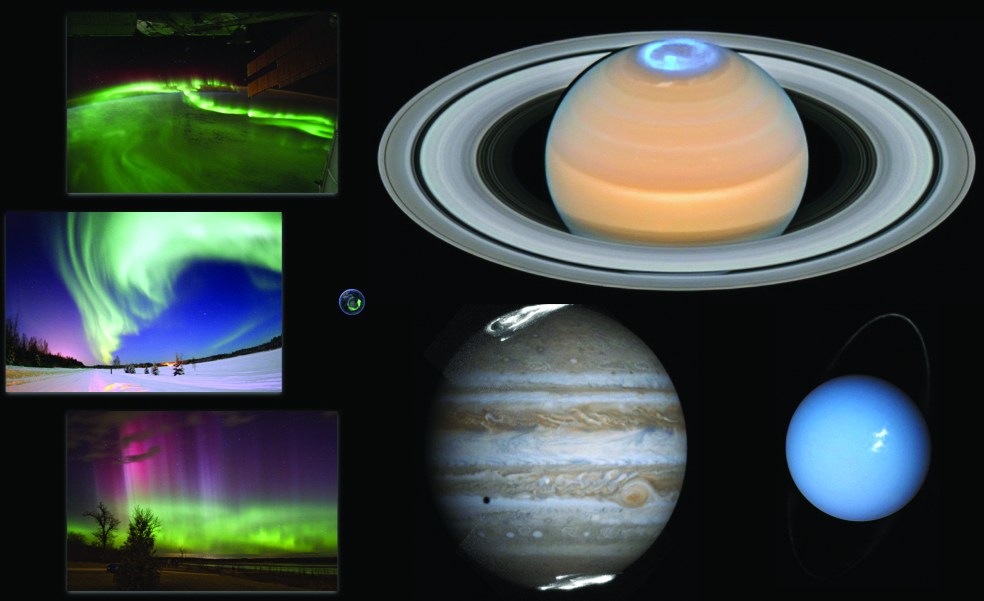

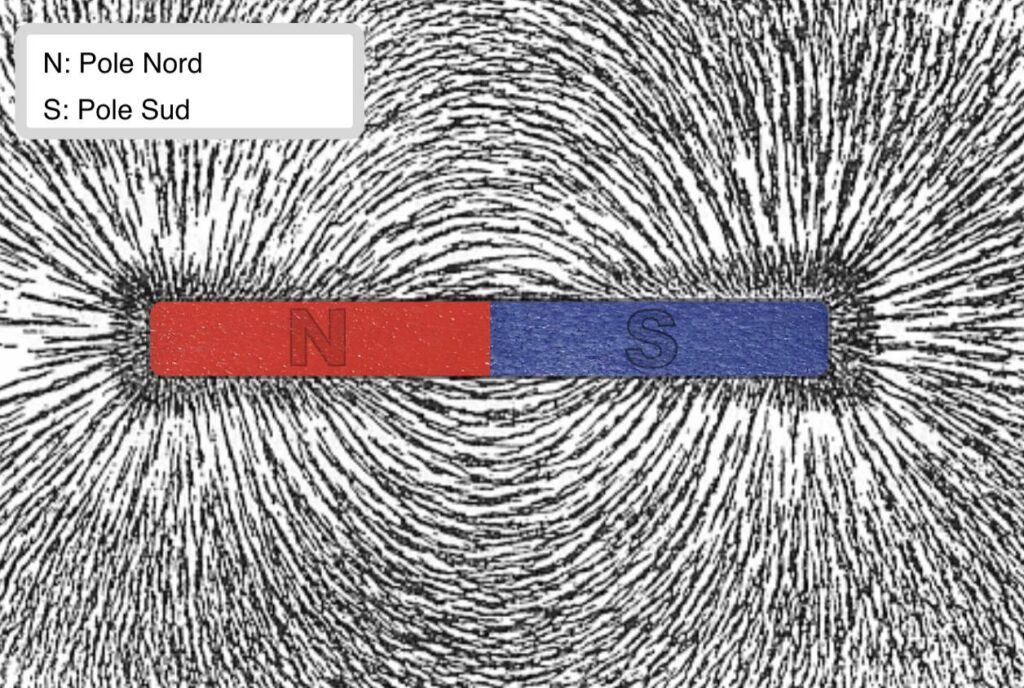

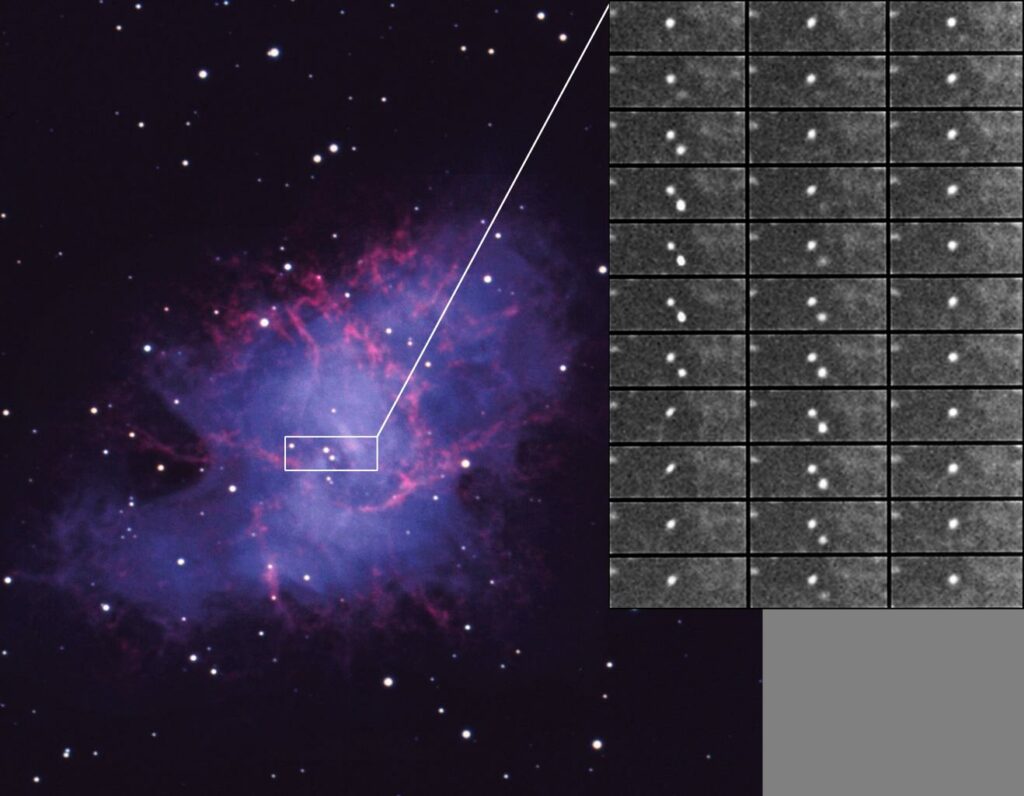

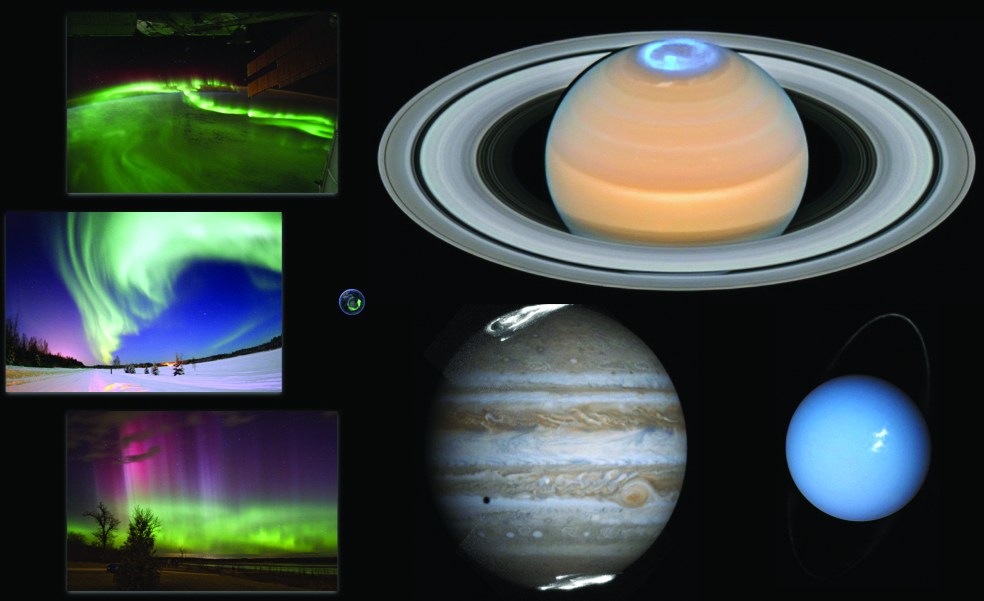

Les planètes ne sont pas que des réflecteurs de la lumière des étoiles, elles sont aussi le siège d’émissions lumineuses intrinsèques. Lorsqu’elles possèdent un champ magnétique à grande échelle, comme Mercure, la Terre ou les planètes géantes, elles produisent des ondes électromagnétiques intenses autour des pôles magnétiques, ceux qu’indique une boussole. Boréales au nord, australes au sud, ce sont les aurores polaires. Des aurores ont été observées sur presque tout le spectre électromagnétique, dans les domaines infrarouge (IR), visible et ultraviolet (UV) pour les émissions produites dans l’atmosphère et dans les gammes radio et X pour les ondes rayonnées à plus haute altitude, dans l’environnement planétaire proche. La figure 1 montre des images des aurores de la Terre et de Jupiter, Saturne et Uranus à l’échelle.

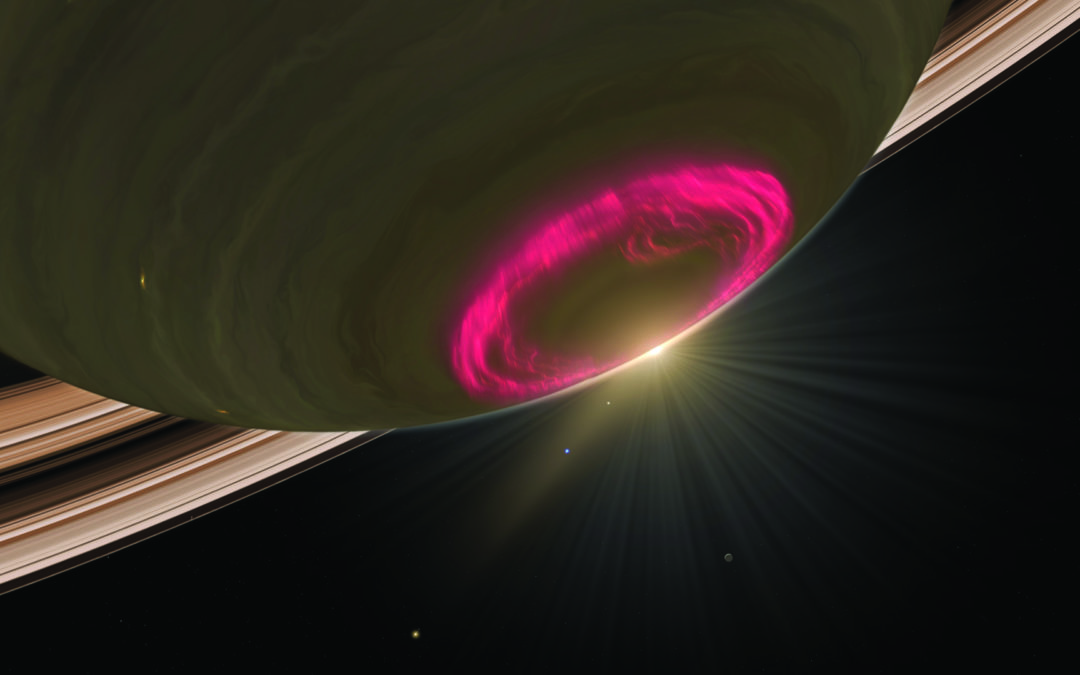

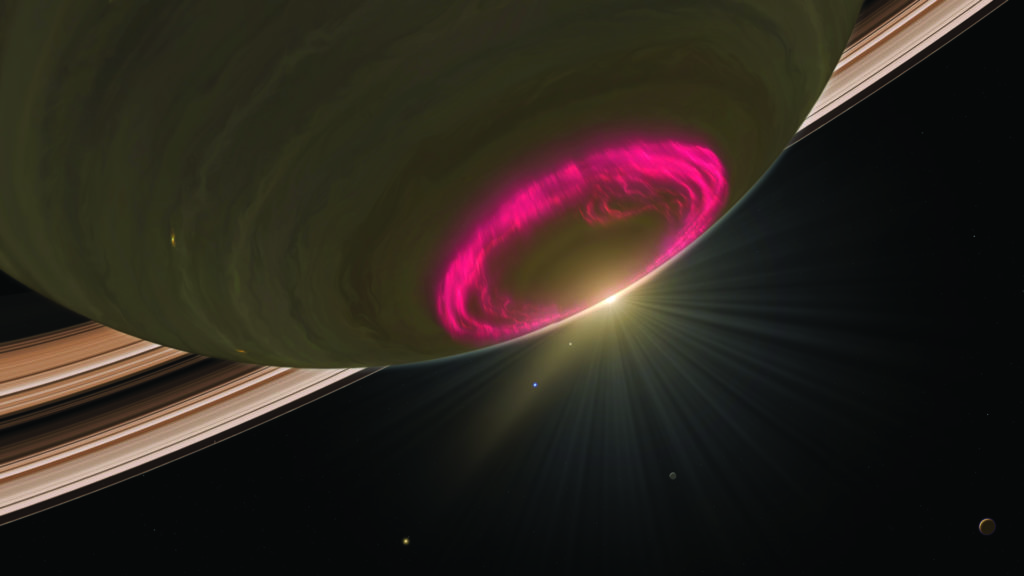

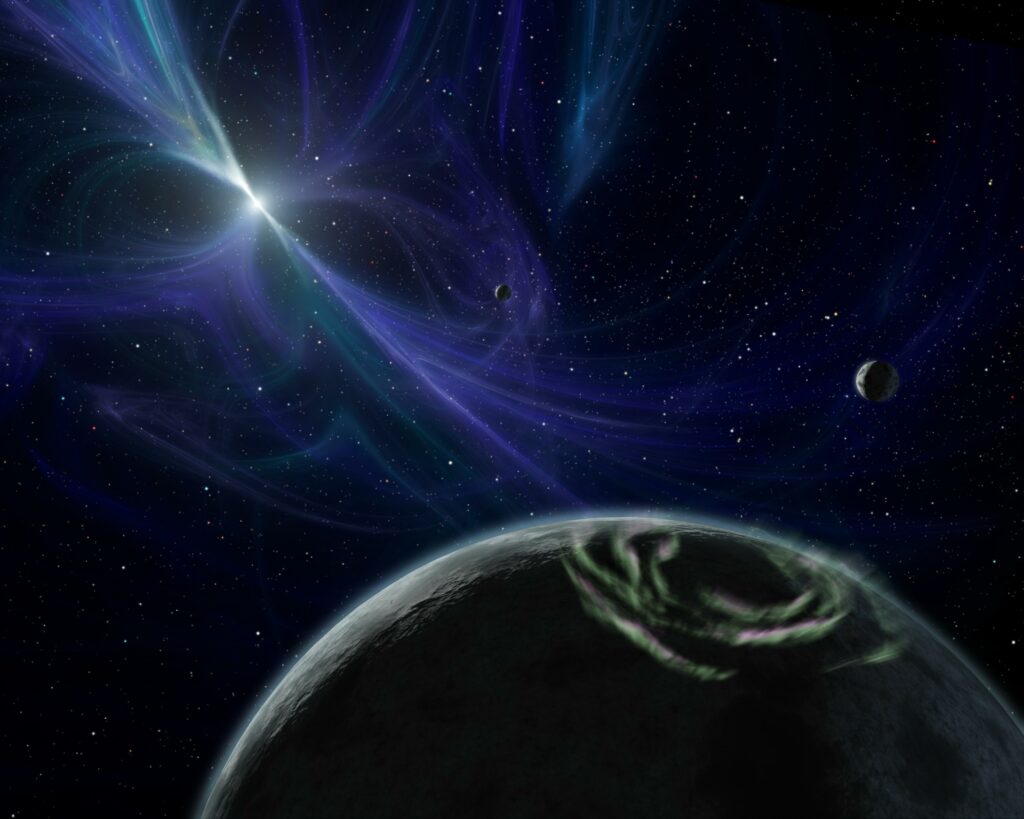

1. (Page de gauche) images composites des aurores ultraviolettes de saturne, Jupiter, Uranus et la terre, à l’échelle, toutes vues depuis l’espace. (Ci- dessus) images composites des aurores visibles de la terre, observées depuis le sol ou l’espace. (NASA/ESA, L. Lamy & R. Prangé, LESIA/Obs. de Paris)

L’aurore « aux doigts de rose » ou « en robe de safran », ces vers de l’Iliade décrivant l’aube antique en Méditerranée auraient pu s’appliquer avec non moins de poésie aux ballets colorés du ciel polaire terrestre. Ce spectacle a longtemps inspiré les contes nordiques avant l’essor de la physique ionosphérique et aurorale sous l’impulsion de Kristian Birkeland à la fin du xixe siècle, puis l’exploration in situ de l’environnement terrestre avec l’avènement de l’ère spatiale dans les années 1960. Aujourd’hui, la physique des aurores terrestres est bien comprise, même si Internet contribue à diffuser massivement tout autant de fausses idées que de magnifiques images [1]. Plus loin dans le Système solaire, si l’on excepte la détection des émissions radio aurorales de Jupiter dès 1955 à l’aide de radiotélescopes au sol (qui fournirent la première preuve observationnelle de l’existence d’un champ magnétique jovien !), les aurores des planètes géantes ont été découvertes plus tard, par les sondes d’exploration Voyager et le télescope spatial IUE (International Ultraviolet Explorer) dans les années 1980. Mais que nous apprennent au juste ces chandelles célestes sur les astres qui les rayonnent ?

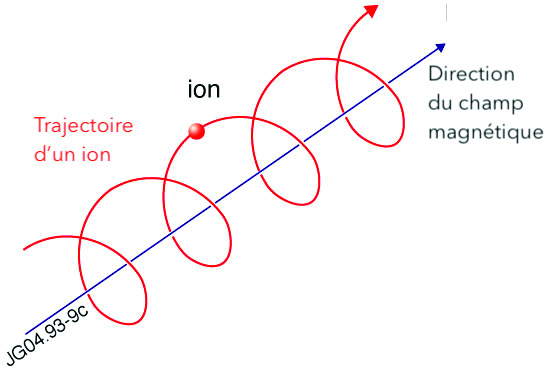

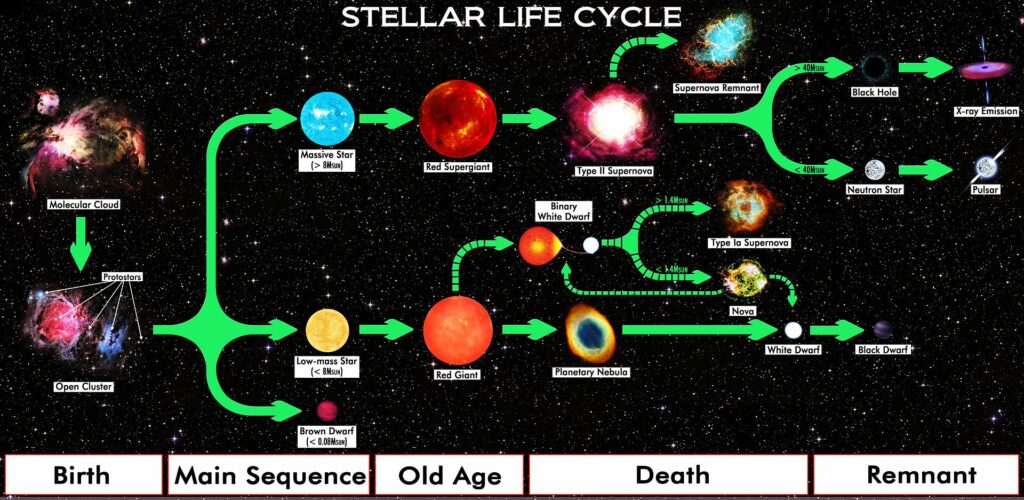

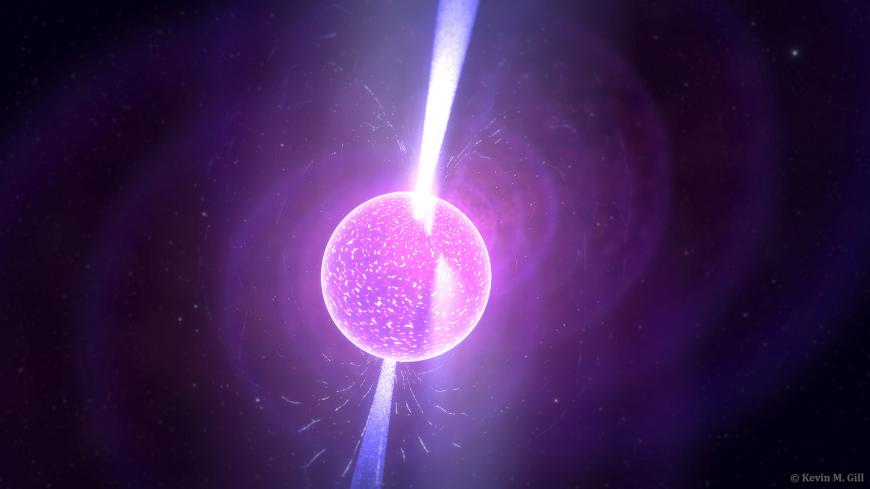

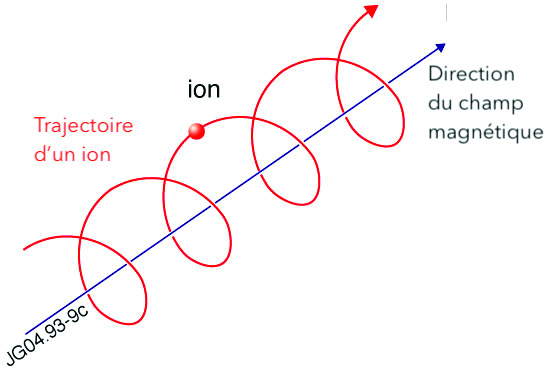

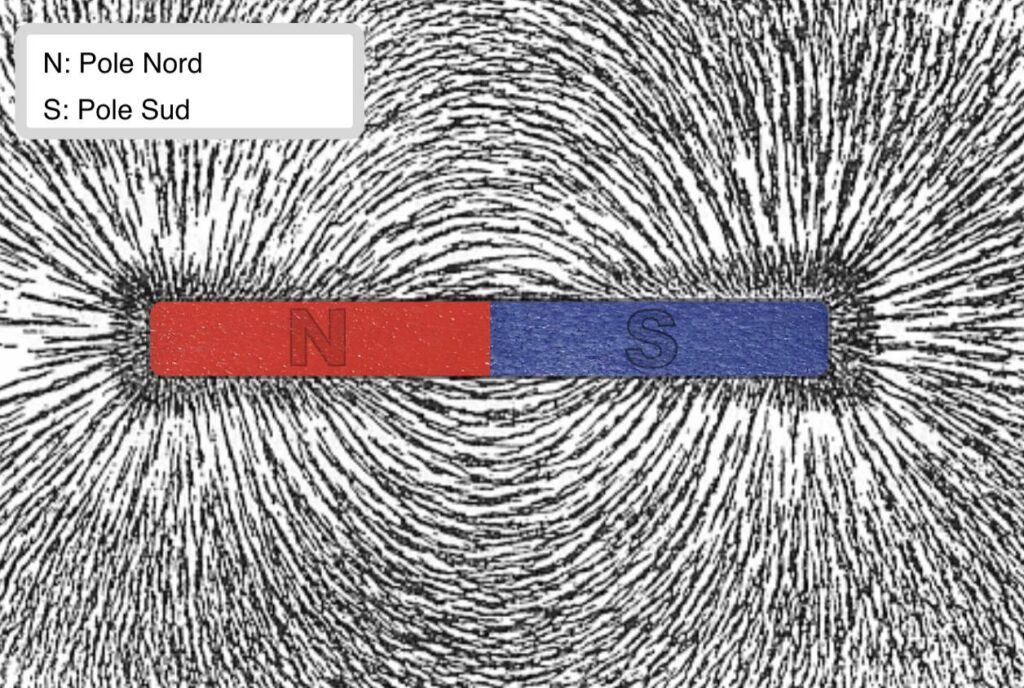

Les émissions aurorales sont produites par des particules énergétiques chargées électriquement. Ces particules, essentiellement des électrons, proviennent de l’environnement magnétisé et ionisé de la planète, sa magnétosphère, où elles sont accélérées puis guidées le long des lignes de champ magnétique de haute latitude, comme des perles sur un fil, jusqu’aux pôles magnétiques où leur énergie cinétique est dissipée en grande partie sous forme de rayonnement.

Lorsqu’elles entrent en collision avec la haute atmosphère, ces particules génèrent des émissions par impact qui couvrent la gamme UV/visible à IR. Au-dessus de l’atmosphère, elles alimentent des émissions dites de faisceau [Note 1] dans les domaines radio et X.

Les aurores révèlent ainsi des propriétés physiques essentielles de la planète hôte, son intérieur, son atmosphère et sa magnétosphère. Par exemple, la détection d’ovales auroraux organisés autour des pôles magnétiques donne instantanément la position de l’axe du champ magnétique planétaire. La mesure par un observateur fixe de la variation d’intensité en fonction du temps fournit, en sus, une mesure directe de la période de rotation du cœur planétaire qui produit le champ magnétique (selon le principe du phare tournant). Plus haut, les aurores sont un diagnostic des espèces chimiques de la haute atmosphère. Enfin, la position et la dynamique des différentes composantes aurorales renseignent sur les régions actives de la magnétosphère, identifiées grâce à un modèle de champ magnétique, et sondent les transferts d’énergie à grande échelle entre l’atmosphère, la magnétosphère, d’éventuelles lunes et le vent solaire.

L’étude des phénomènes auroraux du Système solaire bénéficie de mesures in situ de sondes d’exploration spatiale et d’observations à (grande) distance par des télescopes terrestres. C’est un enjeu d’envergure pour caractériser l’environnement des planètes magnétisées proches. Leur compréhension doit par ailleurs permettre d’établir un cadre de référence pour interpréter des émissions aurorales en provenance d’exoplanètes (dont la recherche bat son plein) ou d’objets plus massifs tels que des naines brunes ou des étoiles jeunes (avec déjà une quinzaine de sources aurorales détectées) inaccessibles à l’exploration. Le premier anniversaire de la fin de la mission orbitale Cassini nous donne l’occasion de revenir sur le cas très particulier de Saturne, qui ne se distingue pas seulement par son système d’anneaux, mais aussi par une magnétosphère atypique et de spectaculaires aurores polaires !

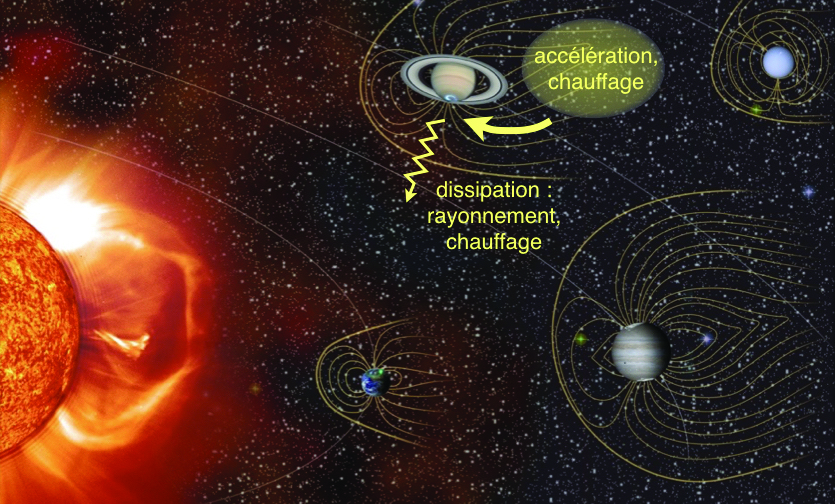

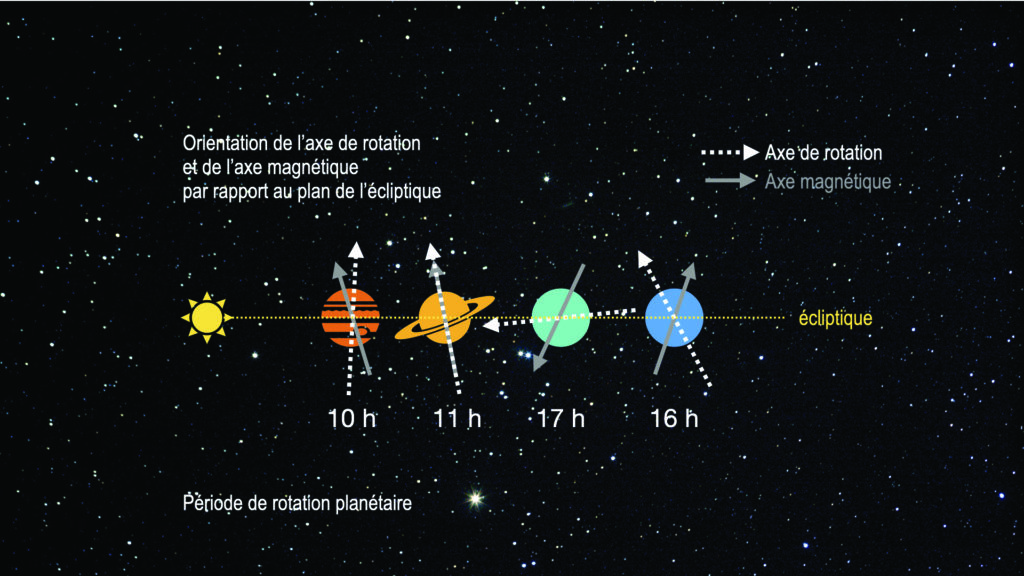

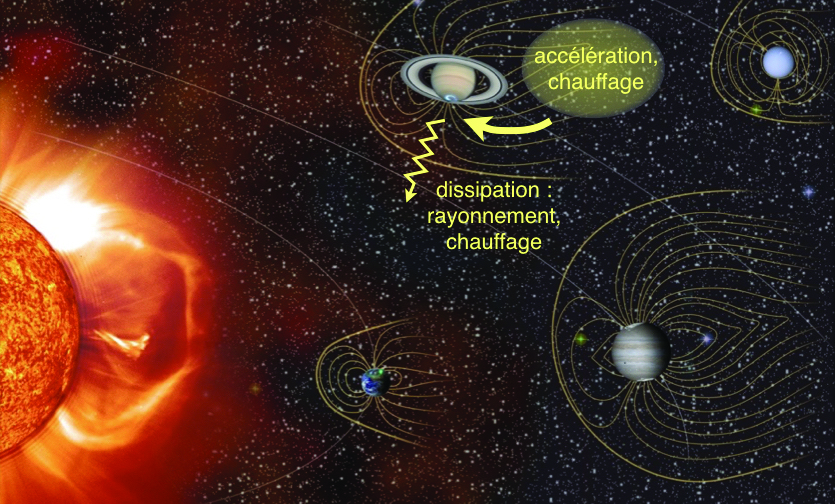

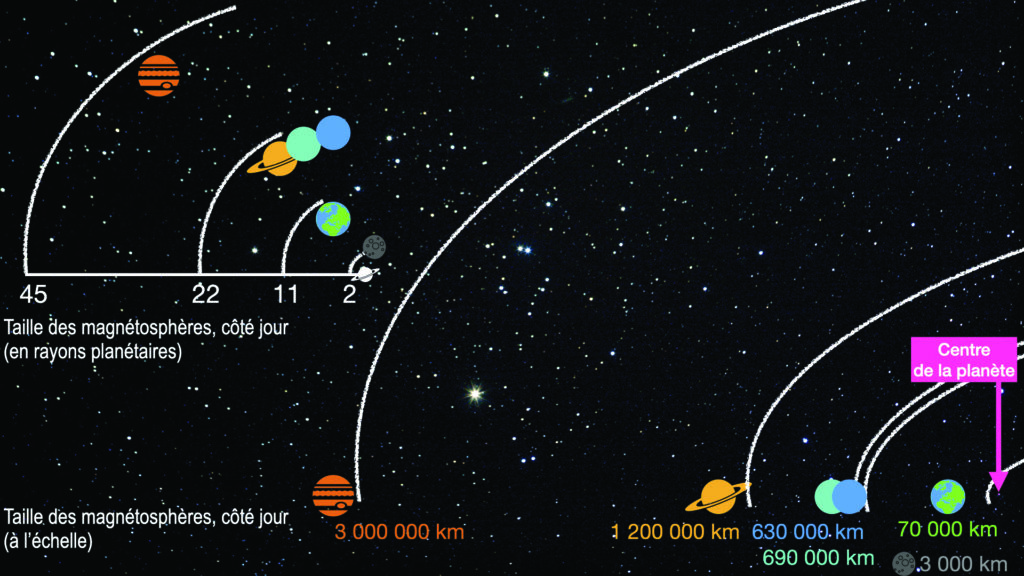

2. représentation schématique des magnétosphères planétaires du système solaire. Les particules énergisées dans l’environnement planétaire migrent vers les pôles magnétiques où l’énergie transportée est dissipée sous forme de rayonnements auroraux. (NASA/ESA, S. Cnudde & L. Lamy, LESIA/Obs. de Paris)

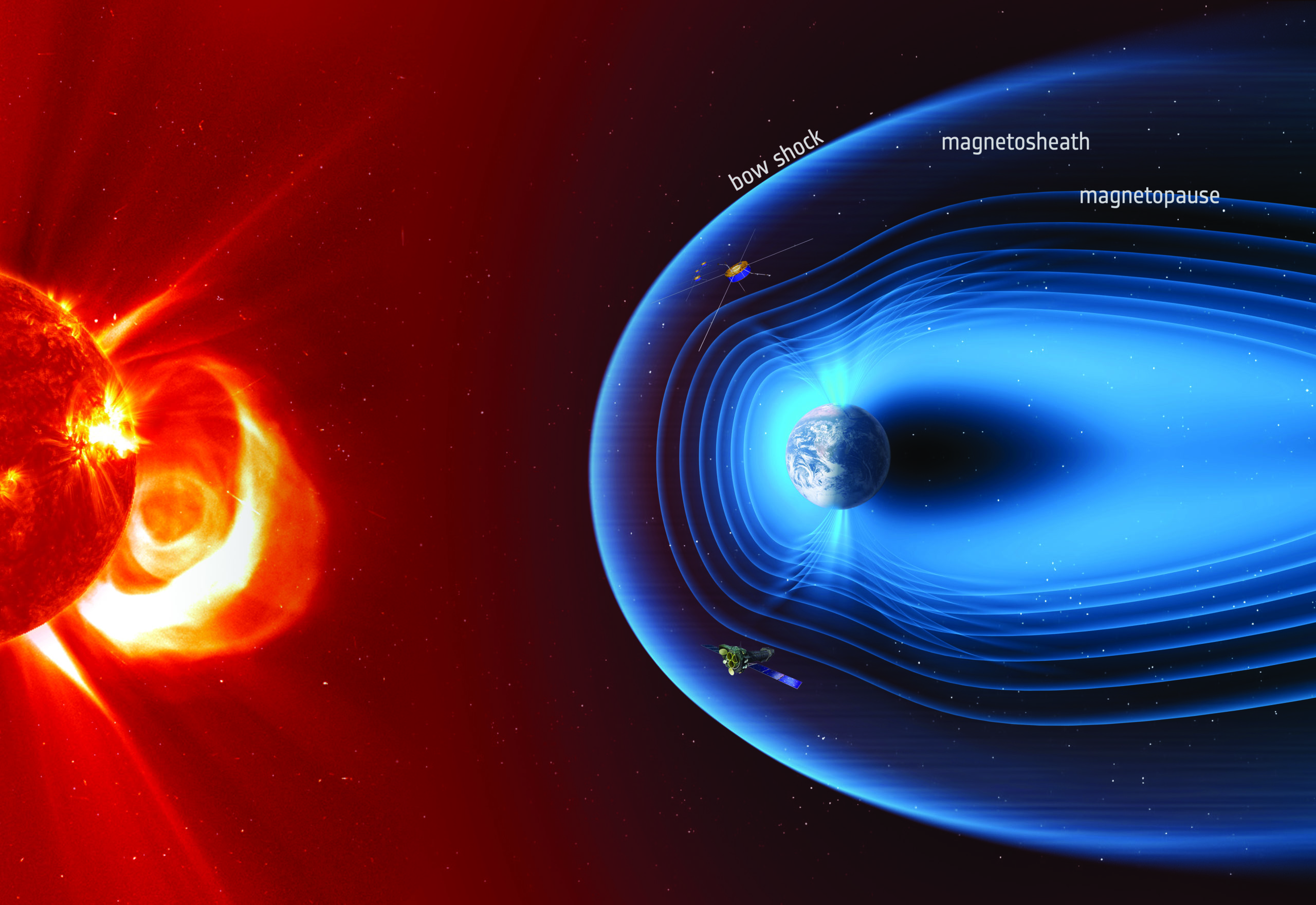

La magnétosphère géante de Saturne

Le lecteur assidu de l’Astronomie se souviendra sans doute d’un (excellent) article dédié aux magnétosphères planétaires publié en 2007, et toujours d’actualité [2]. On se contentera donc ici de rappeler qu’une magnétosphère est formée par l’interaction entre le vent solaire (ou stellaire), ce vent de particules chargées électriquement (on parle de plasma) émis en permanence par le Soleil à des vitesses moyennes d’environ 400 km/s, et le champ magnétique planétaire. Elle forme une cavité dans le milieu interplanétaire, comprimée par le vent solaire côté jour et allongée côté nuit, où les mouvements du plasma sont organisés par le champ magnétique planétaire. Propriété remarquable, une magnétosphère agit comme un gigantesque accélérateur de particules avec une intense activité électrique dont on peut mesurer, en bout de chaîne, la réponse aurorale, comme schématisé sur la figure 2.

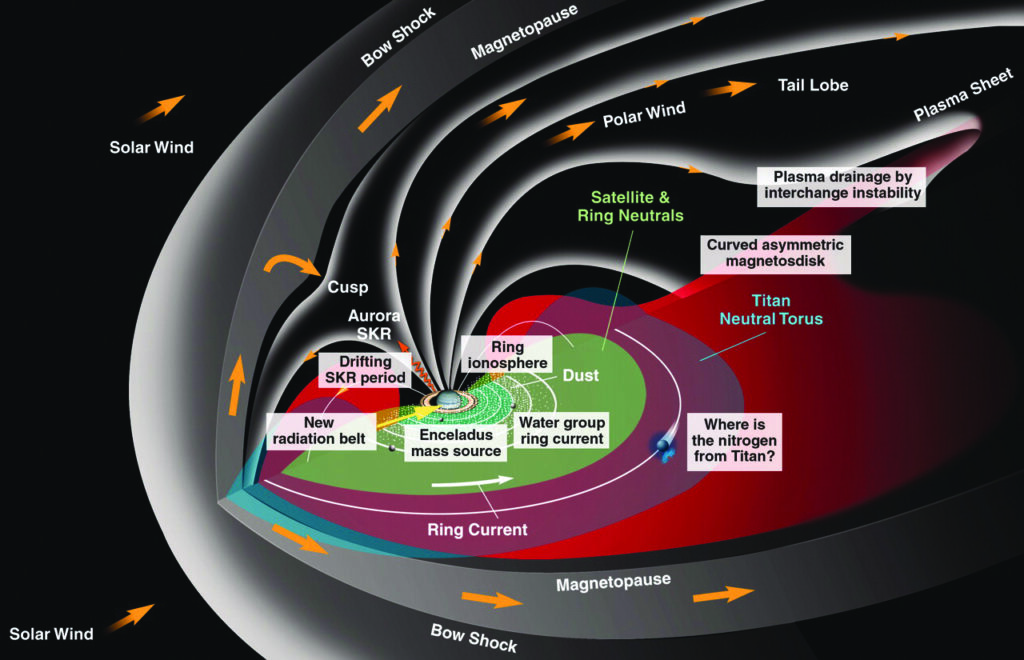

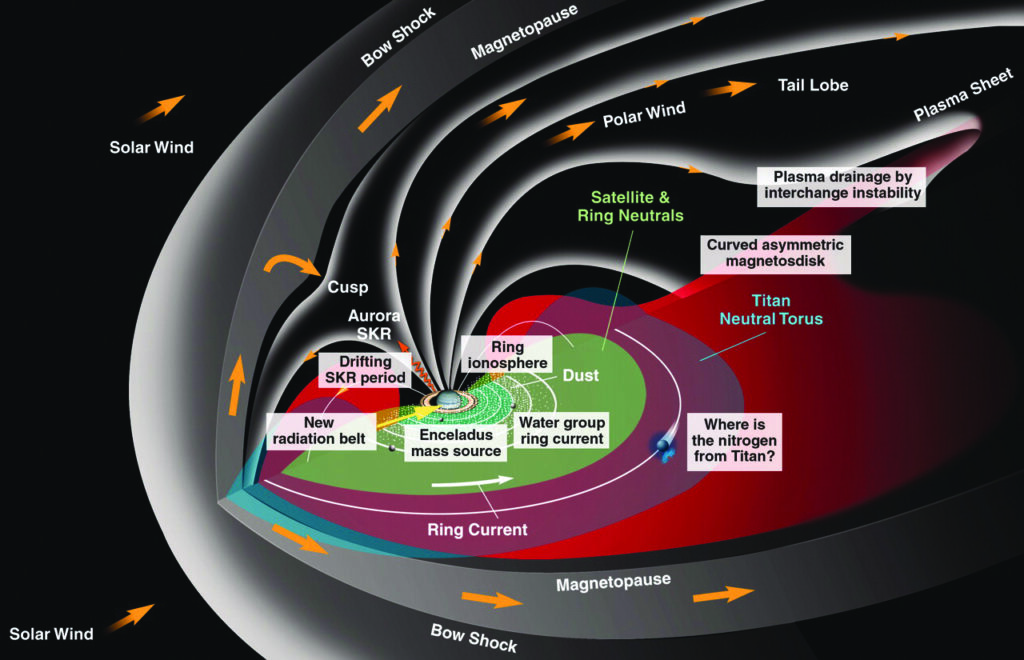

La magnétosphère de Saturne, schématisée sur la figure 3, a été découverte par des mesures magnétiques lors du survol de la sonde Pioneer 11 en 1979, avant d’être explorée par les survols successifs des sondes Voyager 1 et 2 en 1980 et 1981, puis caractérisée en détail lors du tour orbital de la sonde Cassini entre 2004 et 2017, dont l’ultime phase, une série d’orbites polaires rapprochées sobrement baptisée « le Grand Finale » (dont le e final garde la trace sémantique de son origine, un hommage à l’opéra italien), s’est conclue par la spectaculaire plongée de la sonde dans l’atmosphère planétaire le 15 septembre 2017 [3].

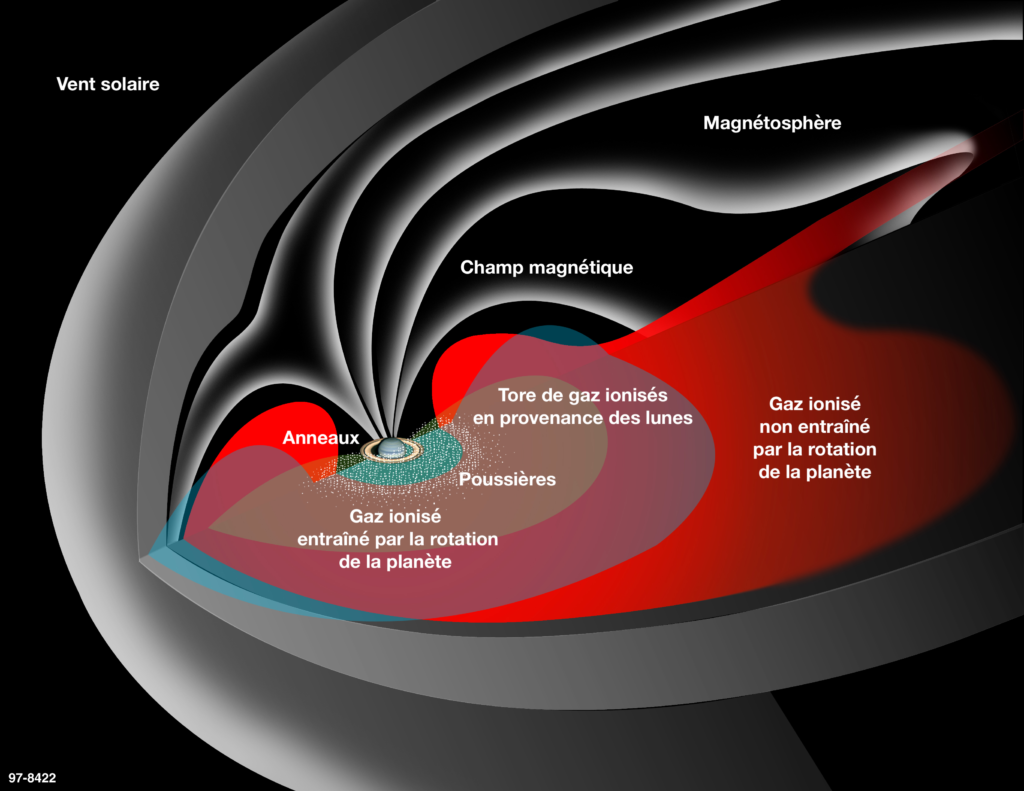

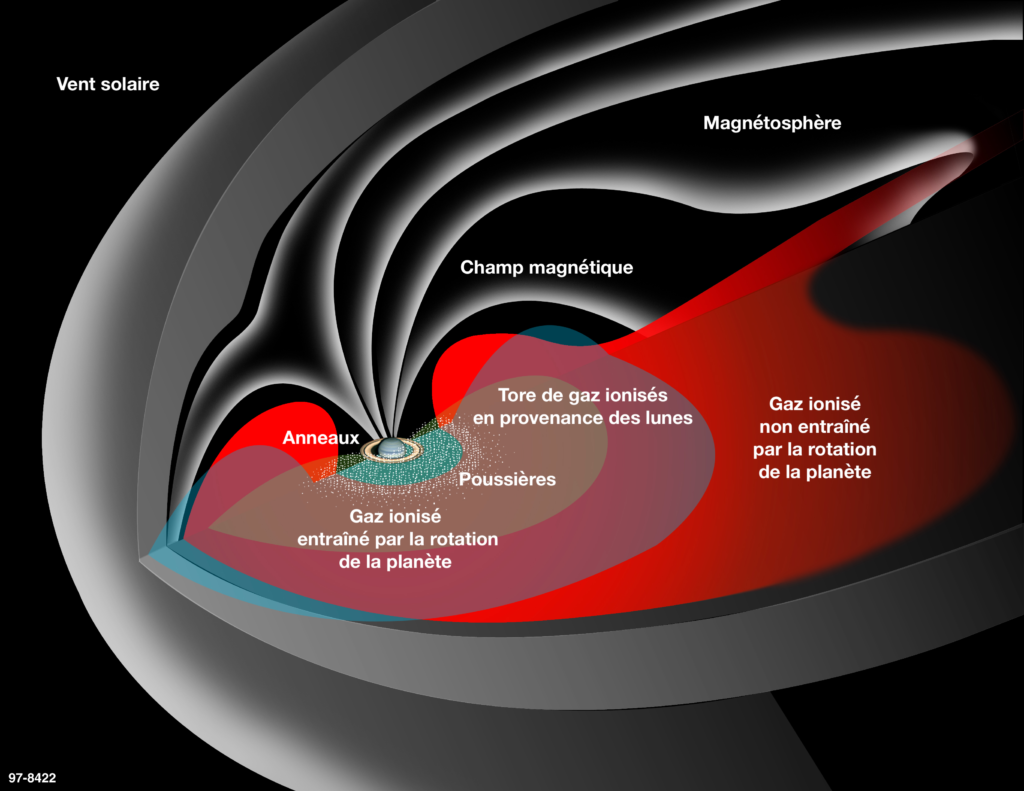

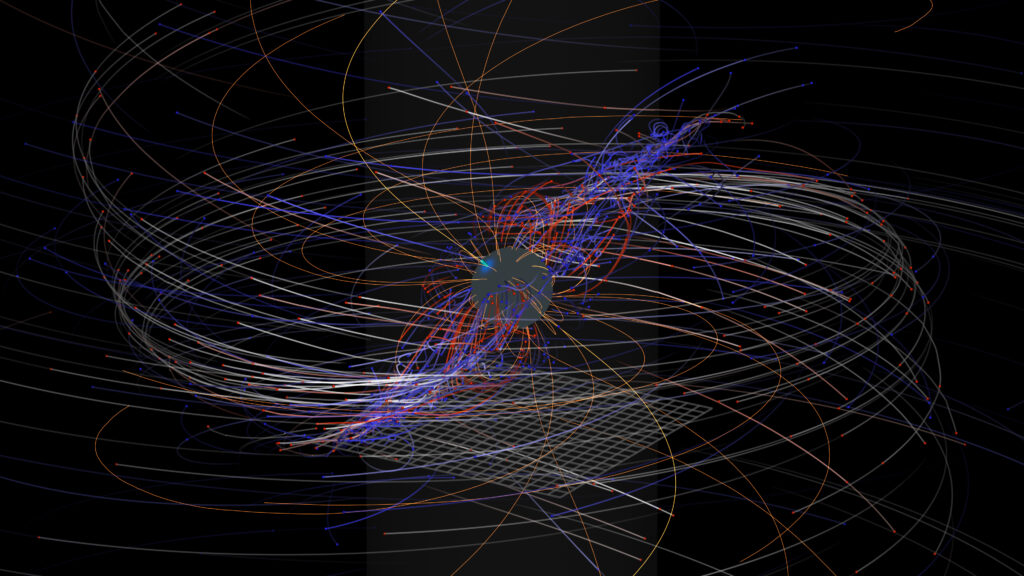

3. schéma de principe de la magnétosphère de saturne et des processus complexes qu’elle héberge. Les émissions aurorales sont produites au- dessus des pôles magnétiques.

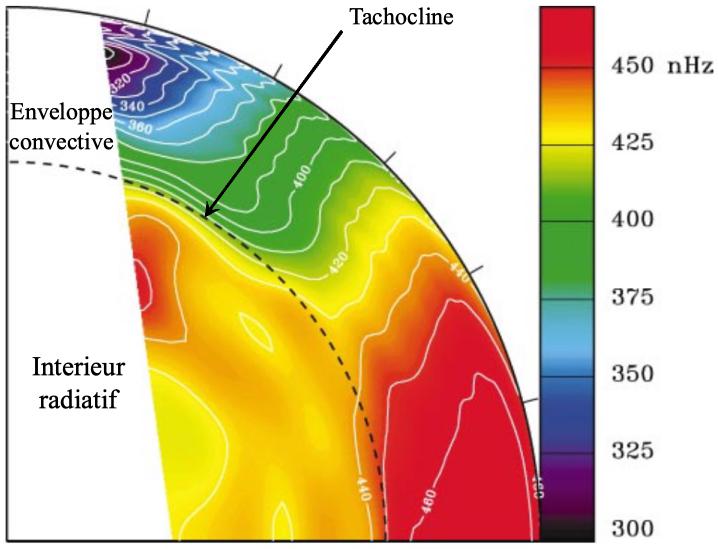

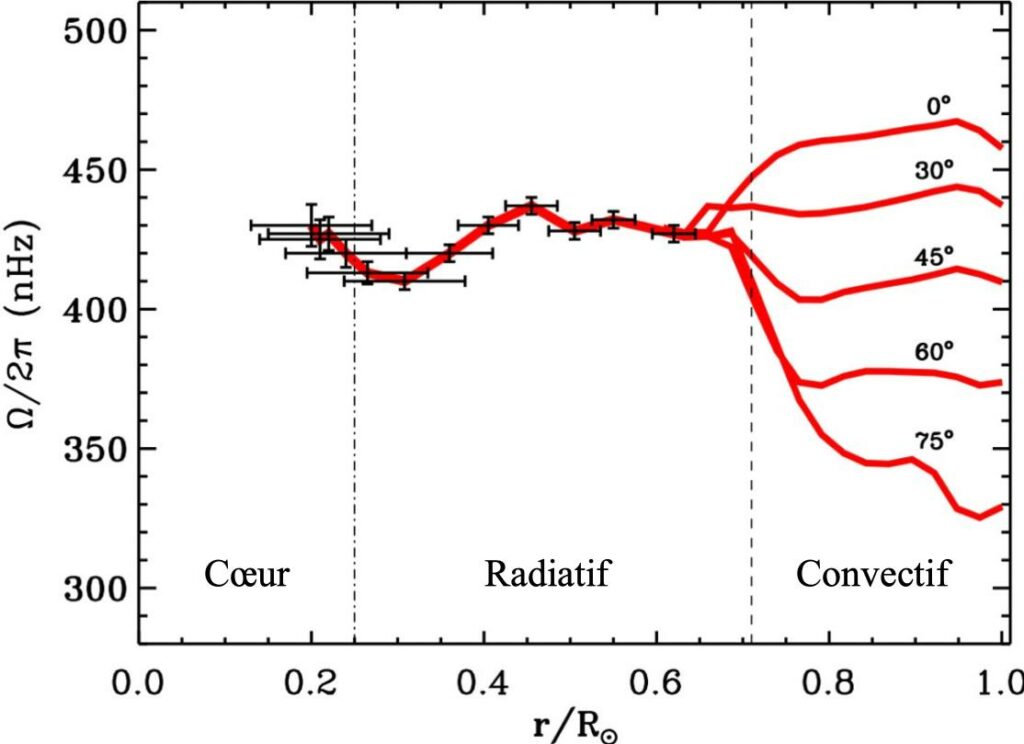

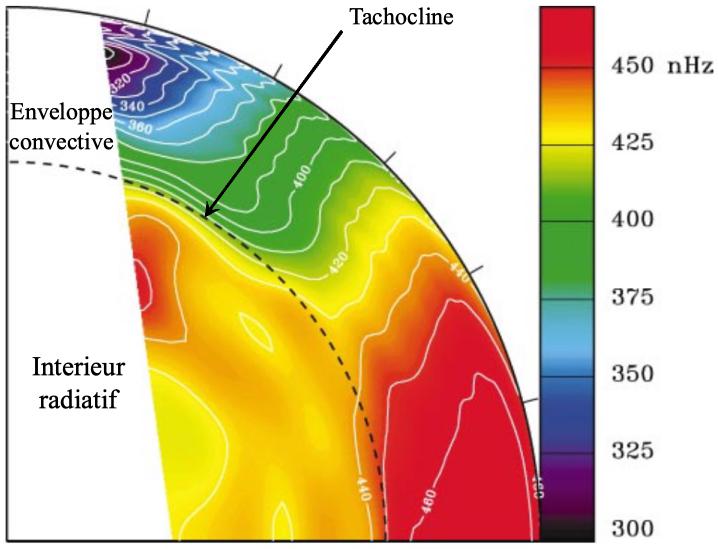

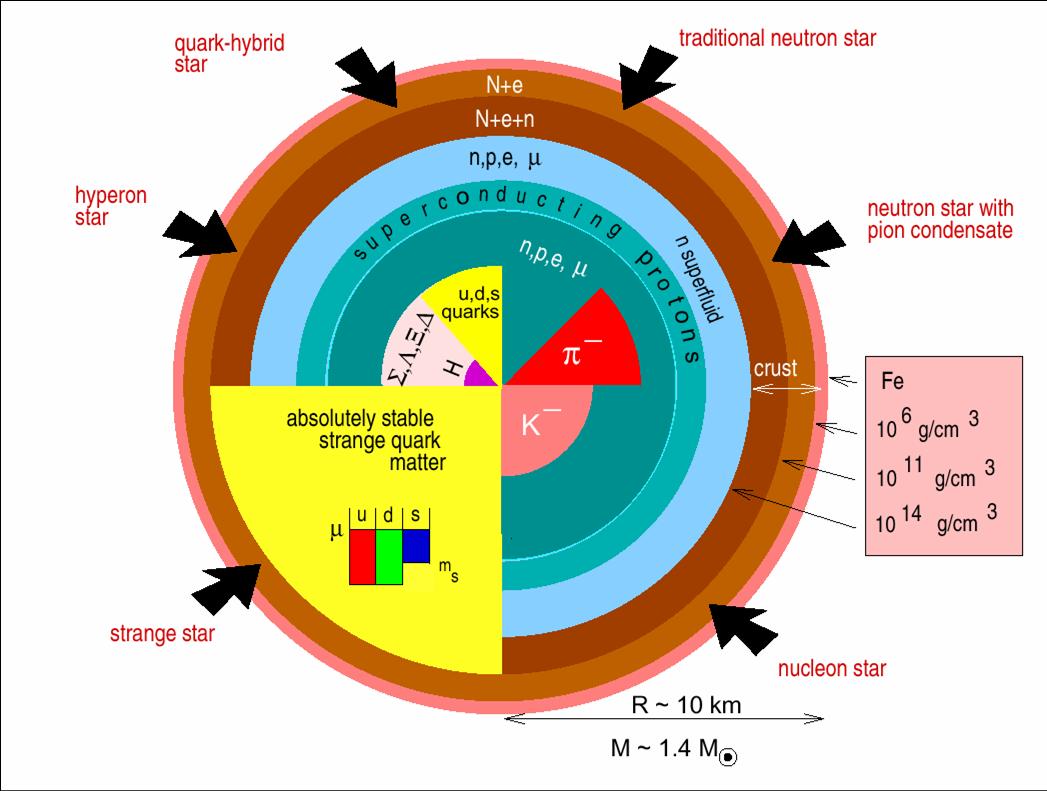

Les mesures du champ magnétique ainsi obtenues au plus près de la planète ont d’abord permis de confirmer une particularité unique de Saturne dans le Système solaire : son axe magnétique est confondu avec son axe de rotation (avec un écart angulaire < 0,0095° !). Cela rend la magnétosphère symétrique et les théoriciens perplexes, car un angle significatif (observé sur toutes les autres planètes magnétisées) est nécessaire pour générer un champ magnétique stable par effet dynamo. Saturne possède également un champ magnétique comparable à celui de la Terre (0,2 gauss en surface à l’équateur, contre 0,3 gauss pour la Terre), mais est dix fois plus éloignée du Soleil. Il en résulte une magnétosphère sensible au vent solaire et très étendue, atteignant 20 rayons planétaires (un rayon équatorial kronien [Note 2] mesure 60 268 km) côté jour et plusieurs centaines de rayons planétaires côté nuit. Autre fait d’importance, Saturne tourne rapidement, avec une période de rotation inférieure à 11 heures, ce qui affecte directement la circulation du plasma dans la magnétosphère. Soumis à la force centrifuge mais contraint de suivre les lignes de champ magnétique, le plasma s’accumule le long d’un disque près de l’équateur magnétique. Enfin, et découverte majeure de la première partie de la mission Cassini, sa principale source de plasma est le satellite de glace Encelade, dont les panaches de matière glacée alimentent la magnétosphère à hauteur d’environ 100 kg de plasma par seconde, ce qui donne naissance à un tore le long de l’orbite de la lune, distante de 4 rayons kroniens. Ces propriétés font de la magnétosphère de Saturne un objet astrophysique complexe, à la fois un cas intrinsèquement très particulier d’une part, et à mi-chemin entre la Terre (champ modéré, pas de source de plasma interne, rotation lente) et Jupiter (champ magnétique élevé, Io comme source principale de plasma, rotation rapide) d’autre part.

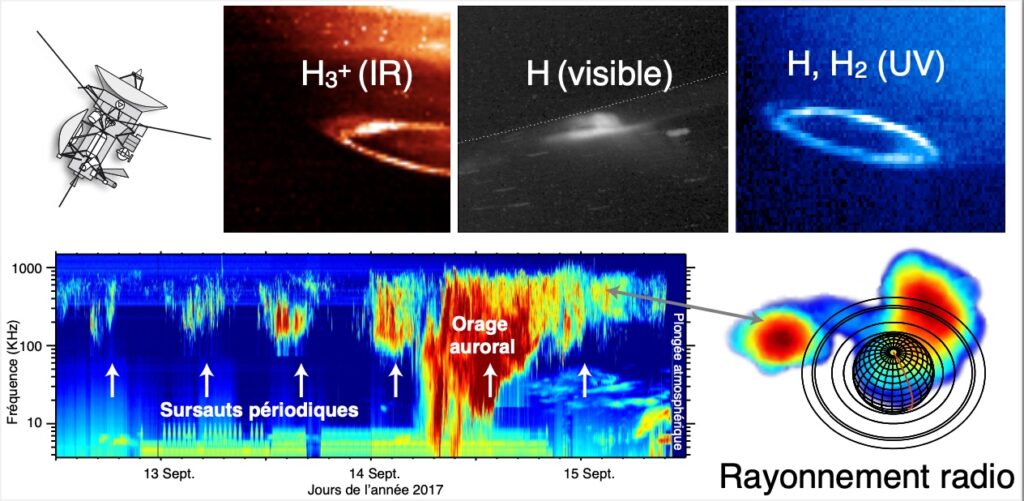

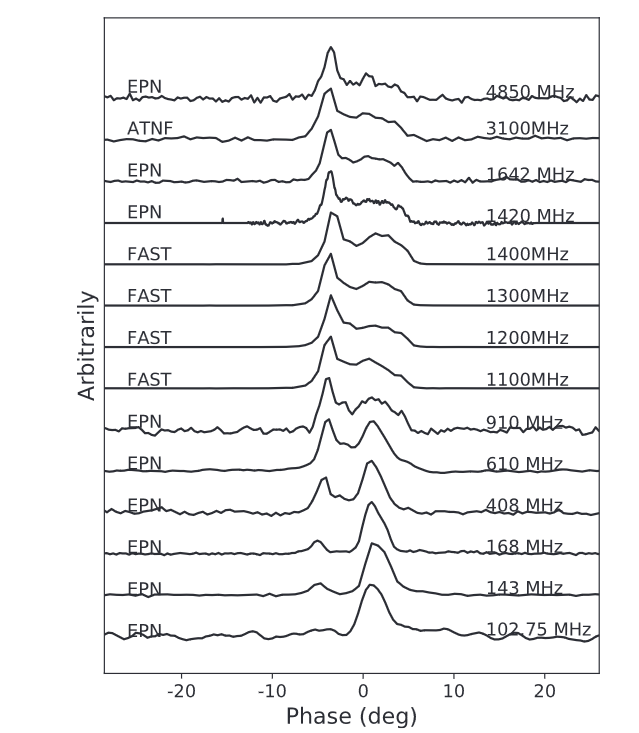

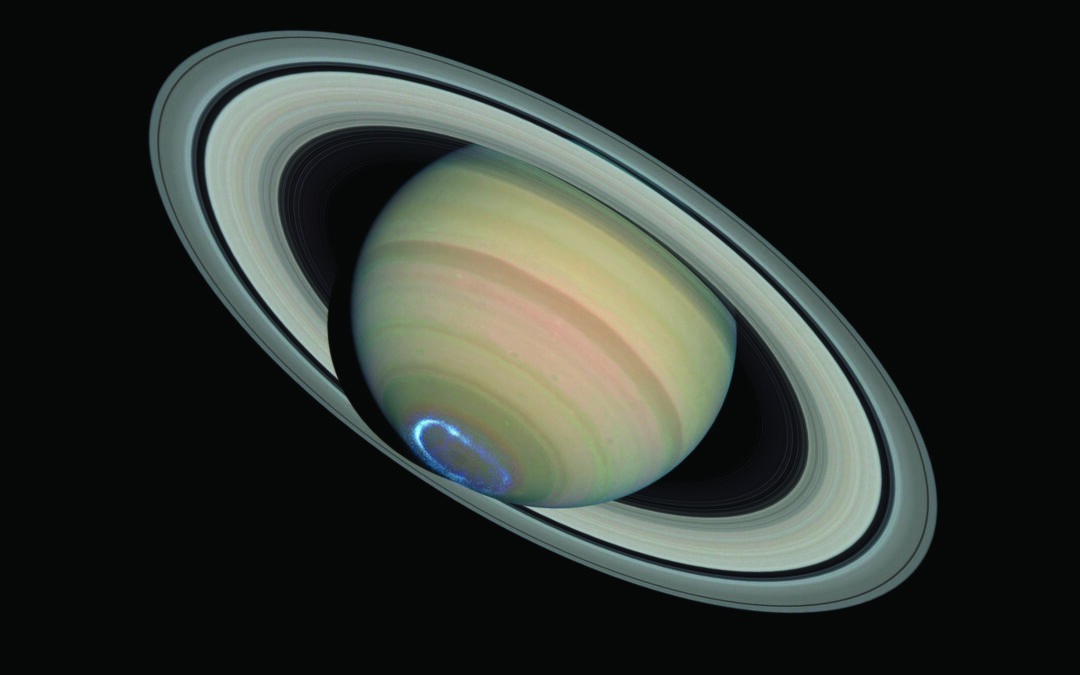

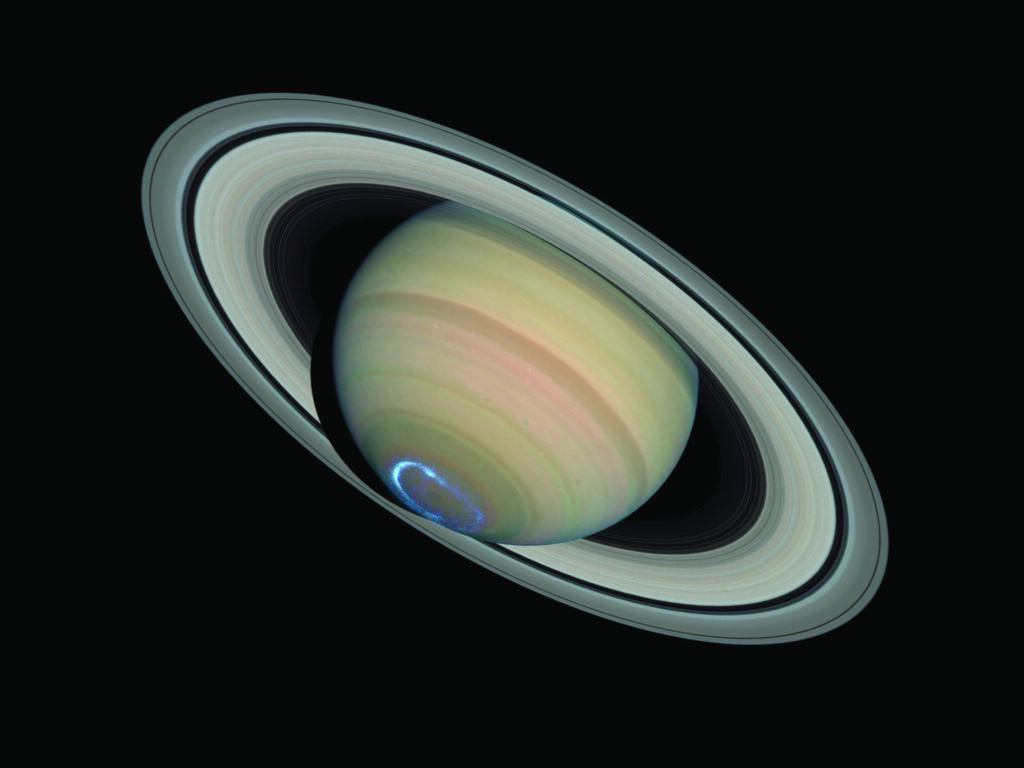

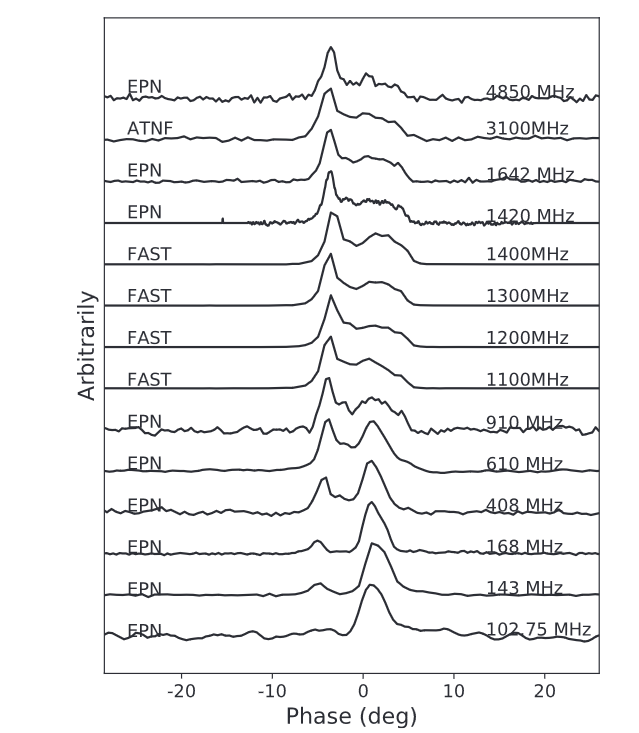

Les aurores de Saturne ont été essentiellement observées dans les domaines UV (par les observatoires spatiaux IUE, Voyager, Hubble puis Cassini) et radio (par les sondes Voyager, Ulysse et Cassini), mais aussi plus récemment dans le proche IR (par des télescopes au sol et Cassini) et tout dernièrement dans le visible (par Cassini uniquement car, dans ce domaine de fréquences, il faut pouvoir observer les aurores du côté nuit avec un contraste suffisant vis-à-vis de la contribution de l’atmosphère, comme sur Terre). Malgré plusieurs tentatives, aucune émission X n’a été détectée à ce jour, probablement en raison d’un niveau d’émission trop faible pour la sensibilité des télescopes actuels ou à cause d’une faible activité aurorale coïncidant avec les observations (les planètes savent se montrer facétieuses). Ces différents domaines spectraux sondent des processus d’émission variés et nous fournissent des informations riches et complémentaires.

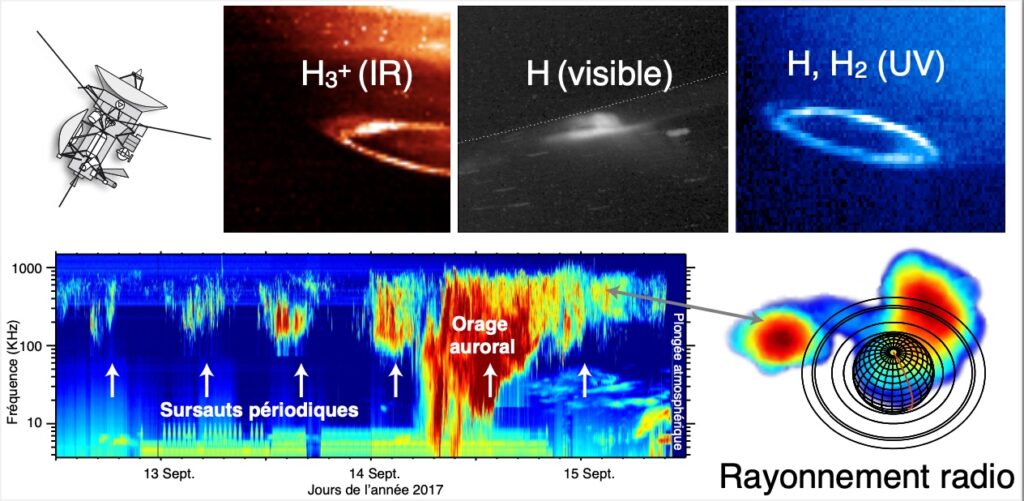

4. images des émissions aurorales UV, ir (observées le 27 janv. 2009), visible (observées le 27 nov. 2011) et radio (le spectre dynamique degaucheaétéobtenudu12au15sept.2017, l’image radio de droite a été obtenue le 7 mars 2017) de saturne en fausses couleurs par les spectro-imageurs UVis, iss, Vims et rPWs de la sonde Cassini. (NASA/ESA, L. Lamy, LESIA/Obs. de Paris/CNES

Des aurores colorées

La fenêtre UV (ou visible) bénéficie d’une excellente résolution angulaire propice aux images. Elle sonde la réponse instantanée de la haute atmosphère neutre aux précipitations aurorales avec les transitions électroniques des espèces dominantes H et H2 entre 80 et 160 nm (ou la raie de Balmer rouge de H). Outre une mesure directe de l’énergie rayonnée, l’analyse des spectres UV permet aussi de déterminer la profondeur de pénétration des électrons énergétiques et ainsi leur énergie. La fenêtre proche IR permet de mesurer la réponse de la haute atmosphère ionisée avec les raies de la molécule H3+ entre 3 et 5 μm, sensibles à la température. Ces observations « optiques » sont acquises lors de séquences d’observations discontinues, souvent espacées dans le temps. Hubble a ainsi observé régulièrement les aurores UV de Saturne lors

de plus de 15 programmes d’observations étalées de 1994 à 2017. Une illustration des aurores UV, visible et IR de Saturne observées par les spectro-imageurs de la mission Cassini est visible en haut de la figure 4.

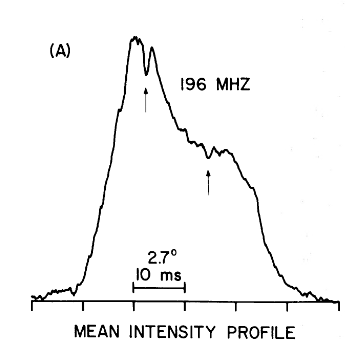

Les émissions radio aurorales couvrent la gamme basse fréquence s’étalant de 1 kHz à 1 MHz et ne peuvent donc être observées que depuis l’espace (l’atmosphère terrestre est opaque aux fréquences inférieures à 10 MHz). Elles résultent d’un mécanisme bien connu des radioastronomes, fondé sur l’amplification d’ondes par des électrons en mouvement circulaire (giration cyclotron) dans le champ magnétique de Saturne. Ces émissions radio se produisent au-dessus de l’atmosphère jusqu’à quelques rayons planétaires de distance le long de lignes de champ magnétique connectées, à plus basse altitude, aux aurores atmosphériques. Les observations radio à basse fréquence, donc grande longueur d’onde, ne fournissent généralement pas directement d’images, mais peuvent mesurer le spectre radio en continu pendant de longues périodes de temps, comme représenté sur le spectre « dynamique » en bas à gauche de la figure 4. Néanmoins, une technique de mesure sophistiquée mise en œuvre sur l’instrument radio embarqué sur Cassini a permis de réaliser les premières « images » d’émissions radio planétaires, telle celle en bas à droite de la figure 4. Elle montre non seulement que les sources radio aurorales sont bien localisées le long des lignes de champ de haute latitude, mais permet d’interpréter finement la richesse des structures observées dans le spectre dynamique.

Vingt-sept ans après la détection des aurores de Saturne, que nous ont-elles appris sur la planète et son environnement ?

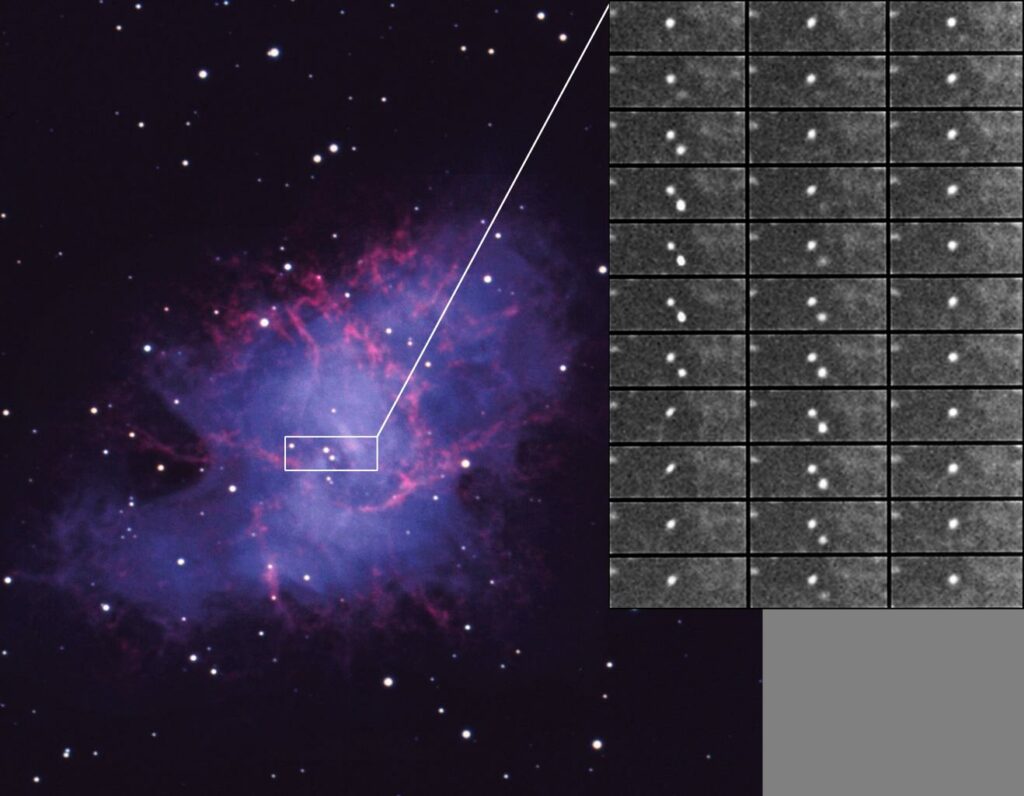

5. Évolution temporelle de la résolution spatiale des observations des aurores ultraviolettes de saturne réalisées avec différentsspectro-imageursdeHubble(de performance croissante) et l’instrument Cassini/UVis (à des distances d’observation de plus en plus proches de la planète). Les images sont tracées en fausses couleurs. (NASA/ESA, APIS [5] et W. Pryor, LASP/Central Arizona College)

Des origines multiples

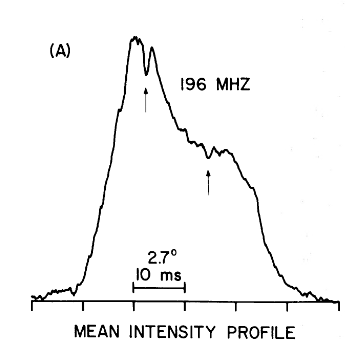

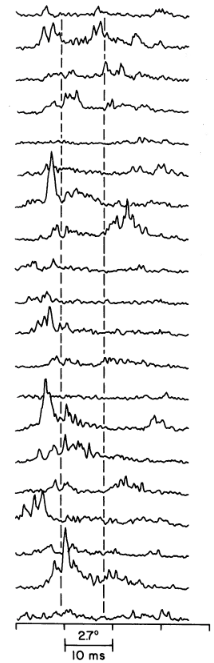

Les sondes Voyager 1 et 2 ont d’abord révélé le rayonnement radio (kilométrique) auroral, observé jusqu’à quelques unités astronomiques (UA) de distance, et montré qu’il est très variable à deux échelles de temps. Le spectre dynamique radio de la figure 4 (qui montre les ultimes observations Cassini, obtenues trois décennies plus tard) illustre que ce rayonnement est d’abord modulé à une période stable (flèches blanches), proche de la variété de périodes de rotation des nuages. Cette période radio de presque 11 heures a servi à définir la période de rotation interne, dont nous reparlerons plus loin. L’activité radio varie ensuite fortement avec le vent solaire, s’intensifiant au passage de chocs interplanétaires qui compriment la magnétosphère (épisodes « d’orages auroraux » comme celui visible sur la figure 4) jusqu’à s’éteindre complètement quand le vent solaire est « coupé », comme l’observa la sonde Voyager 2 en 1981 lorsque Saturne fut exceptionnellement plongée dans la queue de la magnétosphère de Jupiter, située 5 UA plus près du Soleil !

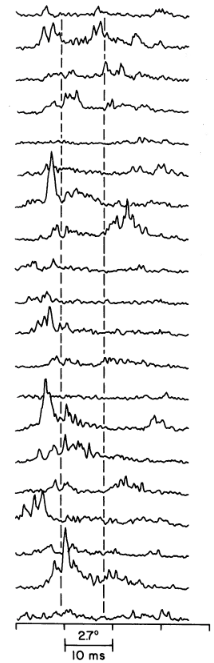

Voyager a aussi détecté les aurores atmosphériques avec son spectromètre UV, et montré que leur activité était corrélée à celles des émissions radio, mais il a fallu attendre Hubble pour en obtenir les premières images. Sur la figure 5, on distingue un ovale auroral prédominant, plus intense du côté matin (du côté gauche des images prises par Hubble depuis la Terre). Il s’intensifie parfois soudainement avec des émissions remplissant l’ovale du côté matin (comme sur les images prises en 2000 et 2004 de la figure 5) avant de revenir progressivement à sa forme circulaire et son intensité initiales au fur et à mesure de la rotation planétaire. Si l’on suit les lignes de champ magnétique associées, pour remonter la trajectoire des particules causant les aurores, on parvient aux parties les plus externes de la magnétosphère, qui sont en contact avec le milieu interplanétaire. Les émissions aurorales UV et radio ont ainsi été imputées à l’interaction variable de la planète avec le vent solaire [4]. Cette interaction est analogue à celle qui prévaut dans le cas terrestre, mais suit un scénario différent. Les lignes de champ magnétique connectées à l’ovale auroral principal forment une frontière au travers de laquelle le mouvement global du plasma change brutalement : on parle de cisaillement de vitesse. Celui-ci a lieu entre les lignes de champ magnétique dites « fermées » (connectées aux deux pôles de la planète et qui tournent avec elle) et les lignes dites « ouvertes » (connectées à un seul pôle et emportées du côté jour vers le côté nuit par le vent solaire). Ce cisaillement produit – en vertu de la loi d’Ampère – un courant électrique à grande échelle qui circule le long des lignes de champ aurorales pour se refermer dans la haute atmosphère ionisée de Saturne. On parle de courant « aligné » avec les lignes de champ, l’équivalent des courants de Birkeland terrestres. À haute latitude, comme on l’a vu, la densité de plasma, dominée par les électrons (les ions, plus lourds, étant confinés à l’équateur), est faible et la continuité du courant nécessite d’accélérer les électrons ambiants restants [Note 3]. Dans le cas de Saturne, l’énergie cinétique mesurée des électrons ainsi accélérés qui précipitent dans l’atmosphère varie de 1 à 20 kiloélectronvolts [Note 4] d’une région à l’autre des aurores. L’arrivée de ces électrons énergétiques aux pôles magnétiques à toutes les longitudes permet d’expliquer l’ovale circumpolaire observé. L’intensification des aurores côté matin correspond dans ce scénario à un cisaillement de vitesse maximal, donc une accélération d’électrons plus efficace.

La résolution croissante des observations Hubble et l’arrivée de Cassini en orbite, jusqu’à l’extrême précision des images obtenues pendant le Grand Finale représentées sur la figure 5, ont révolutionné cette vision. L’ovale auroral, qu’on appellera désormais plus modestement ovale principal, n’est pas une structure continue, ni même toujours avec une forme d’ovale, mais morcelée en une grande variété de régions actives variables temporellement jusqu’à l’échelle de la minute qui signalent des processus complexes et dynamiques à petite échelle dans la magnétosphère [6]. En dehors de cet ovale coexistent trois grandes catégories d’émission.

À plus basse latitude, on trouve un ovale secondaire (initialement découvert sur l’image Hubble du 26 janvier 2004 de la figure 5 et bien visible sur celles de Cassini prises ultérieurement), peu variable et d’intensité beaucoup plus faible. Il a été attribué à la précipitation dans l’atmosphère d’une population d’électrons « chauds » (d’énergie ~1 keV) présente en permanence dans la partie de la magnétosphère la plus proche de Saturne. À plus haute latitude, on trouve des taches ou des arcs transitoires brillants. Ces émissions ont été directement reliées à l’interaction entre la magnétosphère et le vent solaire par un processus de reconnexion magnétique entre les lignes de champ planétaire et interplanétaire du côté jour de la magnétosphère capable de transférer de l’énergie aux particules. Ce type de signatures intermittentes, qui permet de cartographier de manière dynamique la portion de la magnétosphère ouverte sur le vent solaire, est l’équivalent des aurores peu intenses de cornet polaire (le cornet polaire, nommé cusp en anglais, est indiqué sur la figure 3) régulièrement observées sur Terre.

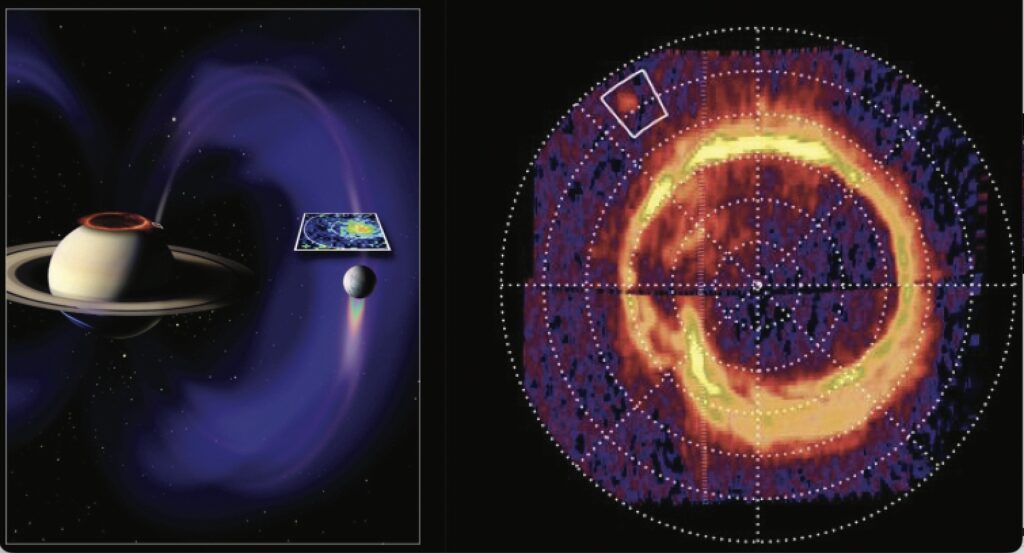

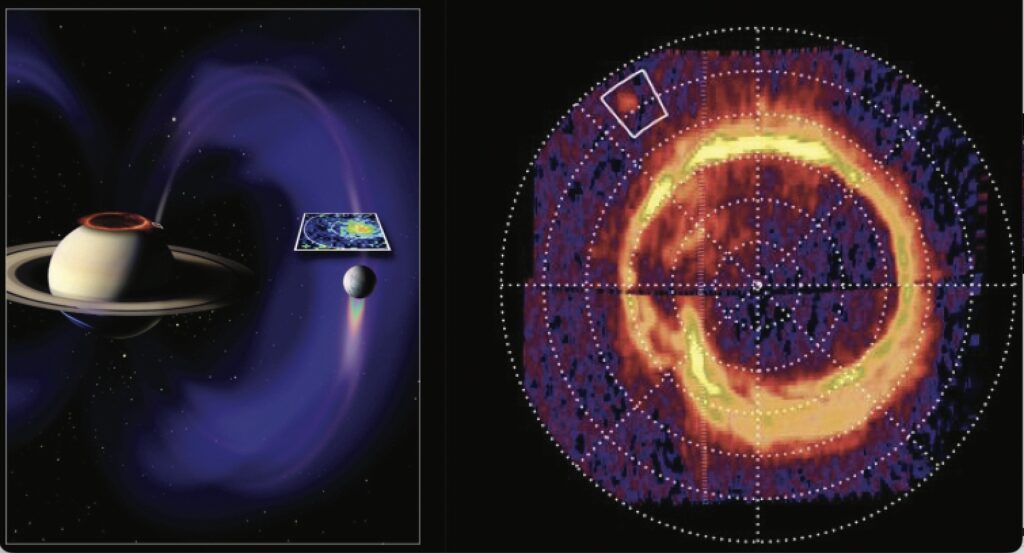

Enfin, une dernière composante aurorale a été identifiée sur seulement trois images UV de toute la mission Cassini, dont l’une, prise en 2008, est représentée sur la figure 6. Il s’agit d’une tache située exactement au « pied » magnétique de la lune Encelade : autrement dit, remonter la ligne de champ associée à cette tache aboutit au satellite. Ce type de signature est bien connu sur Jupiter, où des taches brillantes semblables sont associées aux lunes Io, Ganymède et Callisto. L’empreinte aurorale d’Encelade révèle une interaction planète-satellite qui prend la forme d’un autre système de courant électrique « aligné », généré par le déplacement de la lune dans le champ magnétique de la planète et se refermant le long des lignes de champ de haute latitude, où il peut à nouveau accélérer les électrons froids ambiants. Jusqu’à cette découverte, les interactions planète-satellite étaient l’apanage du système de Jupiter. Le cas Saturne-Encelade révèle un processus universel, avec des caractéristiques très différentes (émission faible et très variable).

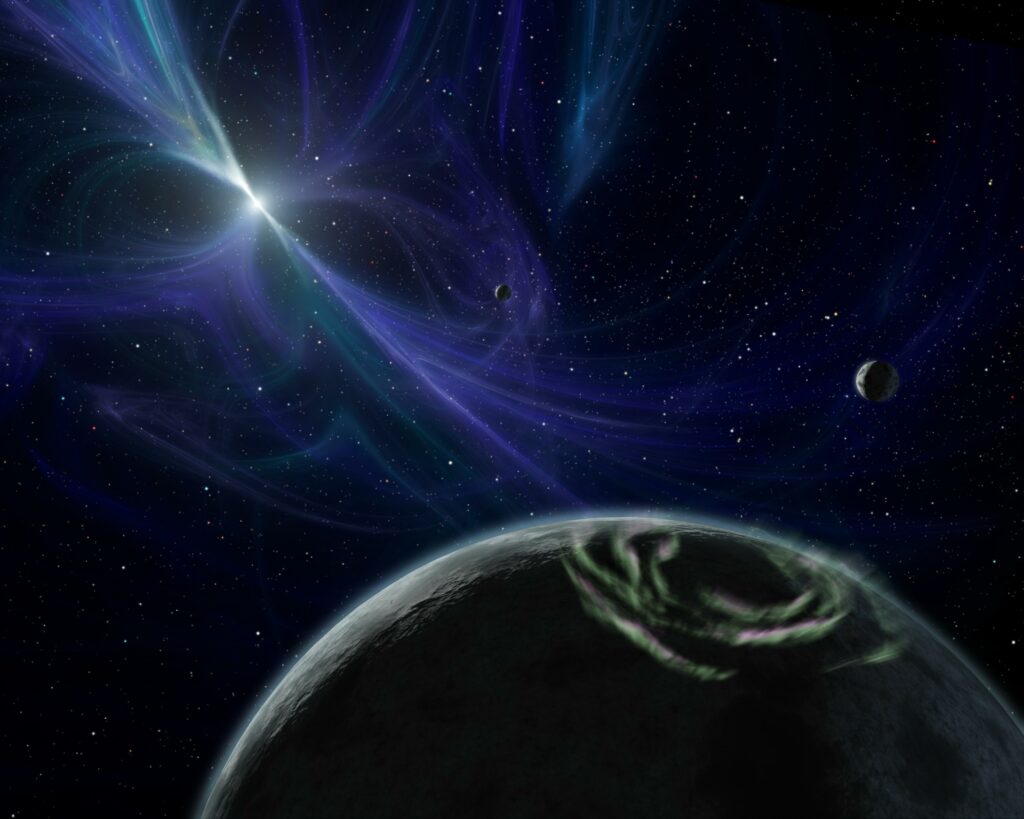

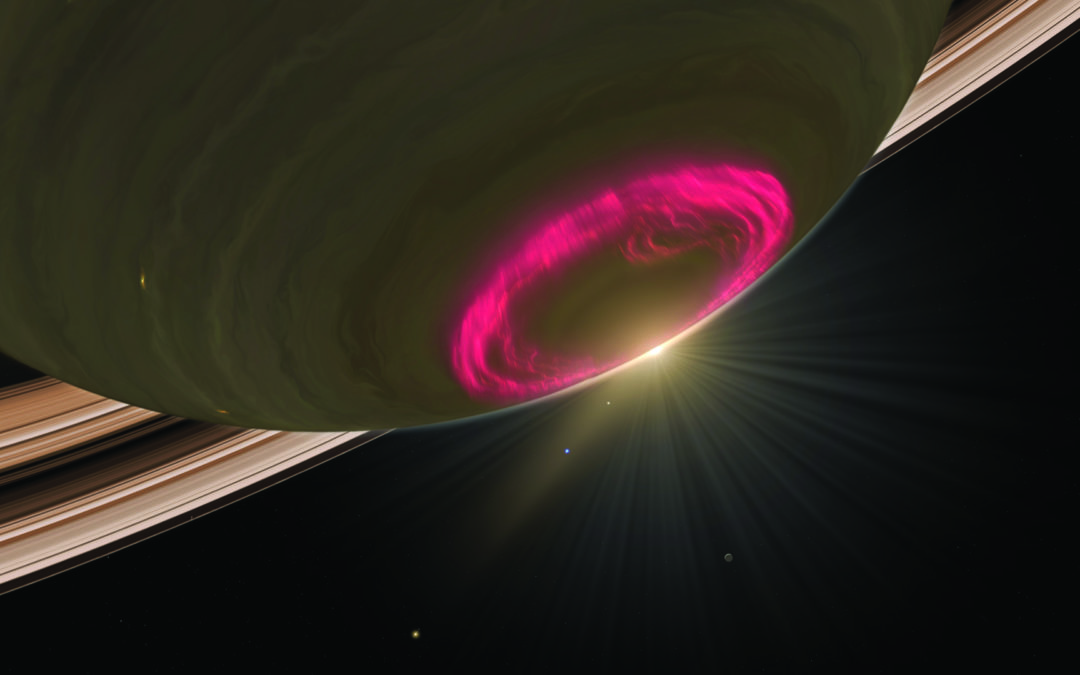

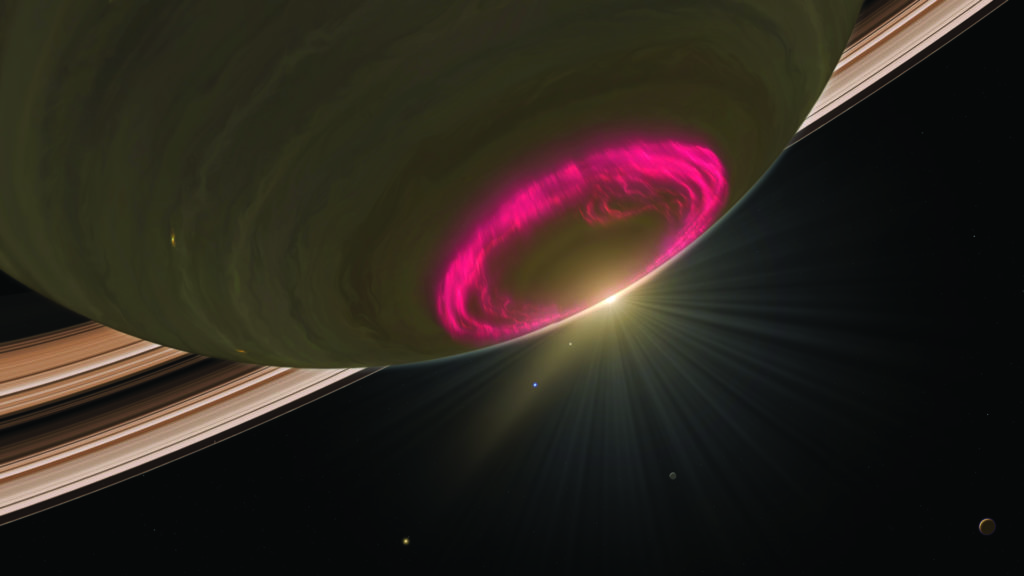

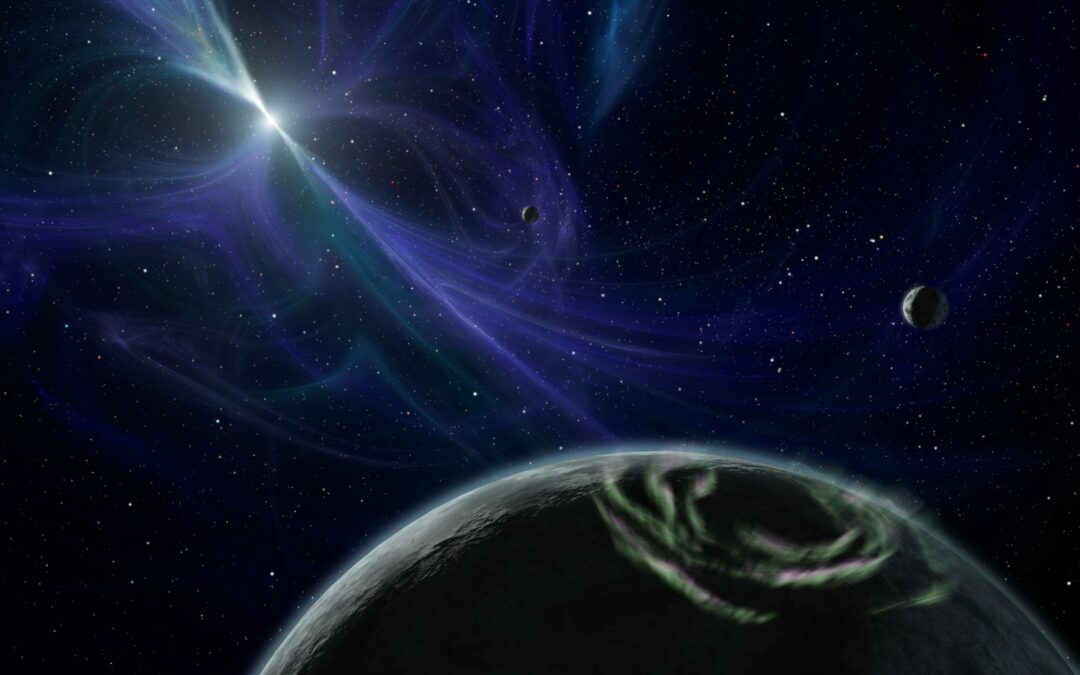

6. (À gauche) image d’artiste associant une observation UV à distance de Cassini/UVis et une observation de particules énergétiques au-dessus d’encelade de l’instrument Cassini/inCA à quelques semaines d’intervalle. (À droite) Projection polaire de l’observation UV. en dehors des aurores intenses autour du pôle, une tache (encadrée en blanc) indique l’empreinte aurorale d’encelade.

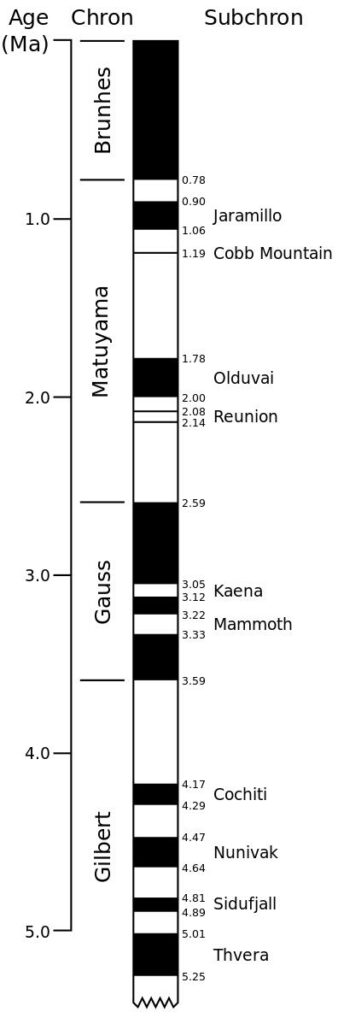

Le mystère de la longueur du jour

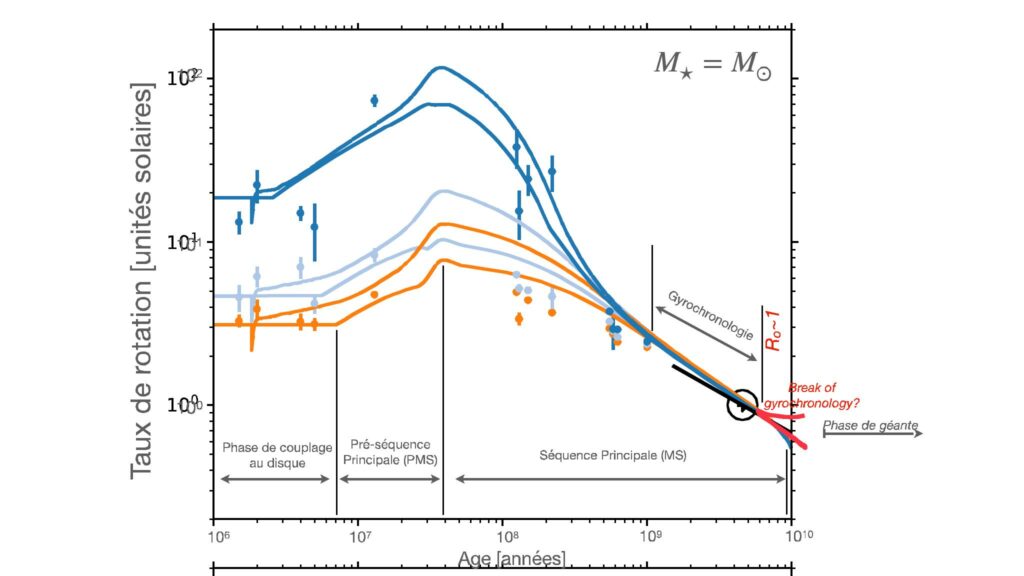

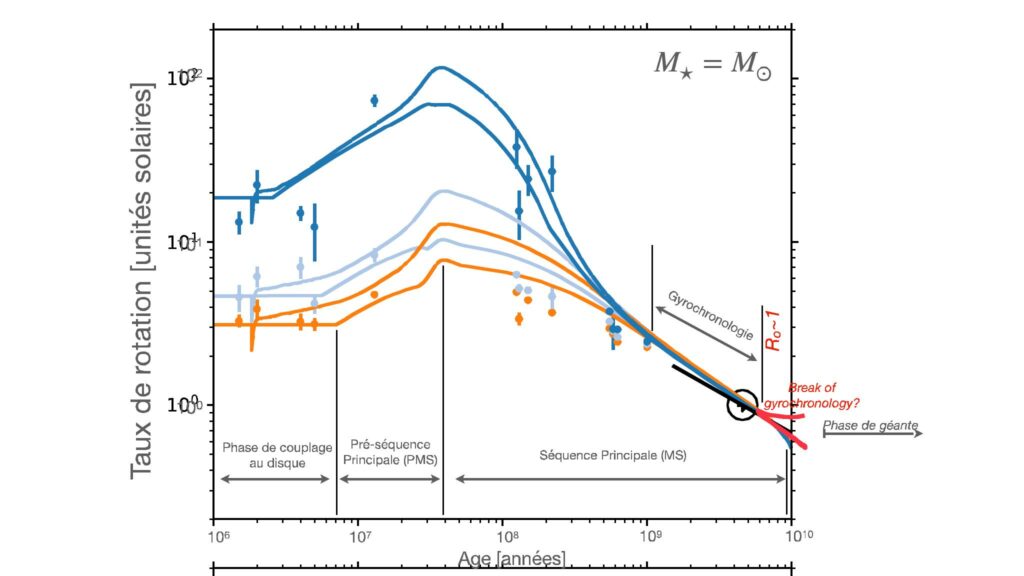

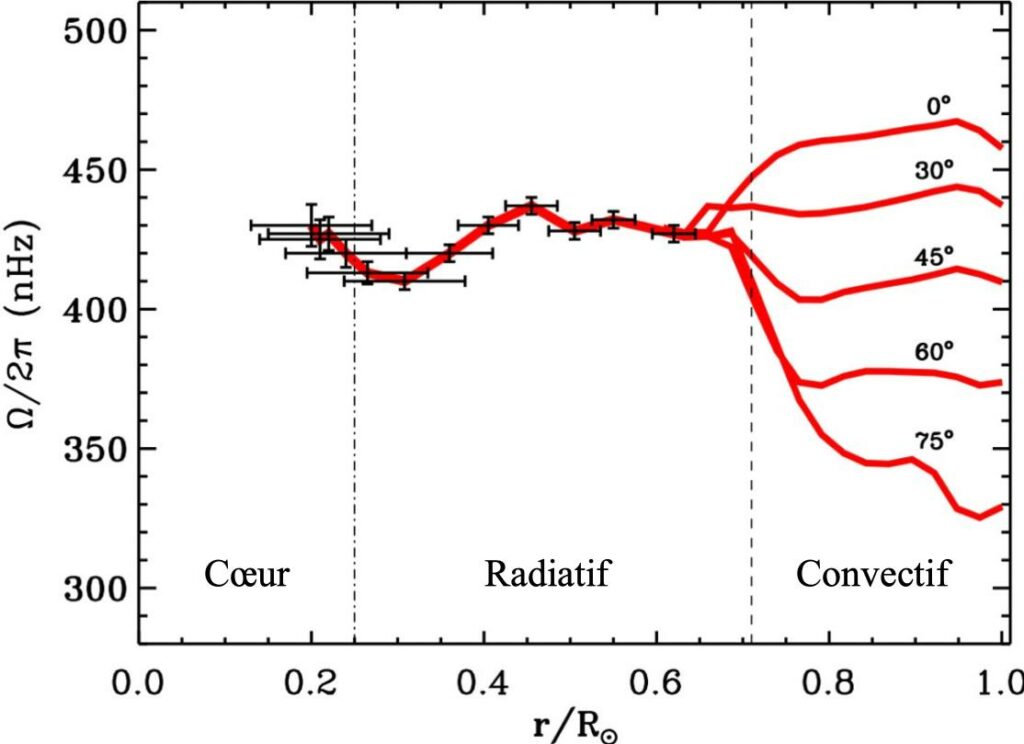

Une question qui reste largement incomprise à l’issue de la mission Cassini forme un sujet d’étude majeur depuis Voyager : la détermination de la période de rotation interne de Saturne [7]. Contrairement aux planètes rocheuses, il n’y a pas de repère fixe à suivre à la « surface » des planètes géantes où les nuages se déplacent le long de bandes de latitude à des vitesses différentes. Pour identifier la période de rotation interne, une alternative est de mesurer la période de modulation d’une observable liée au champ magnétique, lui-même formé dans le cœur planétaire. Les émissions radio ont été le diagnostic le plus utilisé, étant observables à distance et continûment pendant de longues périodes de temps. Les périodes radio mesurées pour les quatre planètes géantes (parfois vérifiées à l’aide d’autres mesures in situ) ont ainsi été officiellement adoptées comme périodes de rotation par l’Union astronomique internationale.

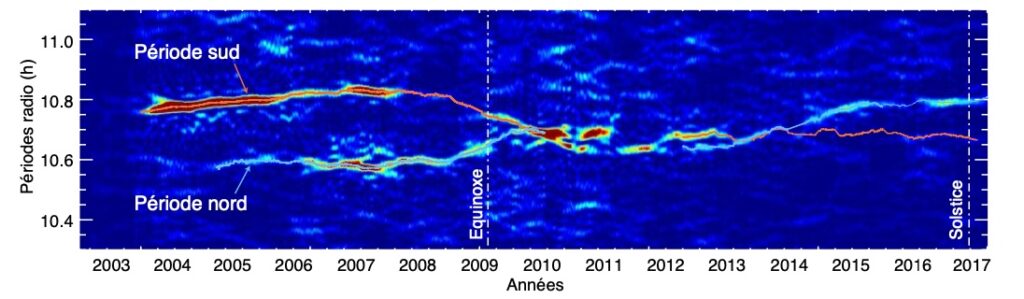

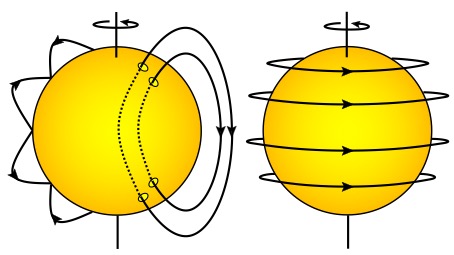

Cependant, l’existence même d’une période radio pour Saturne (séparant les sursauts radio réguliers indiqués par les flèches blanches sur le spectre dynamique de la figure 4) pose déjà un premier problème. Alors que l’angle entre l’axe de rotation et l’axe magnétique des autres géantes est significatif (d’une dizaine de degrés ou plus), ce qui conduit à interpréter la modulation radio observée par un observateur fixe comme un phare tournant, celui de Saturne est nul et ne devrait pas induire de modulation rotationnelle des émissions. Les observations à distance des sondes Ulysse dans les années 1990, puis Cassini à partir de 2003 ont révélé deux problèmes supplémentaires.

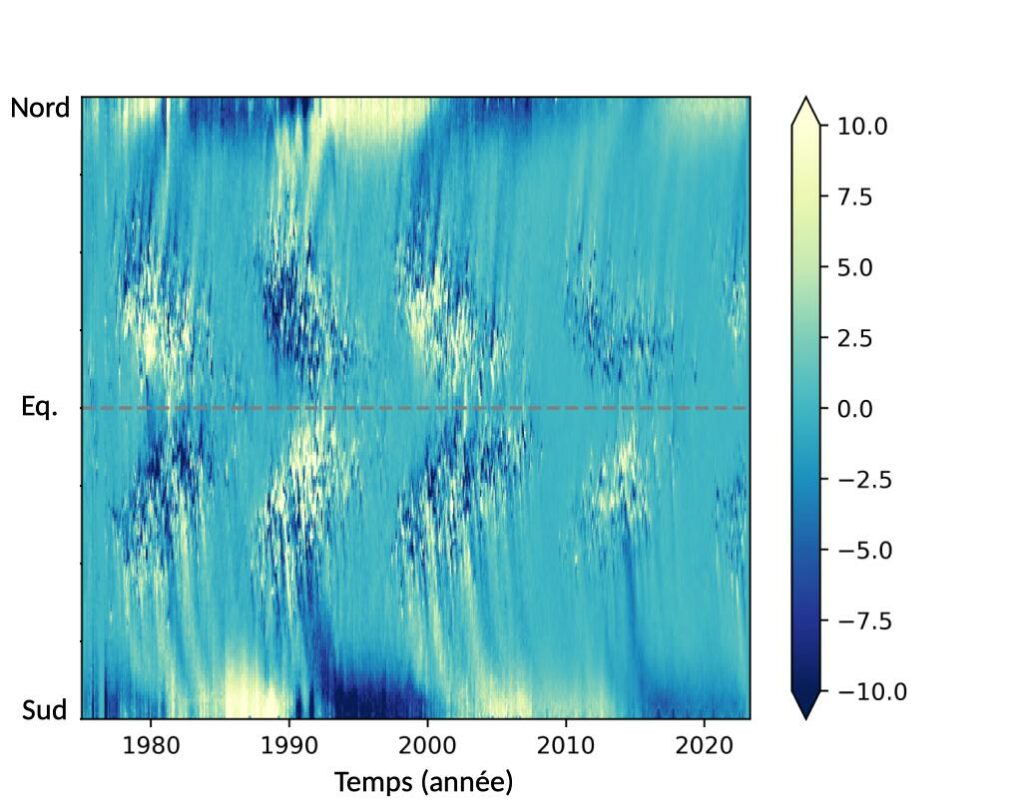

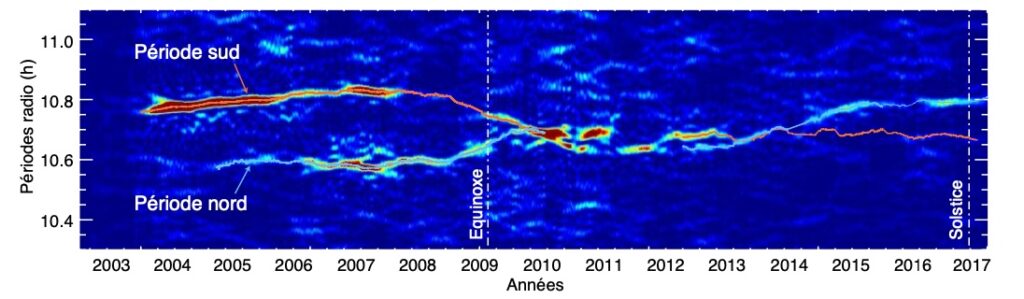

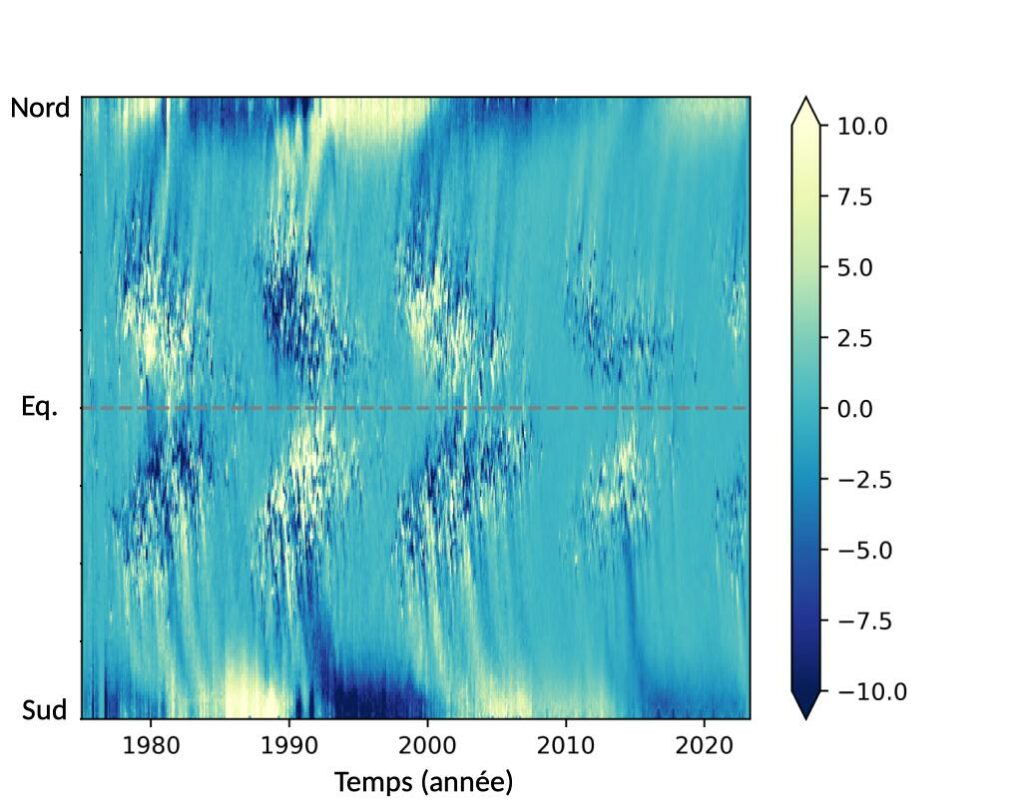

D’abord, la période radio mesurée varie d’environ 1 % à l’échelle de quelques années, une variation trop grande pour s’expliquer par une accélération ou un ralentissement du cœur planétaire. Ensuite, Saturne ne dispose pas d’une, mais de deux périodes radio, chacune correspondant à un hémisphère. Ces deux périodes radio varient lentement à l’échelle de quelques années de manière anti-corrélée. Une illustration de la variation des périodes radio nord et sud mesurées pendant la totalité de la mission Cassini est représentée sur la figure 7. Cette variation anti-corrélée à long terme a conduit à penser que la variation saisonnière[Note 5] de l’illumination solaire des régions polaires pouvait jouer un rôle dans un « ralentissement » de la période de l’hémisphère éclairé par rapport à une période de référence interne plus courte, par son influence sur la conductivité ionosphérique et ainsi sur les systèmes de courant qui couplent la magnétosphère à l’ionosphère pour donner naissance aux émissions radio. Néanmoins, la figure 7 montre que les deux périodes radio se sont « croisées » plusieurs années après l’équinoxe, alors que la période sud avait atteint son maximum bien après le solstice. En d’autres termes, même l’hypothèse la plus aboutie de variation saisonnière n’explique pas tout.

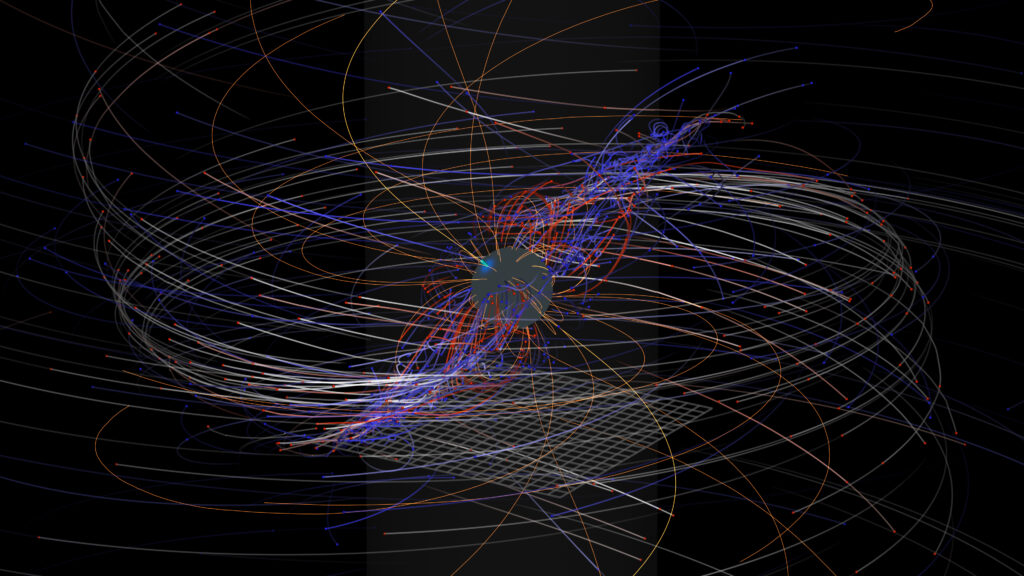

Plusieurs découvertes sont néanmoins venues lever une partie du voile sur ce mystère. Les deux périodes radio nord/sud ont été observées dans nombre d’autres phénomènes de la magnétosphère (oscillations locales du champ magnétique ou de la densité de plasma, oscillations de l’intensité et de la position des aurores UV/visible/IR, oscillations des frontières de la magnétosphère, etc.). Toutes ces modulations sont la conséquence directe de deux systèmes de courants électriques « alignés » le long des lignes de champ magnétique, tournant chacun dans un hémisphère à une période propre. L’origine de ces systèmes de courant reste cependant inconnue. L’hypothèse la plus défendue postule l’existence de deux tourbillons géants de matière dans la haute atmosphère ionisée, capables de produire un courant électrique à longue durée de vie et avec des périodes de rotation contrôlées par l’interaction entre l’atmosphère ionisée et l’atmosphère neutre. Cependant, ils se situeraient dans une région peu dense difficile à sonder, même pour Cassini, et valider cette hypothèse reste un défi.

7. Périodogramme des émissions radio aurorales de saturne en fonction du temps. Les courbes bleues et orange, ajustées sur les signaux périodiques les plus intenses, correspondent aux périodes radio des hémisphères nord et sud. (L. Lamy, LESIA/Obs. de Paris/CNES)

L’exploration in situ, une clef pour aborder la microphysique

Le panorama dressé montre que nous avons désormais une bonne connaissance des différentes composantes des aurores de Saturne, leur distribution spatiale, leur budget d’énergie et leur dynamique sur des échelles de temps allant de la saison à la minute. Associée à un bon modèle de champ magnétique, tel celui bâti à partir des dernières mesures de Cassini, l’observation de ces émissions permet de diagnostiquer précisément les régions actives de la magnétosphère et nous éclaire sur les processus globaux qui s’y déroulent, telle que la circulation générale du plasma, les systèmes de courant électrique à grande échelle, l’interaction variable entre Saturne et le vent solaire, entre la planète et sa lune Encelade, etc. Entre ces deux bouts de la chaîne, l’étude de la microphysique des processus d’accélération et de rayonnement, c’est-à-dire la manière dont l’énergie est transférée de la magnétosphère vers les régions polaires, commence à peine à éclore. C’est en effet grâce aux mesures in situ acquises lors du Grand Finale, lorsque la sonde a traversé les régions où accélération des particules et rayonnement radio se produisent, que ces questions peuvent pour la première fois être abordées pour Saturne et comparées au cas terrestre. Le hasard des calendriers des agences spatiales faisant parfois bien les choses, la sonde américaine Juno mène en ce moment même, et depuis son arrivée en orbite polaire autour de Jupiter mi-2016, des mesures similaires permettant de faire de la planétologie comparée in situ en même temps pour les deux géantes ! Cette coïncidence forme un véritable âge d’or pour la physique aurorale planétaire, même s’il faudra certainement plusieurs décennies pour analyser pleinement les données de ces deux sondes. Les premiers résultats in situ du Grand Finale confirment une chose importante : le rayonnement radio auroral de Saturne est produit par le même mécanisme que celui de la Terre, même si c’est dans un environnement très différent [6]. Cela suggère un mécanisme de rayonnement universel, capable de révéler des exoplanètes en orbite autour d’étoiles plus lointaines que le Soleil. De quoi attendre leur détection avec plus d’impatience encore.

par Laurent Lamy | LESIA – Observatoire de Paris

Publié dans le magazine L’Astronomie Mars 2019

Remerciements : L’auteur de ces lignes remercie Renée Prangé pour une relecture minutieuse, dans l’esprit et la lettre, ainsi que le comité éditorial de l’Astronomie pour ses commentaires constructifs et pertinents.

Références

[1] F. Mottez, Aurores polaires – La Terre sous le vent du Soleil, Belin, 2017, ISBN 978-2-7011-9605-3.

[2] P. Zarka, « L’environnement magnétique des planètes », l’Astronomie, mars-avril 2007, p. 151-157.

[3] Un rapide bilan scientifique de la mission Cassini est dressé dans cette animation du JPL : www.jpl.nasa.gov/video/details.php?id=1464

[4] Cette animation d’images UV de Saturne prise en 2017 avec Hubble montre clairement la dynamique des aurores à l’échelle de plusieurs semaines : www.youtube.com/watch?v=v3pp7DhxPtk

[5] Le service CNRS/INSU APIS (Auroral Planetary Imaging and Spectroscopy) permet de compulser des observations aurorales planétaires en ligne : http://apis.obspm.fr [6] Cette animation des aurores visibles de Saturne mesurée en 2009 avec Cassini montre des rideaux d’émission tournant avec la planète variable à l’échelle de quelques dizaines de minutes : www.youtube.com/watch?v=yWOjfznja6o

[7] Cette animation grand public résume fidèlement la problématique de la modulation rotationnelle radio : www.sciencemag.org/news/2018/10/how-long-saturn-s-day-search-reveals-even-deeper-mystery

[8] Les premières traversées des sources du rayonnement radio auroral kronien ont livré leurs résultats : https://www.obspm.fr/cassini-grand-finale-une.html

Notes

- Les émissions de faisceau sont produites directement par les faisceaux de particules. Par opposition les émissions par impact sont produites par les molécules de l’atmosphère. – 2. Du grec Kronos, assimilé par les Romains à Saturne. – 3. Pour maintenir un courant électrique, il faut conserver le produit de la vitesse par la densité des porteurs de charge électrique (ici les électrons). Si la densité diminue, il faut augmenter la vitesse, donc accélérer les électrons. – 4. Le kiloélectronvolt (ou keV) est une unité d’énergie correspondant à celle d’un électron accéléré par un potentiel électrique de 1 000 volts. – 5. Saturne effectue une révolution autour du Soleil en 29 ans.

par Sylvain Bouley | Jan 14, 2024 | Zoom Sur

Draperies lumineuses vertes ou grandes étendues rouges dans le ciel, les aurores sont faciles à contempler dans les régions polaires de la Terre. On sait qu’elles résultent essentiellement de l’interaction du vent solaire avec l’atmosphère terrestre. Mais existent-elles sur chaque planète du Système solaire ? Les ingrédients indispensables pour les produire sont-ils réunis ailleurs que sur Terre ?

C’est dans la gamme des ultraviolets (UV) que les aurores sont les plus lumineuses. Les UV sont filtrés par l’atmosphère, donc on ne les voit pas depuis le sol. Depuis l’espace, les caméras UV sont les meilleurs instruments pour détecter les rayonnements à ces longueurs d’onde. En scrutant les autres planètes dans la gamme des UV, par exemple avec le télescope spatial Hubble, des aurores ont été observées sur Jupiter, Saturne et même Uranus !

LES ÉLECTRONS, LES PINCEAUX POUR PEINDRE LES AURORES

Les aurores sont engendrées par des particules chargées, principalement des électrons, venant de l’espace et dirigées vers la haute atmosphère de la planète. Lorsqu’un électron rencontre des atomes atmosphériques (un seul électron pouvant subir des dizaines de collisions), les atomes bousculés absorbent une partie de son énergie et la restituent sous forme de lumière, d’où la luminosité des aurores.

La question a longtemps été de savoir quelle était l’origine de ces électrons. Une source possible est le Soleil : notre étoile émet en permanence un vent peu dense mais très rapide (400 à 800 km/s, tant au niveau de la Terre qu’à des distances plus grandes) composé d’électrons et d’ions d’hydrogène H+ (c’est-à-dire des protons) et d’hélium He+. Pour la Terre, le vent solaire est effectivement la source des particules chargées aurorales. Pour Jupiter, dont les aurores sont très puissantes, le vent solaire, déjà peu dense au niveau de la Terre (5 électrons par centimètre cube), l’est encore moins près de Jupiter. Le flux de particules solaires ne peut permettre à lui seul d’expliquer les aurores de Jupiter, et encore moins celles de Saturne et d’Uranus.

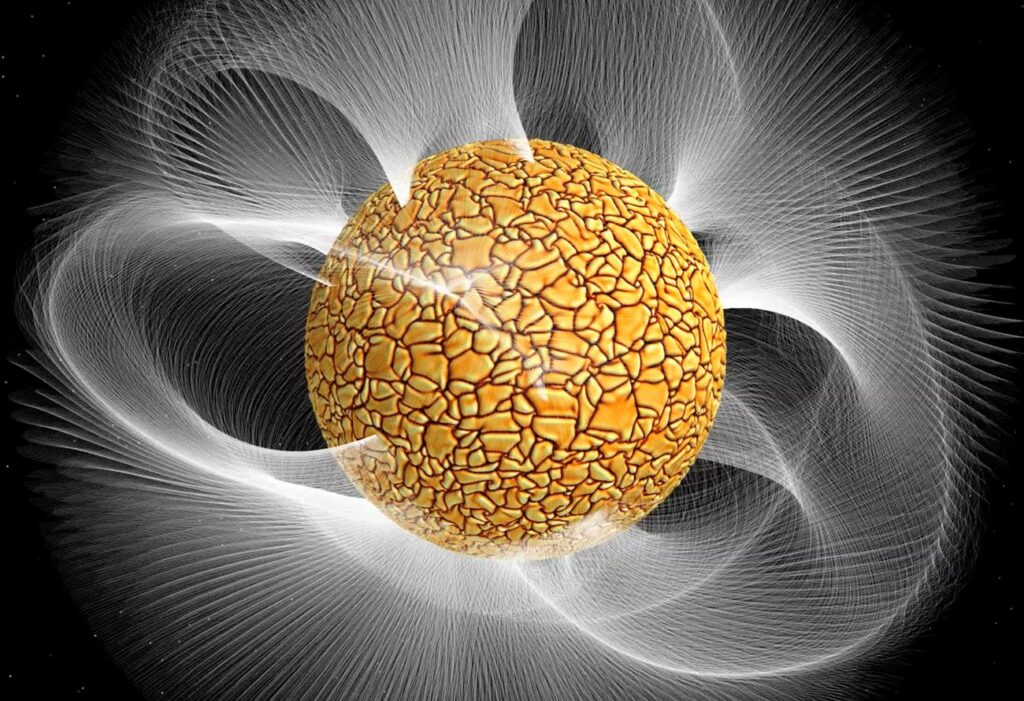

Ce schéma de la magnétosphère de Saturne

présente les principaux ingrédients qui participent à sa structure globale. Ces ingrédients, comme le champ magnétique planétaire, les gaz ionisés, les anneaux et les poussières, sont communs aux quatre planètes géantes, mais pourtant chaque magnétosphère est unique au sein du Système solaire.

DES SOURCES D’ÉLECTRONS VARIÉES

L’exploration spatiale de Jupiter, commencée avec le passage des sondes Voyager à la fin des années 1970, a montré que le plus proche satellite de Jupiter, Io, possède des volcans extrêmement actifs (l’Astronomie no 151). Comme cela a été confirmé avec la sonde Galileo, une partie des panaches volcaniques de Io s’échappe et se satellise autour de Jupiter, formant une région riche en gaz ionisés par le rayonnement solaire, c’est-à-dire en ions moléculaires et en électrons. C’est une des sources principales d’électrons capables de produire les aurores de Jupiter.

De même pour Saturne, les observations de la sonde Cassini ont révélé que le satellite Encelade émet de grands panaches d’eau qui viennent alimenter un tore (un anneau assez épais) de gaz ionisé en orbite autour de Saturne. Mais l’approvisionnement en particules chargées ne suffit pas à tout expliquer. Il faut que celles-ci tombent sur la planète pour rencontrer le gaz atmosphérique, et qu’elles aient une énergie suffisante pour expliquer la luminosité des aurores observées.

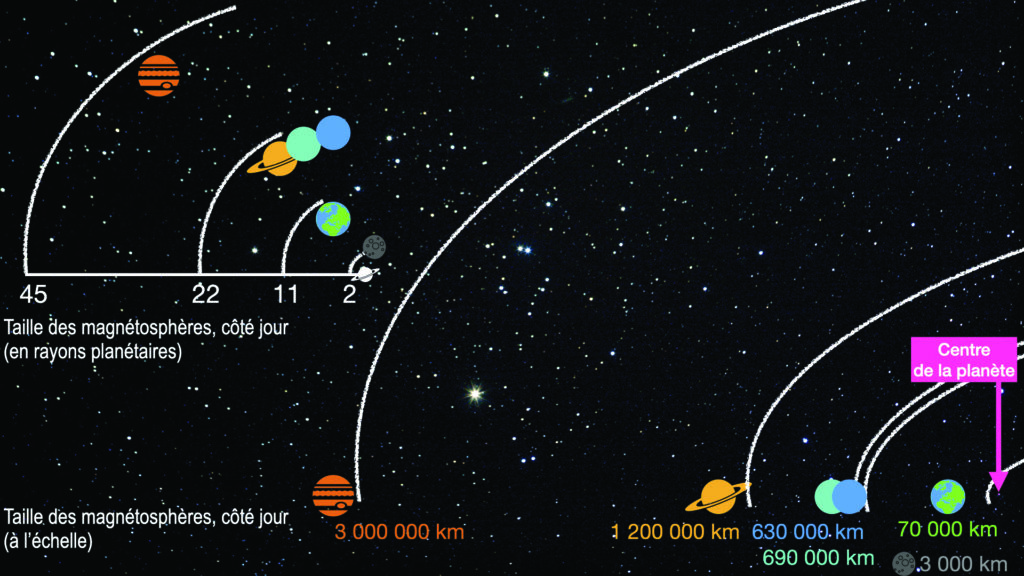

Ces deux schémas présentent les ordres de grandeur de la longueur caractéristique de chaque magnétosphère planétaire, dans deux unités de mesure différentes. Cette longueur caractéristique est la distance de la frontière du champ magnétique planétaire côté jour, avant la région dominée par le vent solaire. En haut, la taille est donnée en fonction du rayon de la planète à l’origine de la magnétosphère, en bas cette distance est rapportée en kilomètres.

LA MAGNÉTOSPHÈRE, CHEVALET DU PEINTRE DES AURORES

Dans le cas de la Terre, seule une très petite partie du vent solaire qui rencontre la Terre est utilisée pour produire les aurores. En revanche, les électrons causant les aurores sont typiquement dix fois plus énergétiques que ceux arrivant directement du vent solaire. Donc, la Terre n’est pas un simple collecteur de vent solaire, c’est aussi un accélérateur de particules. Dans le cas de Jupiter et de Saturne, il existe aussi « quelque chose » qui permet aux particules des tores de Io et d’Encelade, piégés dans le plan équatorial de la planète, de s’en échapper pour finalement tomber avec de grandes énergies très près des pôles. Ce « quelque chose » est la magnétosphère.

La magnétosphère est la région dominée par le champ magnétique planétaire, qui forme une cavité dans le vent solaire ambiant. La Terre, Jupiter, Saturne, Uranus, Neptune et même la petite Mercure ont en commun d’avoir un champ magnétique structuré à l’échelle planétaire qui est à l’origine d’une magnétosphère. Notons ici que Mercure a un champ magnétique suffisant pour avoir une magnétosphère planétaire miniature, mais pas d’atmosphère, donc pas d’aurore.

Le champ magnétique est en tout cas le troisième ingrédient fondamental des aurores (en plus d’une atmosphère et des électrons). La magnétosphère permet en effet d’accélérer les particules issues du vent solaire, d’organiser la circulation des particules chargées en provenance des lunes et de les précipiter vers les pieds des lignes de champ magnétique de la planète.

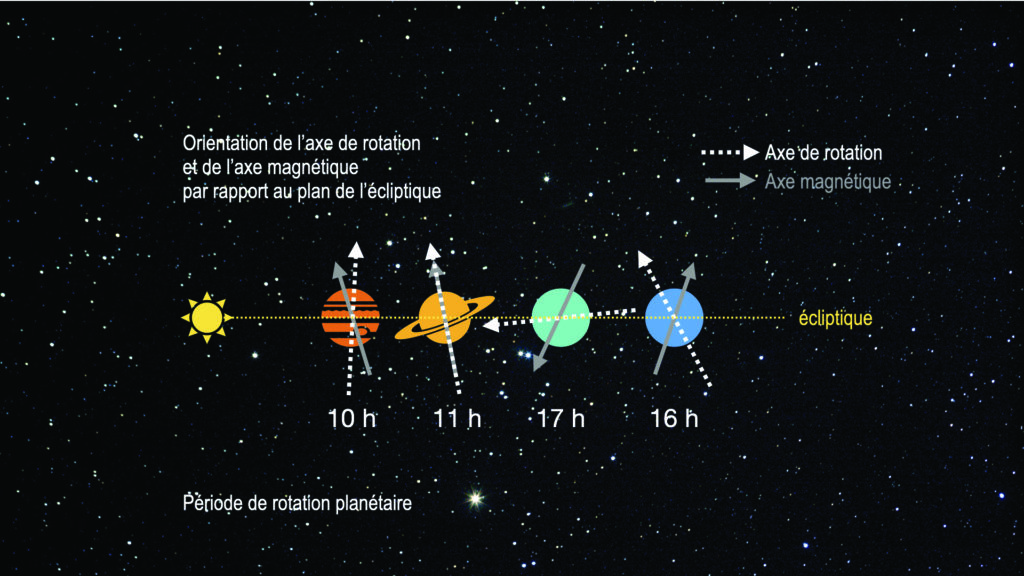

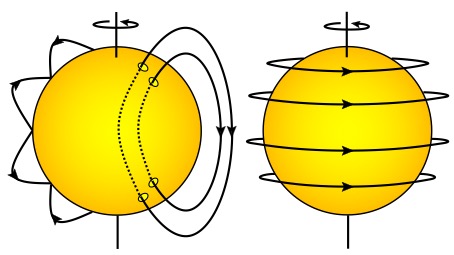

La dynamique des magnétosphères

dépend beaucoup de la géométrie relative de l’axe magnétique de la planète par rapport à la direction du vent solaire.

DES MAGNÉTOSPHÈRES PLANÉTAIRES TRÈS DIVERSES

Les planètes « magnétisées », Mercure, la Terre et les planètes géantes, ont des champs magnétiques d’intensités très différentes. La pression magnétique fournie par la planète varie donc d’une planète à l’autre. Comme le vent solaire est de moins en moins dense en se propageant loin du Soleil, sa pression dynamique sur les planètes décroît quand on s’éloigne du Soleil. La taille caractéristique d’une magnétosphère résulte d’un équilibre de ces deux pressions. On a donc dans le Système solaire des magnétosphères de tailles extrêmement variées !

En plus de cette question de taille, la géométrie relative de la magnétosphère d’une planète par rapport à la direction de propagation du vent solaire peut varier au cours d’une journée (Uranus et Neptune), au cours des saisons (Jupiter, Saturne, Uranus et Neptune) ou ne pas varier du tout (Mercure). C’est la conséquence de la rotation plus ou moins rapide des planètes, autour d’un axe de rotation plus ou moins aligné avec l’axe du champ magnétique.

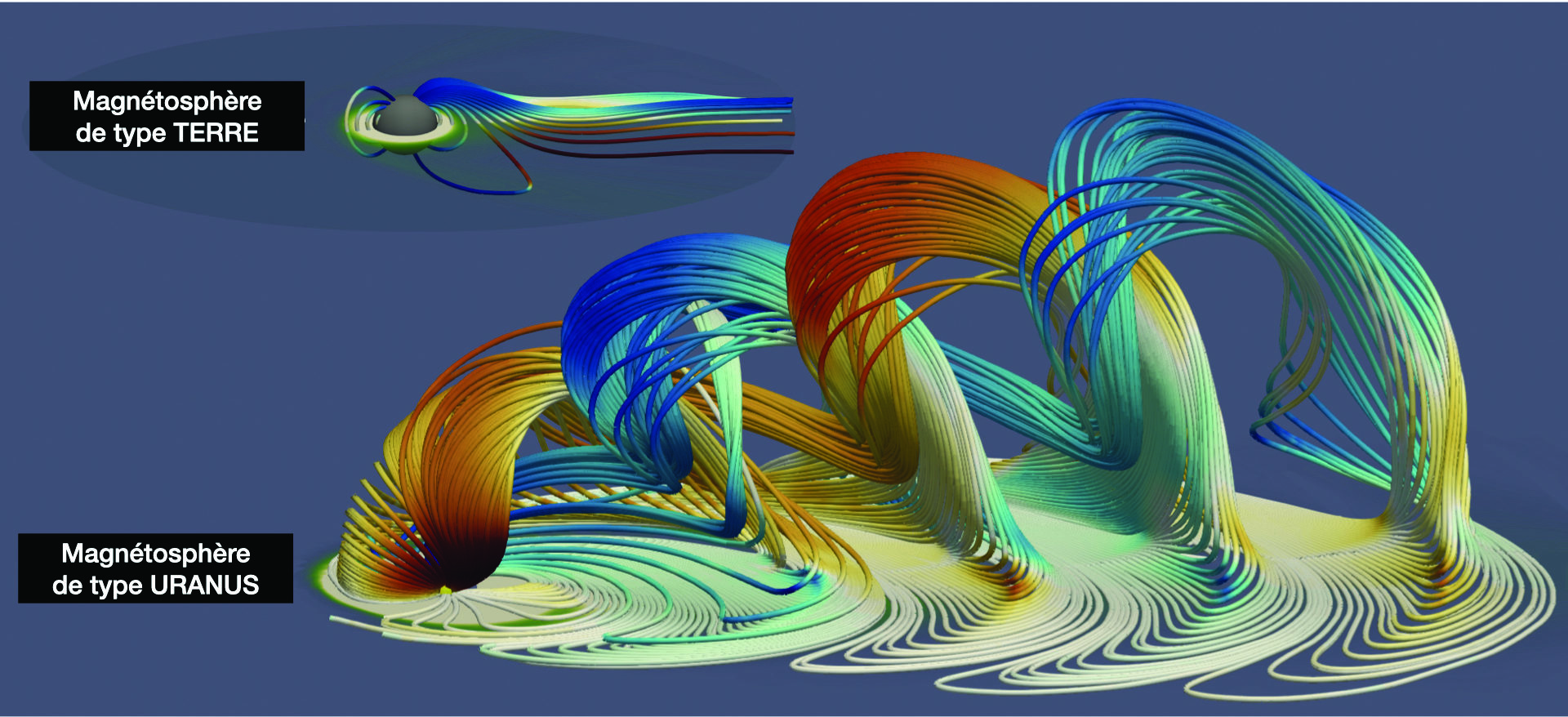

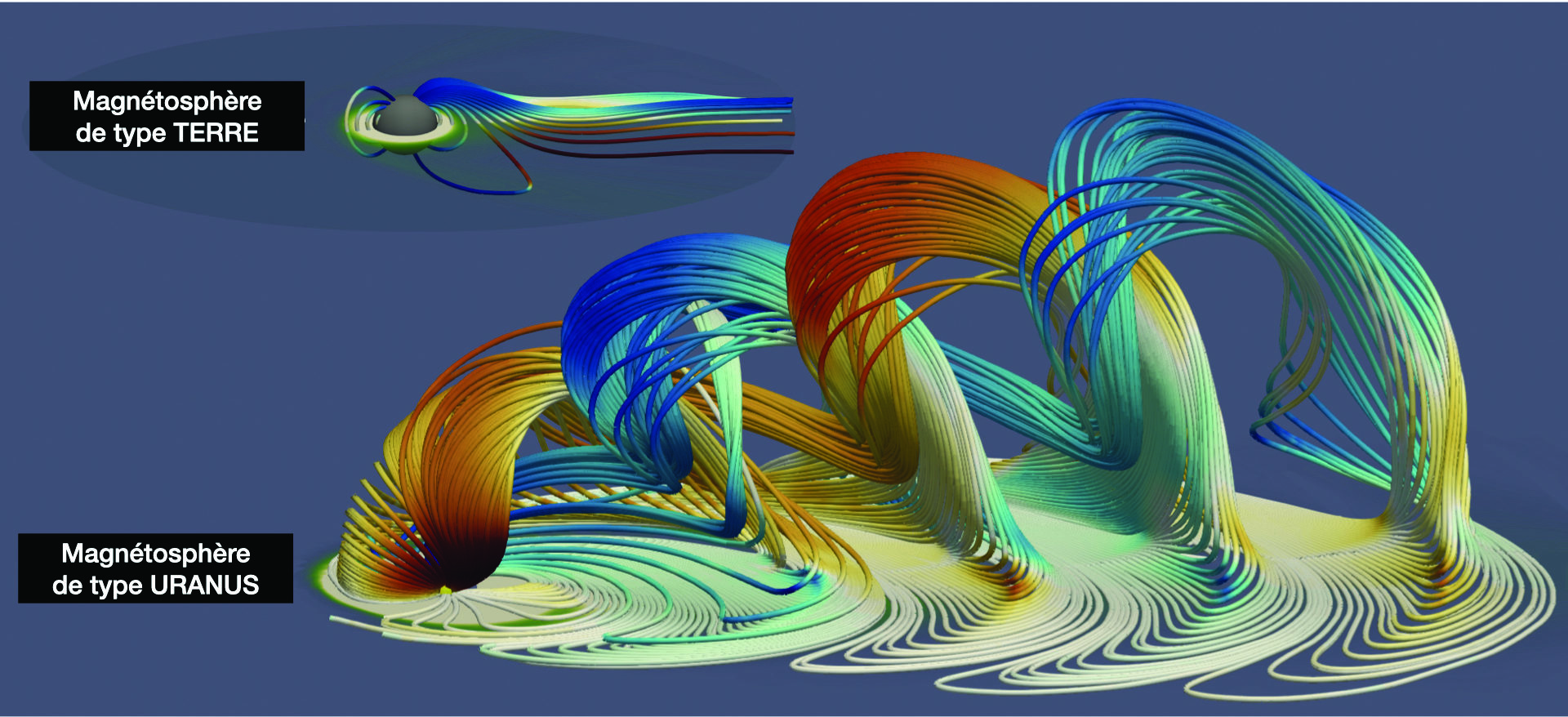

La championne des changements de géométrie est sans aucun doute la magnétosphère d’Uranus, la plus exotique des magnétosphères planétaires et la moins explorée à ce jour : aucune mission n’a pour l’instant pu se mettre en orbite pour la mesurer en détail. Les simulations numériques permettent de comprendre comment la dynamique de la magnétosphère d’Uranus diffère de celle des autres planètes.

Ajoutons à cela la présence éventuelle de ceintures de radiation, d’interactions avec la surface ou l’atmosphère de la planète, de lunes sources de gaz ionisés, d’anneaux et de poussière, et l’on obtient toute une zoologie de phénomènes magnétosphériques qui font de chaque magnétosphère un laboratoire unique de physique des gaz ionisés !

Les magnétosphères d’Uranus et Neptune bouleversent notre compréhension des magnétosphères planétaires.

LES PLANÈTES SANS AURORES

Mars et Vénus ont une atmosphère, mais il leur manque, pour offir de belles aurores polaires, l’effet structurant et accélérateur d’une magnétosphère, car Mars et Vénus n’ont pas de champ magnétique développé à l’échelle de la planète. Neptune dispose d’une atmosphère, d’un champ magnétique, mais le vent solaire y est extrêmement ténu et, jusqu’à présent, aucune aurore n’y a été observée. Outre les planètes, la Lune n’a pas d’aurores, car elle n’a ni champ magnétique ni atmosphère.

En résumé, pour exhiber des aurores brillantes, il faut une atmosphère, une source de particules électriquement chargées qui peut être le vent solaire, ou une source interne liée à des satellites, et aussi une source d’énergie capable d’accélérer ces particules. Seules la Terre, Jupiter, Saturne et Uranus remplissent ces conditions dans l’état actuel des observations. Mais au-delà des aurores, la physique magnétosphérique permet d’étudier de nombreux phénomènes d’échanges d’énergie entre notre étoile et ses planètes. Cette interaction « magnétique » entre une étoile et ses planètes commence par ailleurs a être détectée au-delà de notre Système solaire. Les aurores ne permettant pas de tout comprendre, il est insuffisant de se contenter des observations depuis la Terre pour étudier l’environnement ionisé des planètes. Les magnétosphères planétaires sont donc des thèmes scientifiques fondamentaux des futures missions d’exploration du Système solaire.

Fabrice MOTTEZ – CNRS/Observatoire de Paris-PSL

Léa GRITON – Sorbonne Université, Lesia, Observatoire de Paris

Publié dans le magazine L’Astronomie Septembre 2021

par Sylvain Bouley | Jan 14, 2024 | Zoom Sur

Le vent solaire est invisible, et pourtant il est partout dans le Système solaire. Au cœur des objectifs de deux missions spatiales actuellement au plus près de notre étoile, il garde encore de nombreux mystères. Pourtant, comprendre son interaction avec les planètes, et en particulier la Terre, est un défi majeur pour la communauté scientifique.

Les astronomes ont, comme les botanistes, la manie de classer les objets de leurs découvertes en catégories, en familles, en classes, en sous-classes, aboutissant ainsi à de multiples zoologies célestes utiles à l’analyse des données d’observation et à la compréhension de l’Univers. Cette classification est, plus qu’utile, parfaitement nécessaire pour ordonner la pensée scientifique. Cependant, elle efface parfois un aspect fascinant du fonctionnement de l’Univers que sont les interactions.

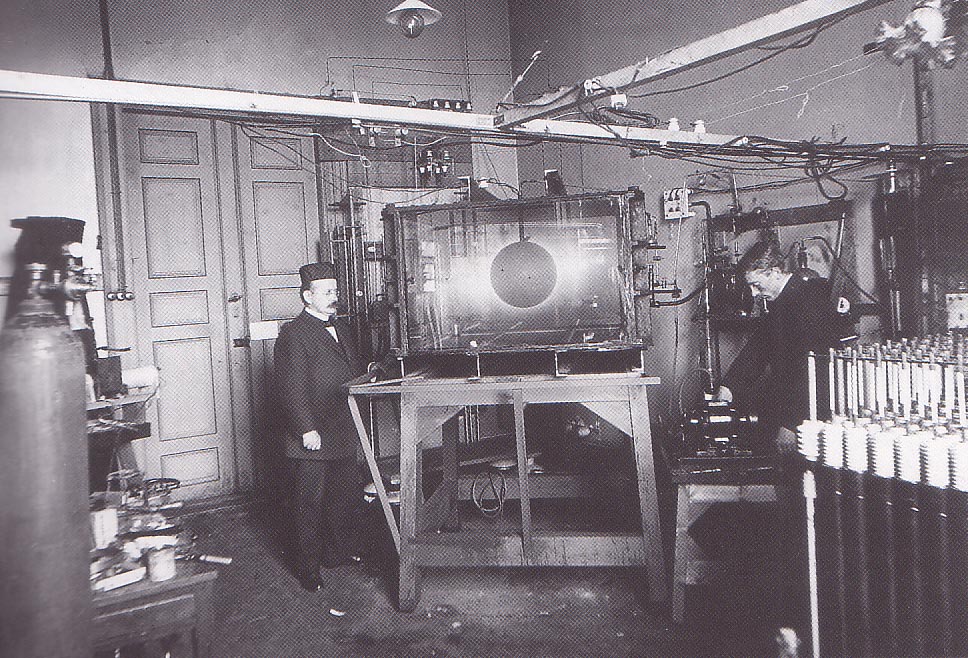

1. Kristian Birkeland (à gauche), vers 1900, dans son laboratoire de l’université de Christiania (l’ancien nom de la ville d’Oslo), avec son expérience, la « terrela », qui tente de simuler le phénomène à l’origine des aurores polaires.

Interactions étoiles-planètes

Le Soleil est une étoile. C’est donc, par définition, un objet différent d’une planète. Et pourtant, le Soleil interagit avec la Terre. Cette interaction passe évidemment par la lumière, qui rayonne de l’étoile et baigne tous les objets alentour, mais pas seulement. L’atmosphère du Soleil est très vaste et se propage vers les planètes sous la forme d’un gaz qu’on appelle le vent solaire. Ce vent solaire interagit avec tout ce qui l’entoure, petits corps, planètes magnétisées et non magnétisées, poussières, lunes de planètes : rien autour du Soleil ne lui échappe. Les objets célestes ne peuvent donc pas éternellement être étudiés séparément, dans des boîtes bien délimitées et étanches, symbolisées par des départements d’agences spatiales différents ou des lignes de crédit séparées (l’on pense en particulier aux divisions habituelles d’« héliophysique » et de « planétologie »). L’étude des interactions étoile-planète commence, et c’est heureux, à se développer au-delà de notre Système solaire, alors même qu’elles sont encore mal comprises dans l’environnement proche de notre étoile. L’interaction étoile-planète peut couvrir de nombreux aspects, et je ne pourrai pas traiter ici des différentes facettes de cette interaction de manière exhaustive. Je me contenterai donc d’explorer ici un élément en particulier : le vent solaire et son interaction avec les planètes du Système solaire.

Un peu d’histoire

Il y a soixante-deux ans, un Américain de l’université de Chicago, Eugene Parker, construit pour la première fois une théorie du vent solaire. Il surnomme ainsi un phénomène que l’on soupçonne depuis les années 1850 de « peindre » les aurores polaires ou de perturber le télégraphe en attaquant le champ magnétique terrestre. À l’époque, on imagine des paquets de particules chargées émis de temps à autre par le Soleil et qui se propagent dans le vide. Au début du xxe siècle, le physicien norvégien Kristian Birkeland étudie sous toutes les coutures les aurores, concluant à l’existence de particules chargées émises par le Soleil en permanence, et non de manière sporadique. Un demi-siècle plus tard, ce ne sont pas les aurores mais les comètes qui amènent l’Allemand Ludwig Biermann à postuler qu’un flot continu de particules chargées venant de notre étoile pourrait expliquer la direction de la queue ionique des comètes et, peu de temps après, l’Anglais Sydney Chapman avance que l’atmosphère du Soleil pourrait s’étendre bien au-delà de l’orbite terrestre et que notre planète baignerait dedans.

Quand Eugene Parker publie en 1958 que tous ces Européens doivent parler d’une seule et même chose, un « gaz interplanétaire » qu’il appelle à l’oral « vent solaire », le débat scientifique s’enflamme et des campagnes d’observation voient le jour. Dès 1959, les premiers satellites confirment les résultats de Parker [1].

2. Cette magnifique image de la couronne solaire, prise lors de l’éclipse totale de 2017, révèle la structure du champ magnétique de notre étoile. on distingue très bien les lignes « ouvertes », s’échappant des trous coronaux aux pôles nord et sud, des lignes fermées, ou « boucles », plus nombreuses autour de l’équateur solaire. Ce sont les électrons qui émettent la lumière blanche photographiée ici : on voit tout de suite que le plasma est beaucoup plus dense autour des boucles fermées que le long des lignes ouvertes.

(© Miloslav Druckmüller/Peter Aniol/Vojtech Rušin/ubomír Klocok/Karel Martišek/Martin Dietzel)

Un vent solaire au coeur de plusieurs missions spatiales en cours

L’héliophysique connaît en ce moment un âge d’or, avec deux missions spatiales en train de sonder l’héliosphère interne au même moment. Lancée en août 2018, Parker Solar Probe (Nasa) est en train de s’approcher au plus près du Soleil. En octobre 2020, puis en janvier 2021, la sonde a frôlé le Soleil à seulement 20 rayons solaires de notre étoile ! Aussi près de l’étoile, la comparaison entre les structures observées dans le vent solaire et les phénomènes à la surface du Soleil devient à la fois plus facile (les phénomènes d’altération liés à la propagation du vent ont un impact minimal) et plus complexe : le niveau de détail des structures à étudier donne le tournis ! Un peu plus loin, mais équipée d’instruments complémentaires, la sonde Solar Orbiter est toujours en phase de croisière, depuis son lancement en février 2020. Elle ne commencera ses mesures scientifiques optimisées qu’en fin d’année. En attendant, certains instruments sont allumés lors de campagnes dédiées et les premières données, d’une résolution inédite, sont en cours d’analyse. Le 26 septembre dernier, les deux sondes étaient alignées radialement par rapport au Soleil, et Parker Solar Probe était pratiquement arrivé au périhélie : cette configuration plutôt rare (c’est la seule de l’année 2020) permet d’étudier plus en détail la propagation du vent, d’abord du Soleil à Parker Solar Probe, et ensuite de Parker Solar Probe à Solar Orbiter. Outre ces deux sondes, il y a bien sûr encore les observatoires spatiaux, comme SoHo, ou les télescopes solaires au sol, qui organisent des campagnes coordonnées pour mieux replacer les données collectées in situ dans leur contexte tridimensionnel.

Le vent solaire aujourd’hui

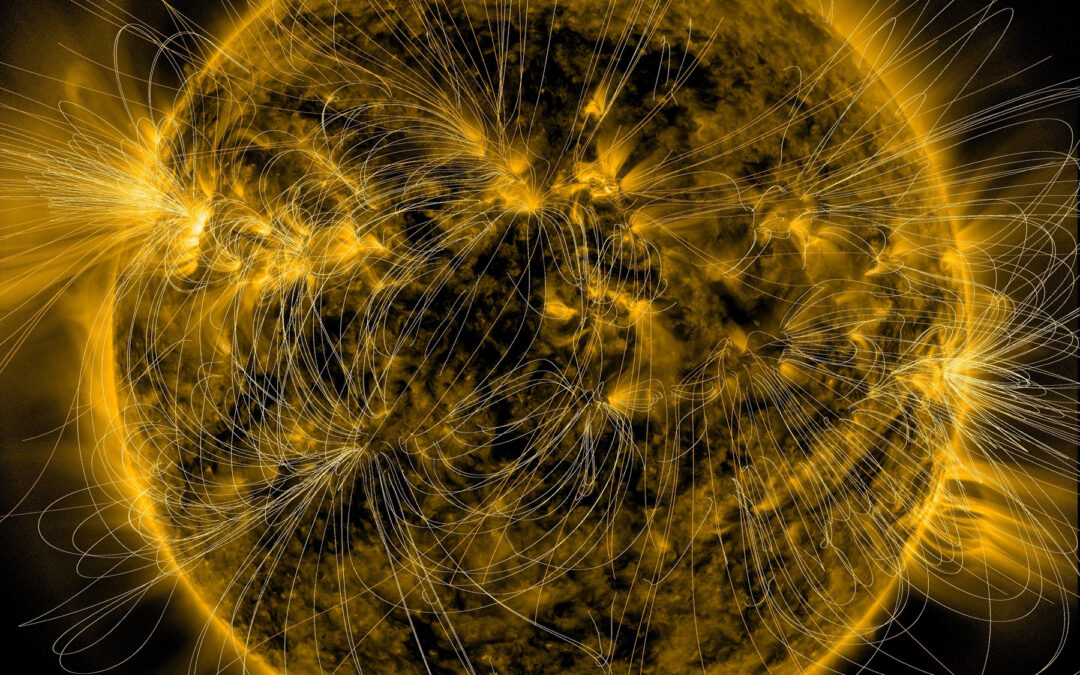

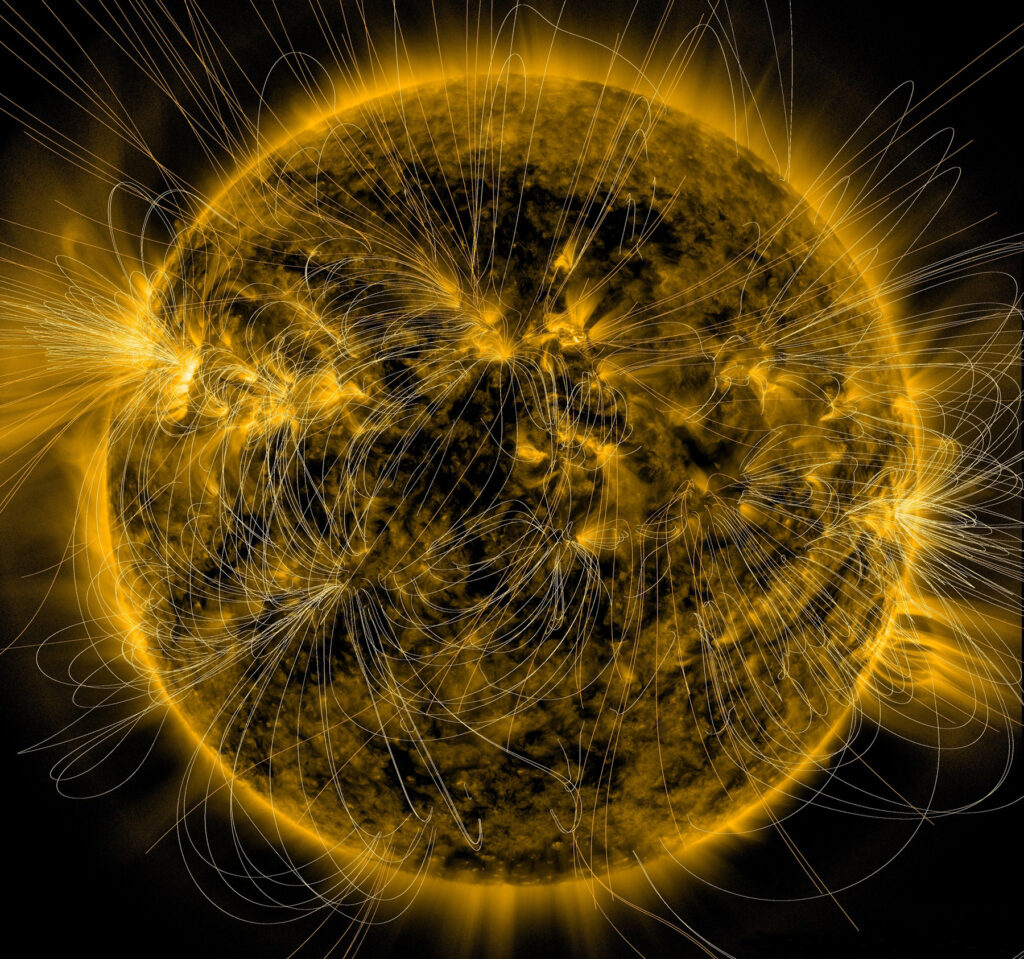

Le vent solaire est un plasma. C’est-à-dire que le vent solaire est un gaz qui, au niveau de l’orbite terrestre, est dix milliards de milliards de fois moins dense que l’air au niveau de la mer sur Terre. Sa température dépasse les cent mille degrés et sa vitesse moyenne est de plus d’un million de kilomètres par heure.

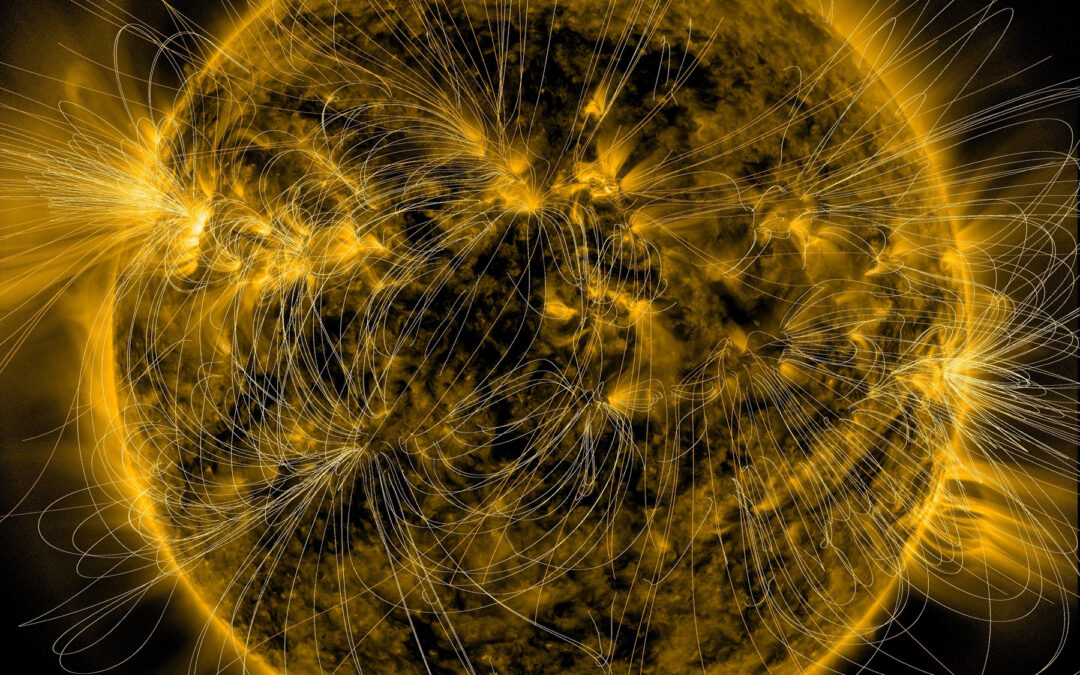

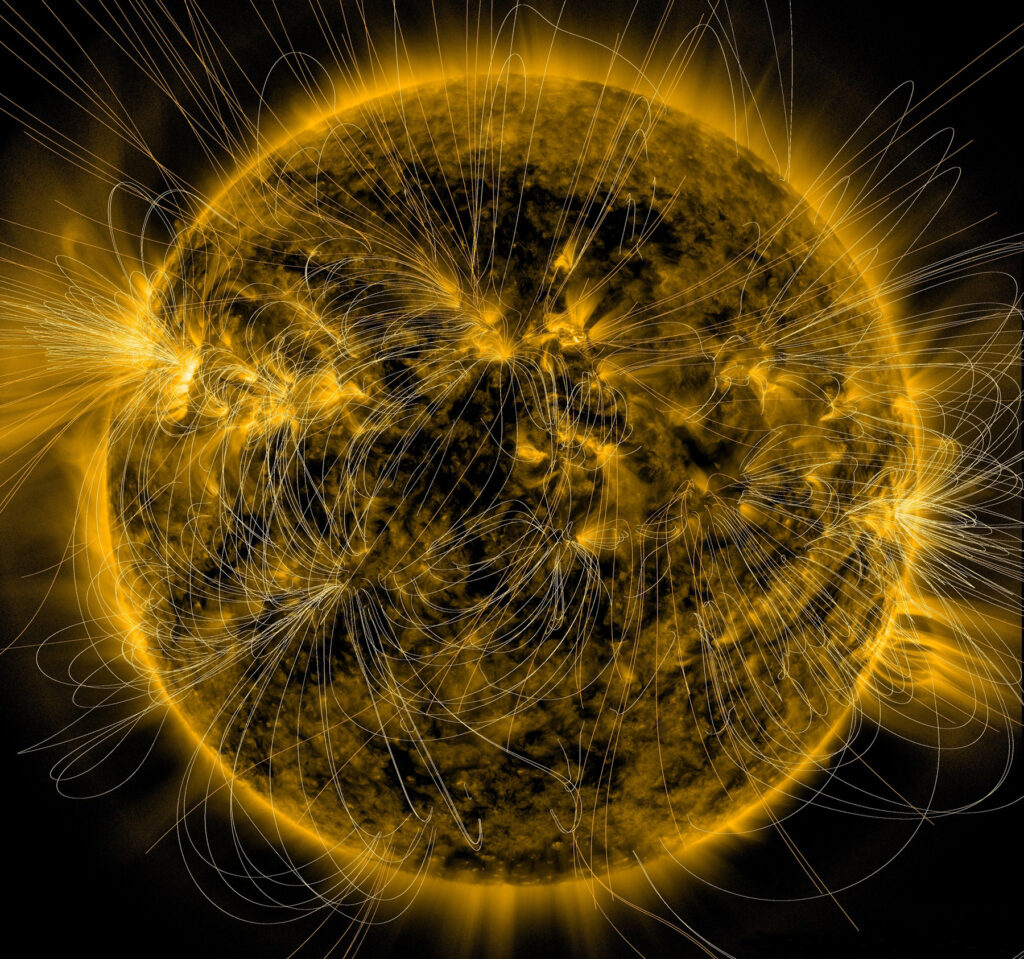

Le vent solaire, qui emporte avec lui 10–14 fois la masse du Soleil chaque année, résulte des réactions nucléaires qui ont lieu au sein de notre étoile. Il s’échappe en permanence de la couronne solaire, l’atmosphère principalement composée d’hydrogène chaud ionisé qui entoure le Soleil. La couronne solaire est particulièrement visible lors des éclipses par la Lune, d’où le nom de « couronne » (comme on peut le voir sur la fig. 2).

De nos jours, le vent solaire suscite toujours de nombreuses interrogations. En effet, l’héritage des observations passées a conduit à une séparation entre l’étude de l’atmosphère du Soleil, comprise entre la surface de l’étoile et une trentaine de rayons solaires de distance, et le vent solaire lui-même. L’étude de la couronne solaire est assurée par des instruments au sol [2] et les observatoires spatiaux, tandis que les mesures du vent solaire in situ sont prises bien au-delà du champ de vue des observatoires solaires, beaucoup plus loin de l’étoile, la plupart du temps au niveau de l’orbite terrestre.

Ainsi, Ulysses, la sonde de l’Agence spatiale européenne qui a permis d’explorer le vent solaire à la fois dans le plan de l’écliptique mais aussi au-dessus des pôles Nord et Sud solaires dans les années 1990, a prouvé que le vent solaire s’organise en fait en deux composantes principales : aux hautes latitudes, on observe essentiellement le vent solaire rapide, tandis que dans le plan de l’écliptique, où se trouvent les planètes, on mesure un mélange de vent solaire lent et de vent solaire rapide en proportions variables selon l’activité solaire. La sonde a révélé que la structuration du vent solaire dans l’héliosphère dépend de l’activité solaire, qui varie selon un cycle de onze ans environ (voir l’article « Le Nouveau cycle solaire est arrivé », l’Astronomie 143). Le vent rapide, qui se propage autour de 800 km/s, émane principalement des trous coronaux (des régions faiblement émissives en rayons X), qui se situent essentiellement aux pôles pendant la phase calme d’un cycle solaire. Le vent lent (se propageant à environ 400 km/s) doit provenir de régions à proximité de lignes de champ magnétique fermées. On devine ces lignes de champ fermées sur l’image d’éclipse de la figure 2, puisque les électrons qui suivent les lignes de champ magnétique réfléchissent de la lumière blanche issue du disque solaire. Ces lignes de champ fermées, ou « boucles », sont schématisées sur la figure 3.

3. sur ce schéma des lignes de champ magnétique du soleil sont représentées. Les lignes

« ouvertes », dont un seul des deux pieds est planté à la surface du soleil, sont dessinées en différentes couleurs en fonction de leur écartement à la direction radiale à leur base, à la surface du soleil : les lignes violettes sont alignées avec la direction radiale dès leur sortie du soleil, tandis que les lignes rouges s’alignent plus haut, du fait qu’elles contournent d’abord des lignes de champ magnétique fermées (en noir sur le schéma). Les lignes ouvertes sortent principalement des trous coronaux. Au-dessus d’un ensemble de boucles fermé se forme ce qu’on appelle un «helmet streamer», à cause de la forme en «casque» des lignes fermées. La polarité du champ magnétique s’inverse au-dessus de ces

streamers. Par contre, quand il y a deux boucles fermées côte à côte, on assiste à la formation d’un pseudo-streamer, et là la polarité du champ magnétique reste inchangée de part et d’autre des boucles fermées. toutes ces différentes géométries jouent un rôle crucial dans la formation de différents types de vent solaire. (Extrait de l’article de revue de Cranmer, en 2017)

Sachant cela, il reste de nombreuses questions sans réponse, qui constituent autant de défis théoriques, mathématiques, numériques, expérimentaux : la chercheuse américaine Nicoleen Viall et son collègue Joseph E. Borovsky ont publié début 2020 un article intitulé « Nine Outstanding Questions of Solar Wind Physics » (Neuf questions remarquables de la physique du vent solaire) qui les résume. Tout d’abord, les mécanismes physiques permettant d’expliquer l’origine du vent solaire, et en particulier de la composante lente du vent (se propageant à environ 400 km/s), restent aujourd’hui mal compris. Pour l’anecdote, quand j’expliquais que mon équipe, à l’Irap, travaille sur les origines du vent solaire lent [3], un petit malin en stage de 3e a haussé les épaules : « Ça vient du Soleil ! » Eh oui, jusque-là, on était au courant… Mais expliquer dans le détail comment ces particules chargées s’échappent à des vitesses différentes en fonction de leur source à la surface du Soleil, c’est déjà un peu plus compliqué ! En effet, le vent solaire lent n’est pas simplement plus lent, il a aussi une composition différente de celle du vent rapide. Les ions n’ont pas exactement les mêmes états d’ionisation dans les deux types de vent. Comme la composition peut difficilement être altérée au cours de la propagation du vent dans l’héliosphère, ces différences de composition sont sans doute liées à des mécanismes de formation différents à la surface du Soleil. Ce que l’on sait, c’est que la formation du vent solaire est étroitement liée à la structure du champ magnétique solaire, qui est lui-même issu de la zone de convection de notre étoile (lire le zoom de l’Astronomie no 145). La convection des gaz dans cette zone apporte de l’énergie, qui s’ajoute à l’énergie découlant des flux de champ magnétique, et cette énergie apporte de la chaleur à l’atmosphère solaire et commence à accélérer le vent. Les trois grandes questions liées à la formation du vent solaire sont donc : D’où vient le vent solaire sur la surface du Soleil ? Comment est-il éjecté ? Comment est-il accéléré ?

Mais ensuite, comment faire le lien entre les propriétés du vent solaire au niveau du Soleil et les propriétés mesurées au niveau de l’orbite terrestre ? Les processus de transport du vent solaire font l’objet de nombreuses études. En particulier, à partir d’une certaine distance, le vent solaire devient turbulent : la turbulence, décrite pour la première fois par Léonard de Vinci dans les écoulements d’eau, explique comment l’énergie peut être distribuée par les structures de grandes échelles vers les petites échelles, et ainsi expliquer l’organisation et le comportement des différentes populations de particules qui constituent le vent, et leur évolution liée à la propagation du vent. J’ai expliqué plus haut que le plasma interagit avec le champ magnétique. Un paramètre, qu’on appelle l’alfvénicité (du nom d’Hannes Alfvén, le physicien qui a découvert les ondes basse fréquence qui affectent à la fois le champ magnétique et le mouvement des ions), permet de décrire à quel point la vitesse du plasma est corrélée à la direction locale du champ magnétique. L’alfvénicité change avec la distance au Soleil, mais aussi d’une catégorie de vent à l’autre, en fonction de la source. Les ondes jouent aussi un rôle essentiel : ondes d’Alfvén, ondes magnéto-acoustiques, mais aussi ondes résultant d’effets cinétiques, c’est-à-dire intervenant aux petites échelles. Toutes ces ondes transmettent des informations souvent bien plus rapidement que le vent lui-même. Cela peut expliquer comment les flots de vents différents à la source vont ensuite se rencontrer, se mélanger et changer de propriétés au cours de leur voyage vers les planètes.

Les deux sondes actuellement en mission dans l’héliosphère interne, Parker Solar Probe (Nasa) et Solar Orbiter (Esa), vont permettre de résoudre nombre de ces questions en prenant des mesures au plus près de notre étoile (voir encadré 1). En particulier, Parker Solar Probe a effectué cet automne un passage à vingt rayons solaires du Soleil, une distance comprise dans le champ de vue des grands observatoires solaires. Le lien entre Soleil, origine du vent et propagation jusqu’à la Terre n’a jamais été aussi établi que maintenant.

Le vent solaire, un plasma

En 1928, Irving Langmuir (1881-1957) avait introduit le mot « plasma » pour désigner un gaz partiellement ou totalement ionisé. En 1963, David A. Frank-Kamenezki désignait pour la première fois le plasma comme le « quatrième état de la matière ». En ce sens, on ne peut considérer les lois régissant un plasma comme différentes de celles d’un gaz neutre. Malheureusement, elles sont plus complexes, car elles mêlent la mécanique des écoulements d’un fluide aux lois de l’électromagnétisme. Un plasma est donc un ensemble de particules chargées, des ions et des électrons, globalement neutre du point de vue électrique et qui présente néanmoins un comportement collectif. Ce dernier point signifie que lorsqu’on applique au plasma une perturbation, un grand nombre de particules de celui-ci sont impliquées dans la réponse macroscopique à la perturbation. On compare généralement l’effet des collisions binaires entre deux particules passant à proximité l’une de l’autre (effet dominant dans les gaz neutres) et l’effet des interactions collectives. Dans le vent solaire, l’effet des interactions collectives l’emporte très largement, et l’on dit que ce plasma est non collisionnel. Le plasma conduit l’électricité et interagit avec le champ magnétique. Le champ magnétique guide le plasma, mais celui-ci peut à son tour modifier le champ magnétique. De par sa nature de plasma, le vent solaire est étudié à des échelles diverses par différentes théories. Une particule chargée soumise à un champ magnétique dirigé dans une certaine direction effectue un mouvement circulaire autour d’une droite alignée avec la direction du champ magnétique (voir figure ci-contre), mouvement circulaire dont le rayon dépend de la masse de la particule, de l’intensité locale du champ magnétique et de la vitesse de la particule. Ce mouvement circulaire est appelé giration et le rayon de la giration est aussi connu sous le nom de rayon de Larmor. Ce mouvement de giration est aussi associé à une période de giration. Dans un champ magnétique intense et qui varie lentement à la fois dans l’espace et dans le temps (par rapport à la giration), on utilise la théorie du centre-guide pour décrire le mouvement d’une particule par rapport au tube de flux magnétique. Cette théorie permet de comprendre la manière dont une particule chargée évolue par rapport au champ magnétique. Cependant, pour des raisons de calcul évidentes, les équations du mouvement sont impossibles à résoudre pour chacune des millions ou des milliards de particules en jeu dans les phénomènes qui nous intéressent à l’échelle des objets célestes. Il faut donc, pour comprendre les comportements des particules qui composent le plasma, se reposer sur les calculs statistiques, et notamment la probabilité qu’il y ait une particule dotée de telle vitesse à tel endroit. Cette fonction de probabilité est appelée fonction de distribution. Dans le cas général d’un plasma peu collisionnel, une description détaillée de la fonction de distribution des particules est nécessaire, notamment lorsque l’on s’intéresse aux petites échelles, en dessous du rayon de giration des particules. C’est le domaine des théories cinétiques des plasmas, le plus souvent basées sur des équations du type de l’équation de Boltzmann pour le gaz [5], mais avec des termes de forces d’interactions plus complexes. Leur utilisation pour simuler un plasma aux grandes échelles (une magnétosphère planétaire par exemple) est malheureusement très difficile à cause de leur lourdeur en matière de ressources de calcul numérique. Enfin, lorsqu’on s’intéresse prioritairement aux grandes échelles, on peut négliger (sous certaines conditions) les phénomènes microscopiques et considérer le plasma comme un fluide d’ions et un fluide d’électrons, voire comme un fluide unique de particules chargées. La théorie basée sur cette dernière hypothèse est appelée la magnétohydrodynamique (MHD). Les plasmas n’existent pas à l’état naturel sur Terre, mais constituent plus de 99 % de la matière connue de l’Univers, et le plasma du Système solaire est le seul accessible pour les mesures in situ. Sur Terre, les plasmas « artificiels » sont étudiés pour essayer de produire de l’énergie nucléaire par fusion, comme dans le Soleil (et non par fission comme dans les centrales nucléaires actuelles), afin, entre autres problèmes, de réduire l’abondance des déchets liés actuellement à la production d’énergie nucléaire. Ainsi, confronter les théories de la physique des plasmas aux observations effectuées dans le vent solaire est un excellent moyen de faire progresser la physique des plasmas en soi, avec de futures retombées essentielles pour l’humanité

.

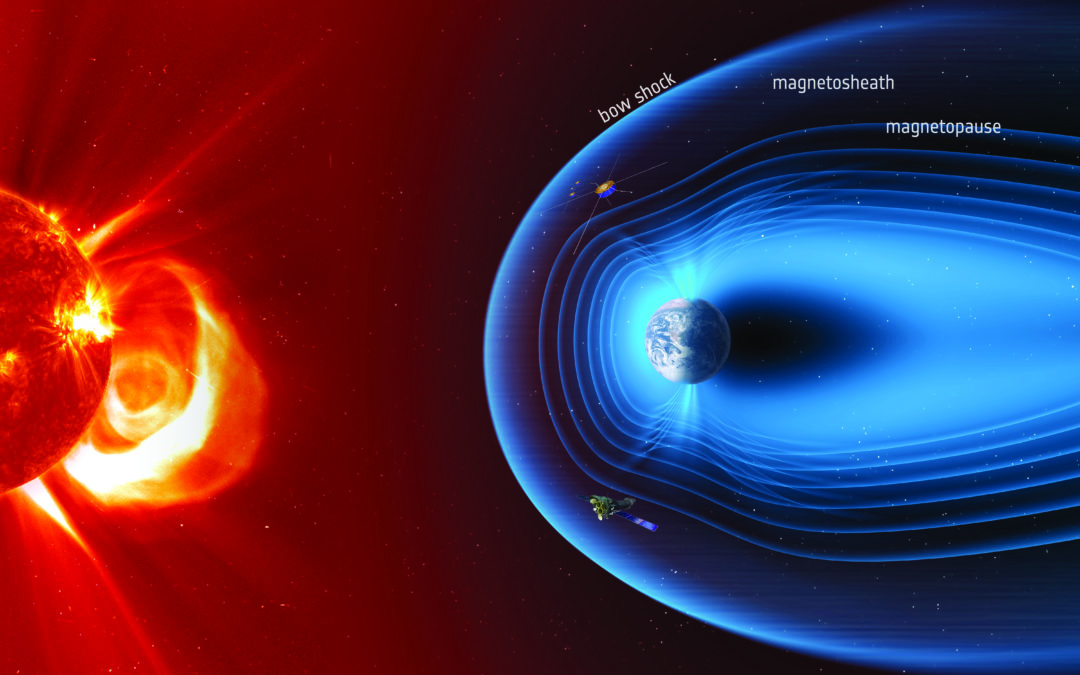

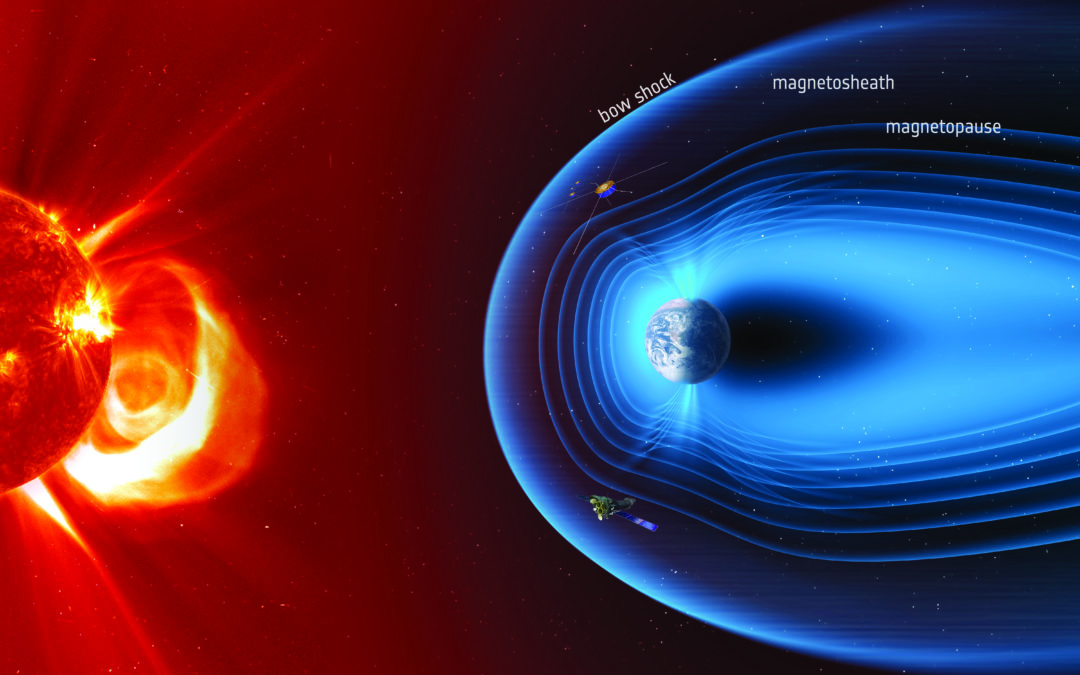

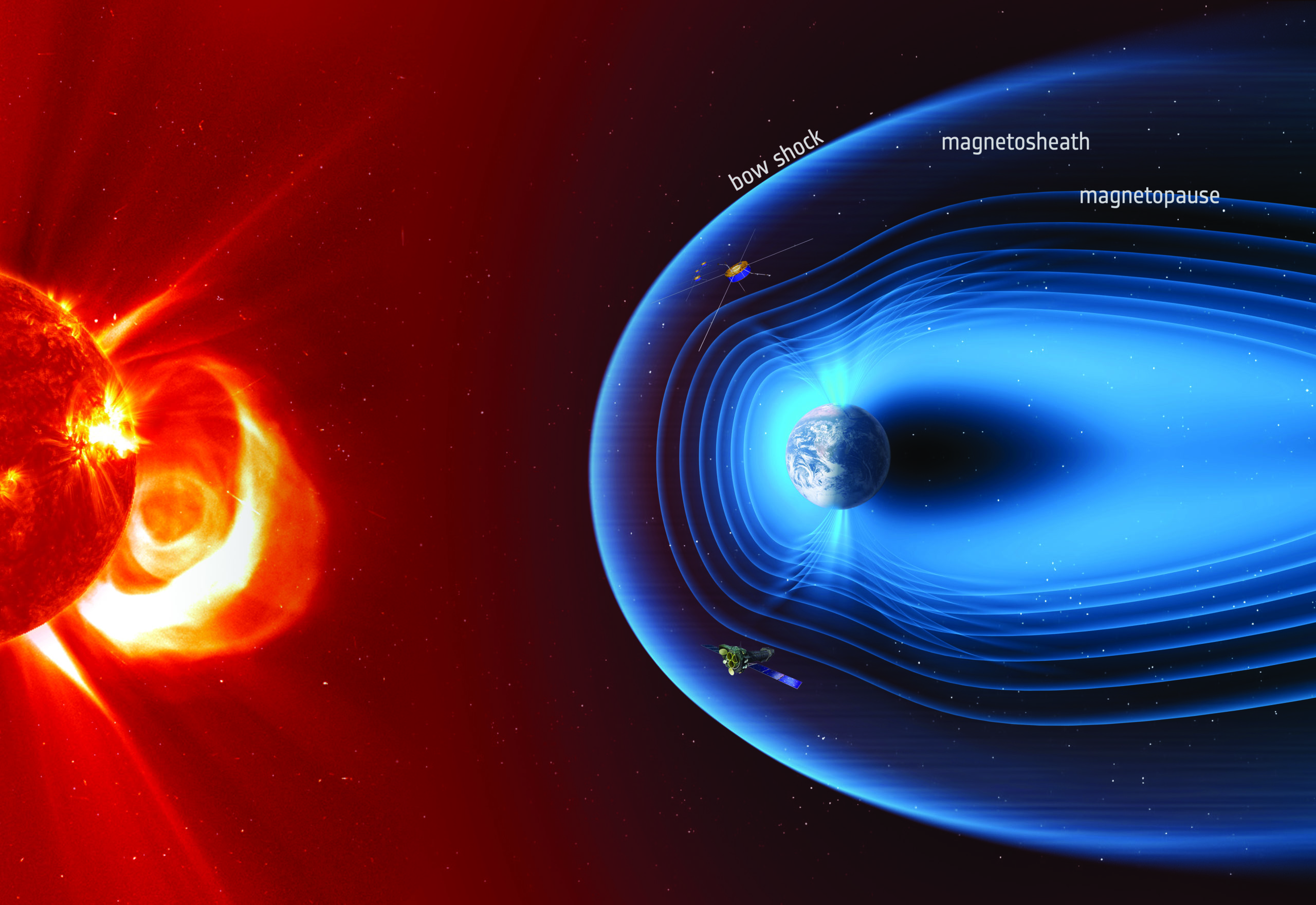

La magnétosphère de la Terre et son interaction avec le vent solaire

Le vent solaire, s’il est fascinant, est surtout extrêmement dangereux pour les êtres vivants et les objets fonctionnant avec de l’électricité. Heureusement pour nous, et pour nos satellites artificiels, la Terre possède elle-même un champ magnétique complexe et puissant, qui permet de détourner le vent solaire à son arrivée à proximité de la Terre. La présence du champ magnétique terrestre bloque en effet le vent solaire dans sa course, formant ce qu’on appelle un choc (sur le même principe que le choc en forme de cône formé dans l’air par les avions quand ils passent le mur du son). Au niveau du choc, la vitesse du vent solaire dans la direction Soleil-planète passe de 400 km/s à une vitesse très faible, c’est très violent. Le vent est ensuite dévié de part et d’autre de la magnétopause, la frontière de la région dominée par le champ magnétique terrestre. Le vent est ensuite transporté vers le côté nuit, en exerçant de fait une pression sur le champ magnétique terrestre qui s’allonge autour d’une longue queue magnétosphérique. Au niveau de l’équateur, les lignes de champ sortantes se retrouvent collées au lignes de champ entrantes : c’est ainsi que se forme une région de fort courant électrique, qui parfois casse les lignes de champ magnétique (ce qu’on appelle un « orage magnétique »), permettant momentanément aux particules de vent solaire d’entrer dans la magnétosphère terrestre et de remonter le long des boucles fermées, côté nuit. Mais qu’il y ait un orage magnétique ou non, les particules de vent solaire qui remontent vers le pic des lignes fermées, à proximité du cercle polaire, peuvent provoquer les fameuses aurores boréales (dans l’hémisphère Nord) ou australes (dans l’hémisphère Sud, au-dessus de l’océan et du continent antarctique, donc plus rarement observées).

Lorsque le vent solaire est suffisamment puissant, il peut écraser le champ magnétique de la Terre côté jour. Les boucles fermées au niveau de l’équateur peinent alors à résister, et les satellites artificiels peuvent se retrouver sans protection. Pire, le vent solaire peut directement atteindre la surface de la Terre, comme lors de la très grosse tempête de vent solaire de 1859, qui avait provoqué de grosses perturbations du réseau de télégraphie. Si une telle tempête avait lieu aujourd’hui, les dégâts causés sur les infrastructures électriques se chiffreraient en centaines de milliards de dollars et la pagaille provoquée par ces destructions simultanées d’infrastructures à l’échelle d’un continent serait fort grande. Pour anticiper un tel désordre, les agences spatiales, mais aussi les grands groupes industriels privés de l’aérospatiale ont mis en place des programmes de surveillance du Soleil et de modélisation de la propagation du vent, en essayant de prédire ainsi l’arrivée de tempêtes solaires. C’est ce qu’on appelle la météorologie de l’espace.

4. Vue d’artiste de la magnétosphère de la terre avec les principales frontières représentées (les échelles de distance ne sont pas respectées) : le choc en amont (bow shock), la magnétopause et, entre les deux, la région appelée magnétogaine (magnetosheath). on y voit aussi deux satellites, Cluster et XMM-Newton, dont la mission consiste à prendre des mesures de la magnétosphère de la terre. (ESA/ATG medialab)

Les magnétosphères planétaires interagissent différemment avec le vent solaire

Chaque magnétosphère planétaire est unique ! Les ingrédients de base sont pourtant les mêmes : un champ magnétique planétaire, du vent solaire, mais comme les propriétés de ces deux éléments changent d’une planète à l’autre, cela résulte en six cas très distincts. Si l’on place à part la magnétosphère de Mercure, qui est vraiment toute petite, on peut comparer les tailles caractéristiques des quatre magnétosphères géantes à celle de la Terre de plusieurs manières.

La taille caractéristique est définie par l’équilibre entre la pression dynamique du vent solaire au niveau de l’orbite de la planète et la pression magnétique exercée par le champ magnétique de la planète. On voit bien, sur les schémas A et B, que Jupiter a une magnétosphère gigantesque : le champ magnétique interplanétaire, transporté par le vent solaire, met une dizaine de jours à se connecter puis à se déconnecter de la planète ! Sur Mercure, cette durée de connexion magnétique est de l’ordre de la minute ! L’autre horloge de la physique magnétosphérique est dictée par la rotation planétaire. Dans le cas de Mercure, celle-ci est négligeable. Elle commence à jouer un rôle dans la magnétosphère terrestre. Mais c’est surtout pour les magnétosphères des planètes géantes que la rotation planétaire dicte le bal. Avec des périodes de rotation de 10 à 17 heures, et des inclinaisons d’axe magnétique pouvant aller jusqu’à 60° (pour Uranus), la dynamique globale des magnétosphères géantes est absolument fascinante [6].

Que peuvent nous apprendre les autres planètes magnétisées ?

La magnétosphère de la Terre permet aussi de faire de la planétologie comparée : l’étude de l’interaction du vent solaire avec les autres planètes du Système solaire est essentielle à la compréhension de notre situation terrestre. De la génération du champ magnétique à la dynamique globale de la magnétosphère, en passant par des phénomènes étudiés aux toutes petites échelles, l’observation et l’exploration des autres planètes nous apportent des éléments de réponse indispensables à la construction de notre puzzle scientifique.

Le premier constat que l’on peut faire, c’est que toutes les planètes n’ont pas un champ magnétique global, à l’échelle de la planète. Vénus et Mars n’ont en effet pas (ou plus) de champ magnétique. Cela pose de grandes questions, notamment sur le rôle du champ magnétique planétaire dans la protection du développement de la vie. Et bien sûr, dans le cas de Mars, la question de l’envoi d’astronautes et des effets du vent solaire sur les organismes et les installations artificielles est délicate. En revanche, étrangement, Mercure a gardé un champ magnétique certes peu intense, mais suffisant pour soutenir une petite magnétosphère. C’est la seule magnétosphère du Système solaire dont l’échelle de distance caractéristique (mesurée par la position de la magnétopause côté jour) est du même ordre de grandeur que le rayon de la planète elle-même. Pour les autres magnétosphères planétaires (lire encadré 3), la planète est bien plus petite, et peut-être quasiment considérée comme un point par rapport à la totalité de la magnétosphère. Les planètes géantes ont en effet des champs magnétiques très intenses. La reine des magnétosphères planétaires est celle de Jupiter : la queue de la magnétosphère de Jupiter s’étend jusqu’à l’orbite de Saturne !

Les magnétosphères des planètes géantes sont plus ou moins bien connues, en fonction du nombre de missions spatiales qui ont été dédiées à chacune d’entre elles. Mais en combinant mesures in situ et observations au télescope (notamment les radiotélescopes ou les observatoires spatiaux comme Hubble), on arrive à trouver moult indices qui permettent de reconstituer d’incroyables raisonnements scientifiques : par exemple, on étudie l’interaction de la magnétosphère de Saturne avec ses anneaux, l’impact de la lune magnétisée Io sur les aurores polaires de Jupiter, ou encore on retrouve l’orientation du champ magnétique d’Uranus grâce aux quelques pixels lumineux qui correspondent aux aurores sur la planète [4] !

Toutes ces découvertes sont bien sûr à mettre en parallèle avec l’observation des exoplanètes ! Les interactions étoiles-exoplanètes magnétisées commencent à être détectées, ouvrant tout un nouveau domaine de recherche passionnant sur l’interaction des étoiles avec leurs planètes. Le vent solaire est donc, sous bien des aspects, une composante essentielle de l’astrophysique actuelle.

Léa Griton | Institut de recherche en astrophysique et planétologie, Toulouse

Publié dans le magazine L’Astronomie Février 2021

Notes

1. Pour en savoir plus sur l’histoire de la découverte du vent solaire, on conseille l’ouvrage de référence (en anglais) de Nicole Meyer-Vernet et celui de Fabrice Mottez, Aurores polaires – La Terre sous le vent du Soleil, Éditions Belin (en français), 2017. 2. Notamment grâce aux coronographes, voir l’article sur l’histoire des observations solaires dans l’Astronomie, no 143. Ce projet est financé par l’European Research Council sous la direction d’Alexis Rouillard, chargé de recherches au CNRS. 4. Lire l’article de Laurent Lamy sur la magnétosphère de Saturne paru dans l’Astronomie no 125, mars 2019. 5. Voir entre autres Goedbloed and Poedts (2004) ou Russell et al. (2016). 6. Je reviendrai dessus plus en détail dans un prochain article, mais pour les curieux, mon manuscrit de thèse est téléchargeable en ligne : [http://www.theses.fr/2018PSLEO006].

par Sylvain Bouley | Oct 16, 2023 | Zoom Sur

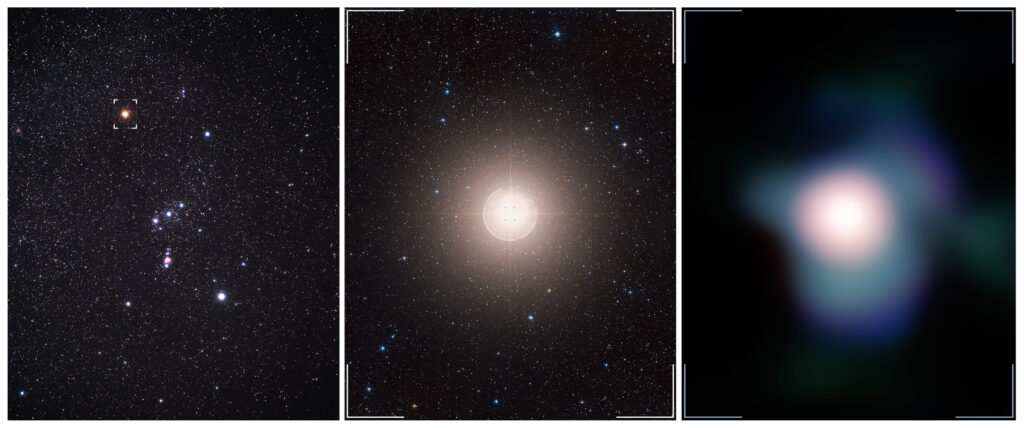

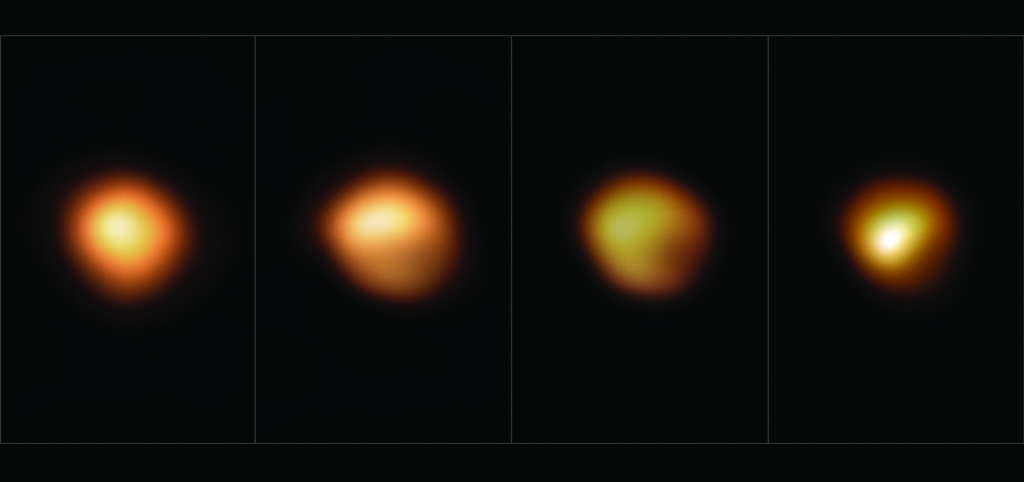

L’intérêt des observations prétélescopiques pour l’astrophysique moderne

Dagmar et Ralph Neuhäuser ont étudié les observations de couleur des étoiles consignées dans des textes anciens, notamment ceux décrivant les observations de ce que nous appelons maintenant des supernovae. Ils ont ainsi montré que l’étoile Bételgeuse a changé de couleur au cours des derniers siècles. Cette observation permet de mieux contraindre sa masse, son état évolutif, et de permettre une prédiction quant à l’époque où elle deviendra elle aussi une supernova. Ce texte, traduit en français par Fabrice Mottez pour l’Astronomie, a été publié très récemment en anglais dans la revue Astronomy & Geophysics [1].

« Voici que, directement au-dessus de ma tête, j’aperçus soudain une étoile étrange, dont la lumière brillait d’un éclat radieux et frappa mes yeux. Étonné, stupéfait, je suis resté immobile, les yeux fixés sur elle pendant un certain temps et j’ai remarqué qu’elle était placée près des étoiles que l’Antiquité attribuait à Cassiopée [2]. »

C’est ainsi que le jeune astronome danois Tycho Brahe (1546-1601) décrivit sa première observation de la nova stella le soir du 11 novembre 1572, après que le temps couvert eut empêché les jours précédents sa surveillance habituelle du ciel. Il y a 450 ans, la nouvelle étoile est apparue, à quelques degrés seulement du W céleste, dans la constellation de Cassiopée. Elle avait déjà été observée, le 6 novembre, par Maurolyco (Sicile, Italie), Schuler (Wittenberg, Allemagne) et en Corée. Si Brahe, qui devint plus tard astronome à la cour de l’empereur Rodolphe II à Prague, ne fut pas le premier à observer ce que nous appelons aujourd’hui la supernova 1572, il en avait bel et bien effectué les mesures les plus détaillées et les plus précises, publiées intégralement dans son ouvrage posthume Astronomiae instauratae progymnasmata : « Je commençai à mesurer sa position et sa distance par rapport aux étoiles voisines de Cassiopée et à noter avec un soin extrême ce qui était visible à l’œil concernant sa taille apparente, sa forme, sa couleur et d’autres aspects [3]. »

On pourrait regretter que les deux plus brillantes supernovae visibles à l’œil nu, celle de 1572 et celle de 1604 (cette dernière a été intensivement suivie, peu après la mort de Brahe, par son ancien assistant, Johannes Kepler), se soient produites quelques années seulement avant l’invention du télescope. Aucune supernova galactique n’a été aussi brillante depuis lors. Cependant, les observations de Tycho Brahe sur la position de la supernova et ses variations de luminosité et de couleur sont l’exemple même de la manière dont les observations non télescopiques devraient être utilisées pour acquérir de nouvelles connaissances scientifiques, autrefois comme aujourd’hui.

« Elle n’était pas aussi rouge que celui de l’épaule mais plutôt de la couleur d’Aldébaran »

En tant qu’astronome de la cour danoise et disposant d’un budget important, Brahe pourra par la suite développer et construire des instruments toujours plus grands dans son propre atelier, afin d’améliorer continuellement la précision astrométrique de ses mesures. Cependant, en 1572 et en 1573, il dut se contenter d’un petit sextant à main pour mesurer la position de la nova. Pourtant, dans sa première publication (en 1573) sur la nouvelle étoile, il concluait avec minutie : « Il est maintenant évident […] puisque après plusieurs mois, elle n’a pas avancé d’une minute par son propre mouvement depuis l’endroit où je l’ai vue pour la première fois […] que cette nouvelle étoile ne se trouve donc ni dans la région sublunaire ni dans les orbites des sept étoiles errantes, mais dans la huitième sphère, parmi les autres étoiles fixes [4]. »

Tycho fondait ses considérations sur le système géocentrique classique, aristotélicien et ptolémaïque, même s’il était également réceptif aux théories coperniciennes (qu’il avait présentées et améliorées). Il avait bien compris qu’il n’y avait pas encore de preuve du mouvement de la Terre autour du Soleil ni de la rotation de la Terre autour de son propre axe, lesquels ne seraient démontrés que bien plus tard. Au lieu de cela, il développa un système intermédiaire, appelé aujourd’hui le système tychonique, dans lequel le Soleil et la Lune gravitent autour de la Terre, mais où les autres planètes gravitent directement autour du Soleil.

Tycho Brahe suivit méticuleusement non seulement la position de la nouvelle étoile (qui se révéla fixe – sic !), mais aussi les variations de sa luminosité : « Lorsqu’elle fut vue pour la première fois, la brillance de la nova surpassait celle de toutes les étoiles fixes, Véga et Sirius comprises. Elle était même un peu plus brillante que Jupiter, qui se levait alors au coucher du Soleil, de sorte qu’elle égalait Vénus lorsque cette planète brillait au maximum de son éclat […]. La nova est restée à peu près aussi brillante pendant presque tout le mois de novembre. Par temps clair, de nombreux observateurs la virent en plein jour, même à midi […]. La nova était aussi brillante que Vénus en novembre. En décembre, elle était à peu près égale à Jupiter [5]. »

Les mesures de positionnement par Tycho ont été utilisées au xxe siècle [6] pour déterminer les coordonnées précises de la supernova, c’est-à-dire de la grande sphère gazeuse, toujours en expansion et presque symétrique. Cela a conduit en 1952 à l’identification du reste de la supernova grâce à ses émissions en radio. En outre, les données de Brahe sur la luminosité ont pu être utilisées par Baade, en 1945, pour construire la courbe de lumière de la nova stella et la classer comme une supernova de type I (aujourd’hui Ia). Il est particulièrement profitable que Brahe ait toujours cité des objets pour les comparer à ses observations, de sorte que nous pouvons aujourd’hui les convertir en valeurs de magnitude précises.

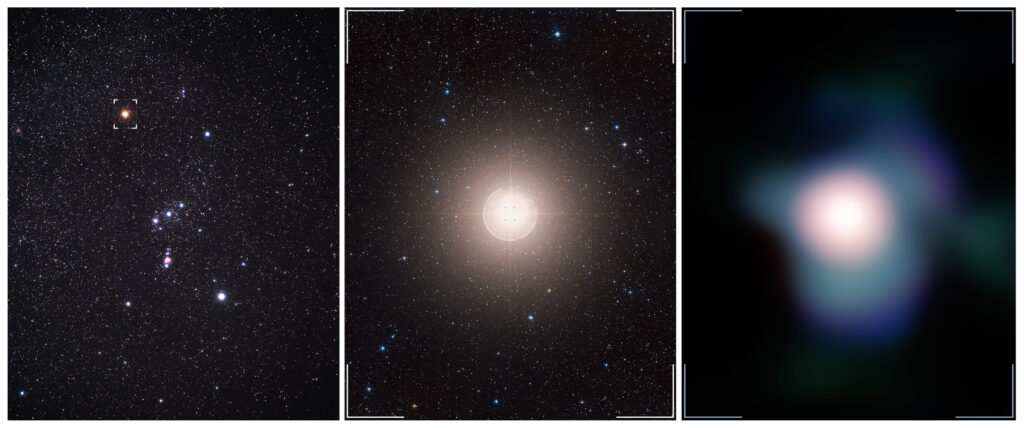

Brahe a utilisé une technique similaire pour la variation de couleur : « En ce qui concerne la couleur de cette étoile, elle n’est pas toujours restée la même, au début on la voyait blanchâtre, et elle se rapprochait d’une lueur semblable à celle de Jupiter, mais, au fil du temps, en se réduisant, son éclat dégénéra en une rougeoyante lueur de Mars : elle était comme Aldébaran, ou celle qui est rouge dans l’épaule droite d’Orion [c’est-à-dire Bételgeuse]. Mais elle n’était pas aussi rouge que celle de l’épaule, mais plutôt de la couleur d’Aldébaran [7] » (fig. 1).

Des déterminations et des spécifications plus précises des couleurs et de leurs petites différences sont difficilement imaginables s’agissant d’observations à l’œil nu !

1. Les principales étoiles d’Orion pendant le grand assombrissement (tournant 2019-2020) de Bételgeuse en 2019 et 2020. Bételgeuse, alpha Orionis, « la main de la géante » en haut à gauche, est restée rouge pendant sa phase d’assombrissement. L’étoile bleue Bellatrix (gamma Orionis, « la guerrière ») est en haut à droite ; la blanc bleuâtre Rigel (bêta Orionis) est en bas à droite, et la bleue Saiph (kappa Orionis) en bas à gauche. Au milieu, on peut voir les trois étoiles bien alignées du baudrier, d’où pend l’épée d’Orion avec la fameuse nébuleuse M 42. (ESO)

En décembre 2019, Bételgeuse qui est la plus célèbre des étoiles supergéantes rouges apparaît moins lumineuse que d’habitude. (ESO)

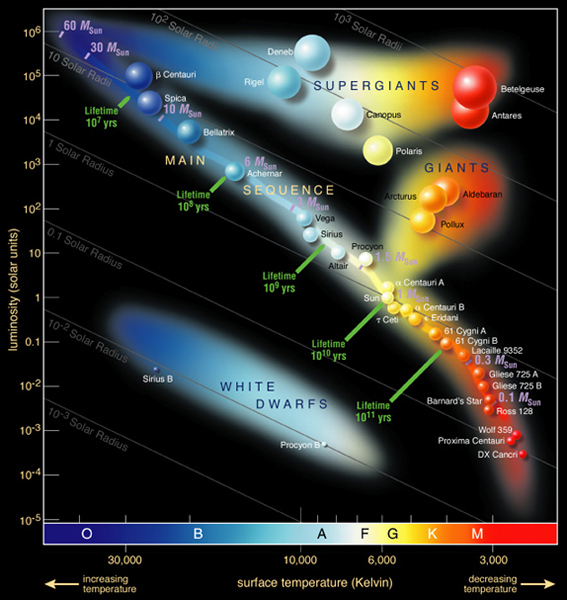

Les indices de couleur et un test pratique

Aujourd’hui, nous utilisons ce que l’on appelle l’indice de couleur pour quantifier la couleur d’une étoile ou d’une planète ; il s’agit de la différence de luminosité de deux gammes de longueurs d’onde, par exemple B-V dans le bleu et le visuel, l’unité étant la magnitude (mag). De tels indices de couleur sont à nouveau qualifiés par des termes de couleur : « rouge » pour B-V ≥ 1,4 mag ; « orange » pour B-V dans l’intervalle 0,8-1,4 mag ; « jaune » pour B-V = 0,6-0,8 mag ; « blanc » pour B-V = 0,0-0,3 mag [8] ; « bleu » pour B-V ≤ 0,0 mag. Le « vert » (B-V = 0,3-0,6 mag) n’est pas discernable comme couleur d’étoile par l’œil humain, mais apparaît comme jaunâtre ou blanchâtre.

Bien que la délimitation exacte des frontières entre les gammes de couleur soit un problème quelque peu secondaire, les indices de couleur ainsi définis coïncident dans l’ensemble avec notre perception quotidienne des couleurs des étoiles, ainsi qu’avec celle des observateurs chevronnés avant l’utilisation des télescopes. Il n’est pas justifié de considérer la perception des couleurs des étoiles comme purement subjective, ni individuellement ni pour une culture entière : notre vaste compilation de toutes les études prétélescopiques connues sur la couleur des étoiles montre que, lorsque les observateurs prétélescopiques spécifiaient la couleur d’une étoile, même en utilisant un simple terme (par exemple « rouge »), cela reflétait approximativement l’indice de couleur B-V correspondant (Neuhäuser et al., en préparation).

L’astronome espagnole Pilar Ruiz-Lapuente [9] a utilisé les données de couleur de Tycho et d’autres pour en déduire les indices de couleur correspondants et classer à nouveau SN 1572 dans le type Ia (explosion thermonucléaire d’une ou deux naines blanches). En 2022, lors de la réunion annuelle de la Société européenne d’astronomie, à Valence, en Espagne, au cours de sessions spéciales célébrant le 450e anniversaire des observations de supernova par Tycho Brahe, nous avons pu montrer que des questions subtiles concernant la datation, la sursaturation à la luminosité excessive autour du pic et la conversion des termes du texte en indices numériques – en tenant également compte d’autres observations provenant d’Europe, d’Arabie et d’Asie de l’Est – peuvent conduire à des détails supplémentaires concernant le sous-type, qui permettront de déterminer si SN 1572 est une supernova de type Ia « normale » ou ayant une phase d’intensification lumineuse rapide.

En effet, un observateur expérimenté peut discerner de petites variations ou différences d’indice de couleur, même sans télescope ni autre instrument. Cela peut être facilement vérifié par exemple en comparant Bételgeuse elle-même (l’épaule orientale d’Orion) à Aldébaran (l’œil du Taureau), ainsi qu’à Pollux dans les Gémeaux et à Capella dans le Cocher ; tandis que cette dernière apparaît clairement jaunâtre à la plupart des observateurs (B-V = 0,8 mag), Pollux présente une teinte rose (B-V = 0,97 mag), Aldébaran apparaît encore plus rose (B-V = 1,48 mag) et Bételgeuse, bien sûr, est maintenant la plus rouge d’entre toutes ces étoiles (B-V = 1,78 ±0,05 mag). (La gamme d’indices de couleur donnée pour Bételgeuse provient de divers phénomènes de variabilité qui se combinent.) D’autres étoiles rougeâtres, visibles en hiver, période de l’année ou apparut la nova stella, sont observées dans Andromède (Mirach avec B-V = 1,59 mag), dans le Bélier (Hamal avec B-V = 1,16 mag), ainsi que dans la zone circumpolaire (Kochab, bêta UMi, avec B-V = 1,48 mag) ou Dubhé (alpha UMa avec seulement 1,06 mag). Antarès, dans le Scorpion, est l’étoile brillante la plus rouge (Antarès A, sa primaire, a pour indice B-V = 1,88 mag), mais elle est à peine visible pendant l’hiver boréal.

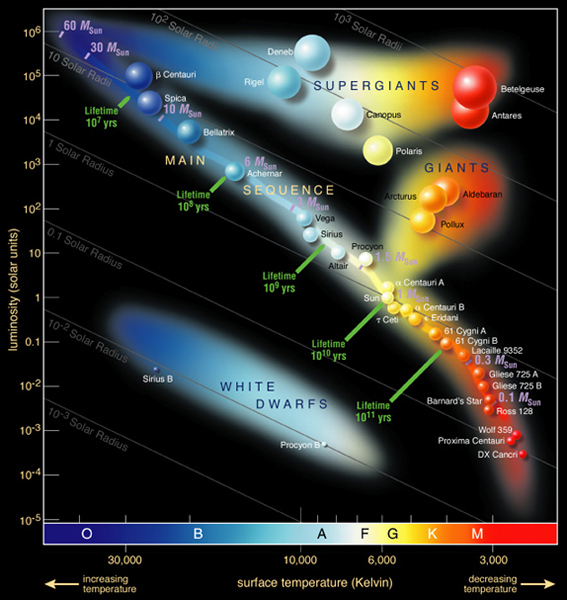

Diagramme de Hertzsprung-Russell

Lorsque la nouvelle étoile montra son rougeoiement maximal, Tycho Brahe nota : « Elle était comme Aldébaran, ou celle qui est rouge dans l’épaule droite d’Orion [c’est-à-dire Bételgeuse]. Mais elle n’était pas aussi rouge que celle de l’épaule, mais plutôt de la couleur d’Aldébaran. »

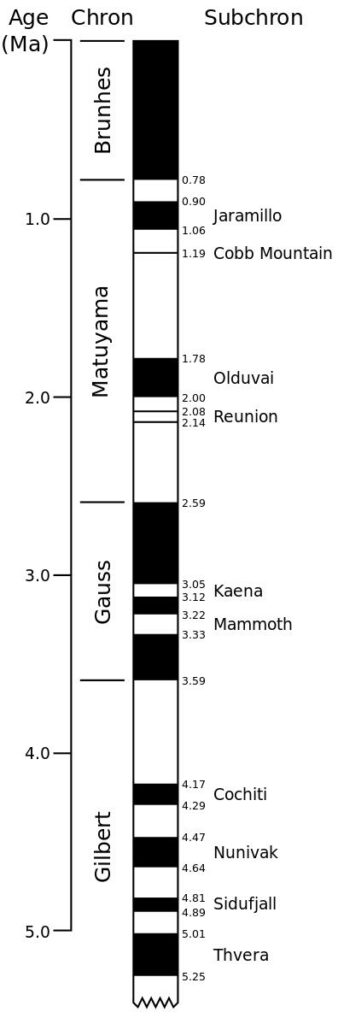

Ce texte n’illustre pas seulement la technique, à savoir donner des objets de comparaison, mais indique clairement que Bételgeuse était plus rouge, même légèrement, qu’Aldébaran. Aujourd’hui, Aldébaran et Bételgeuse ont des indices de couleur qui diffèrent de 0,3 mag, et cette différence est facilement perceptible à l’œil nu. Était-elle plus faible à l’époque de Tycho ? La couleur des étoiles change-t-elle donc avec le temps ?