par Sylvain Bouley | Avr 10, 2021 | Zoom Sur

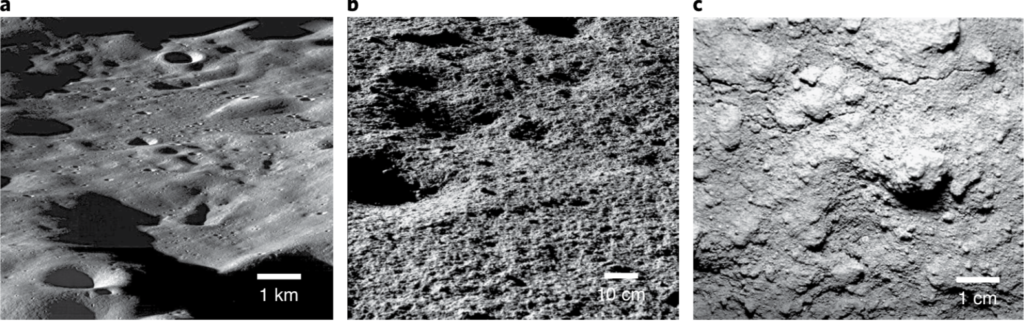

Nous allons voir ici comment un trou noir supermassif se dévoile aux observateurs, et quelles sont ses répercussions sur la galaxie qui l’abrite, pourtant mille fois plus massive et un milliard de fois plus grande. Par ailleurs, ayant participé moi-même pendant cinquante ans à l’étude de ces trous noirs, je me suis permis à plusieurs reprises de prendre un ton personnel pour raconter cette histoire.

Introduction

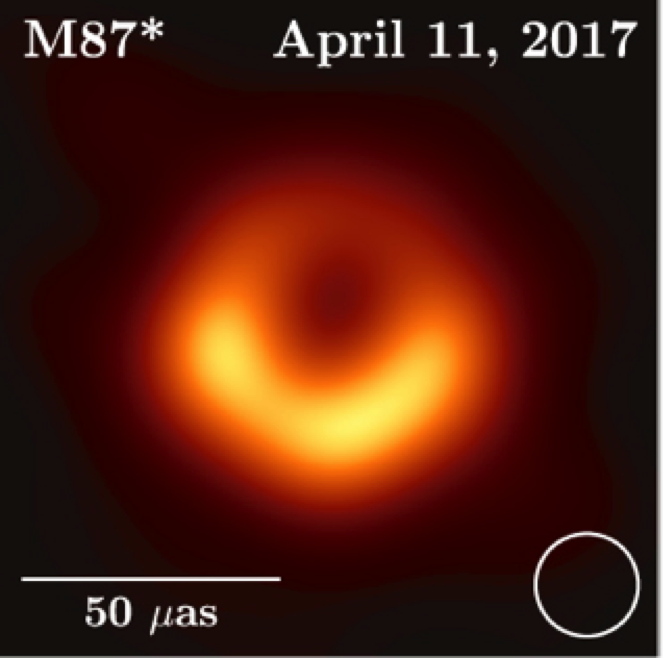

L’annonce le 11 avril 2019 de l’observation d’un trou noir (« la photo » comme on l’a dit souvent) a déclenché une vague de commentaires superlatifs des médias. Il faut dire qu’il s’agissait effectivement à la fois d’une prouesse technologique et d’une victoire de la science (l’Astronomie, numéro 128, Juin 2019).

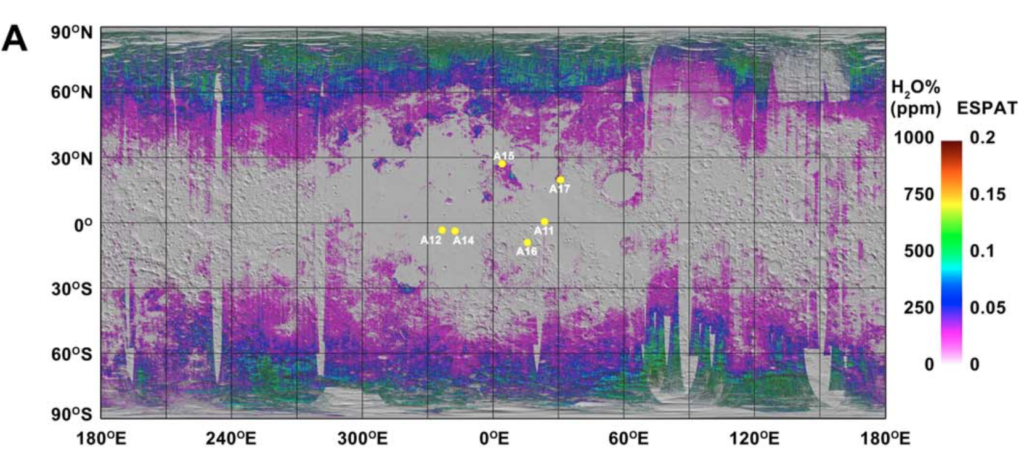

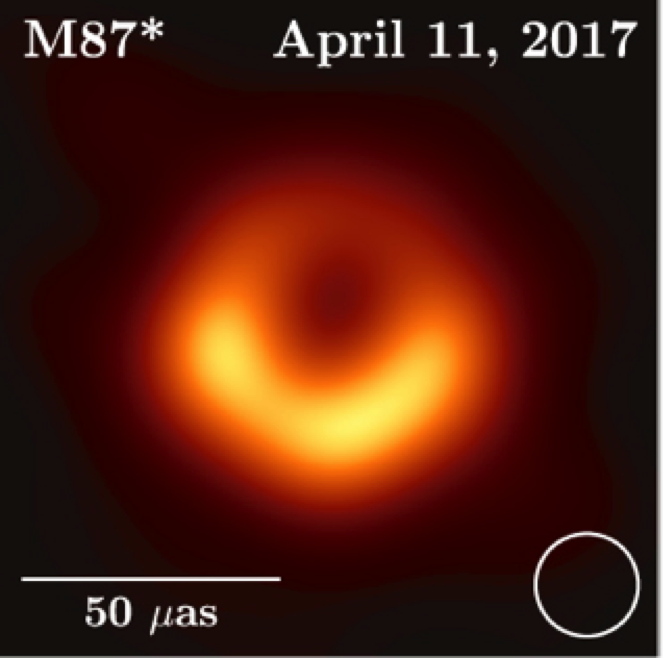

Figure 1 – L’image du trou noir au centre de la galaxie m87, dévoilé le 11 février 2019 par l’observation en interférométrie dans le domaine radio. Le cercle en bas à droite représente la taille du lobe. on distingue le « disque d’accrétion », plus intense dans la direction du mouvement. (Collaboration EHT)

En effet, lorsque le physicien allemand Karl Schwarzshild propose en 1916, quelques semaines avant de mourir d’une pneumonie sur le front russe, une solution des équations de la relativité générale qu’Einstein avait publiées l’année précédente, pour une masse sphérique sans rotation, peu de gens y prêtent attention, et Einstein moins que quiconque ; car il ne croira jamais à cette solution, qui prendra en 1967 le nom de « trou noir ».

Nul n’ignore maintenant ce que sont les « trous noirs », ces astres dont rien ne peut s’échapper, ni la lumière, ni la matière, dès qu’elles se trouvent à l’intérieur d’une région de l’espace-temps limitée par une frontière immatérielle nommée : « Event Horizon » (horizon des évènements). Il en est d’ailleurs question presque chaque mois dans les actualités. On connaît actuellement des trous noirs de masses très différentes, depuis quelques masses solaires jusqu’aux trous noirs « supermassifs » de cent mille à des milliards de masses solaires. C’est de ceux-ci que nous allons parler dans cet article. Celui dont on vient de découvrir l’image au centre de la galaxie M87 (Virgo A, Fig. 1) en fait partie : sa masse est égale à 6 milliards de fois celle du Soleil.

Petit historique, des quasars aux trous noirs : 1943, 1952, 1963, trois dates fondatrices dans l’observation et l’identification des trous noirs.

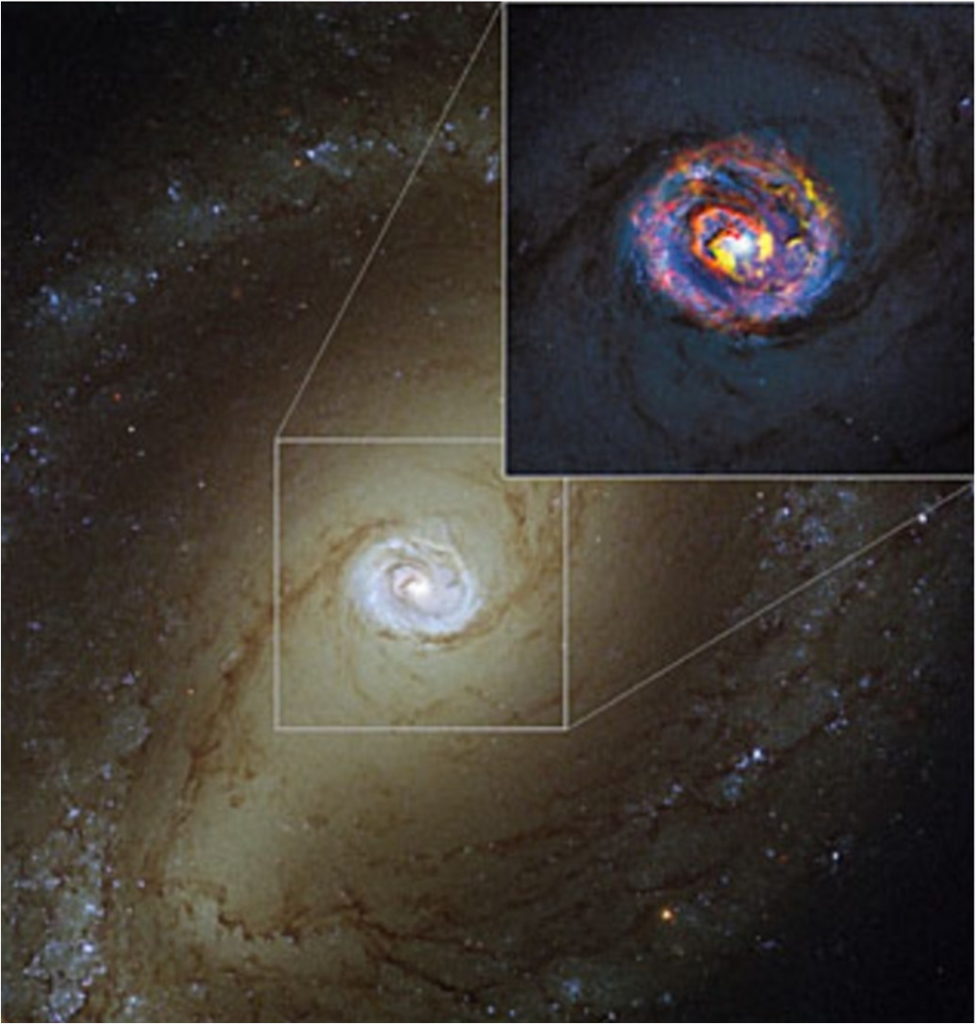

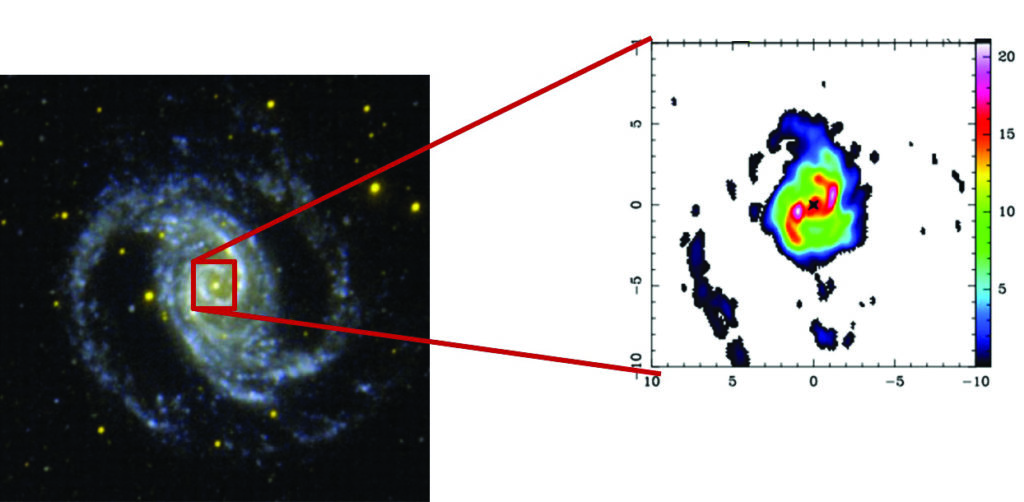

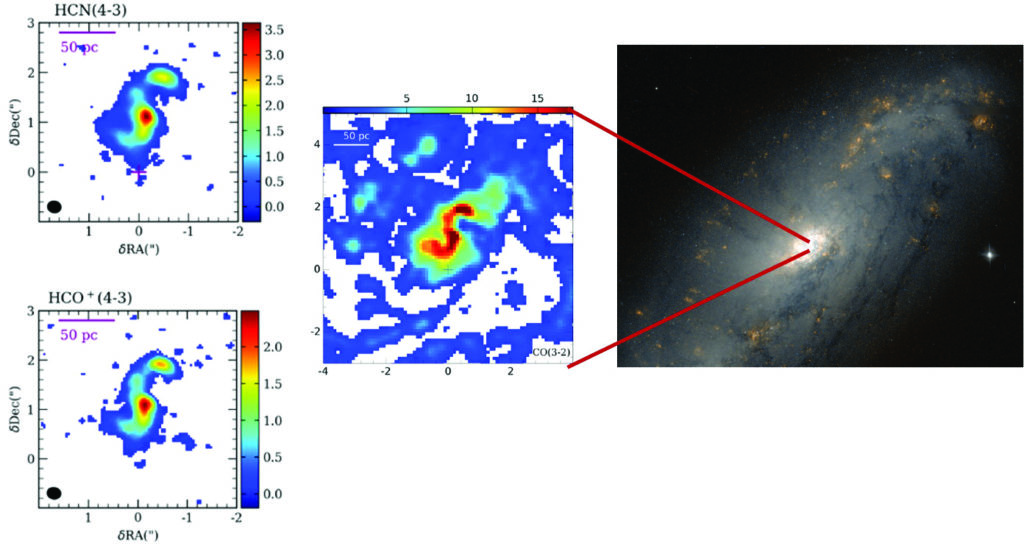

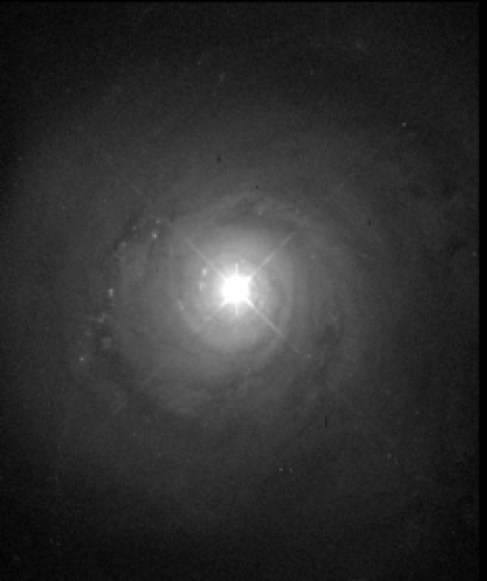

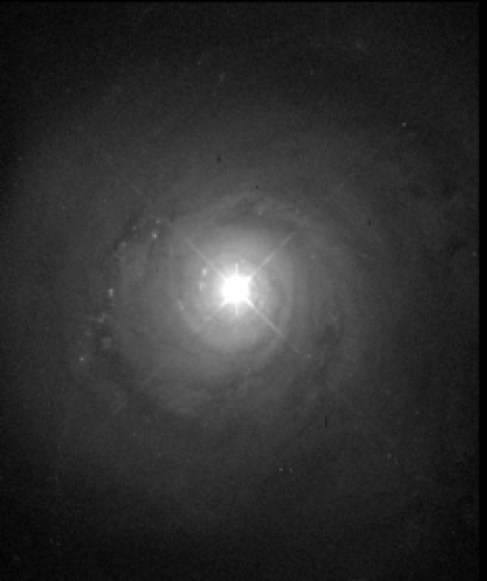

En 1943, un jeune chercheur américain travaillant à l’observatoire McDonald au Texas, Carl Seyfert, publie un article dans lequel il étudie six galaxies possédant un noyau ponctuel brillant dont le spectre présente des raies en émission intenses superposées à un continu bleu. Ce sont les mêmes raies que celles des nébuleuses planétaires, mais beaucoup plus « larges ». Seyfert attribue cette largeur à des vitesses de plusieurs centaines à plusieurs milliers de km/s (c’est une conséquence de l’effet Doppler). La figure 2 montre l’image de l’une de ces galaxies (qu’on appelle simplement « Seyfert »).

Figure 2 – La galaxie de seyfert NGC 5548 obtenue avec le télescope spatial Hubble. on distingue la croix de diffraction prouvant que le noyau n’est pas résolu. La galaxie est vue presque de face. (Nasa)

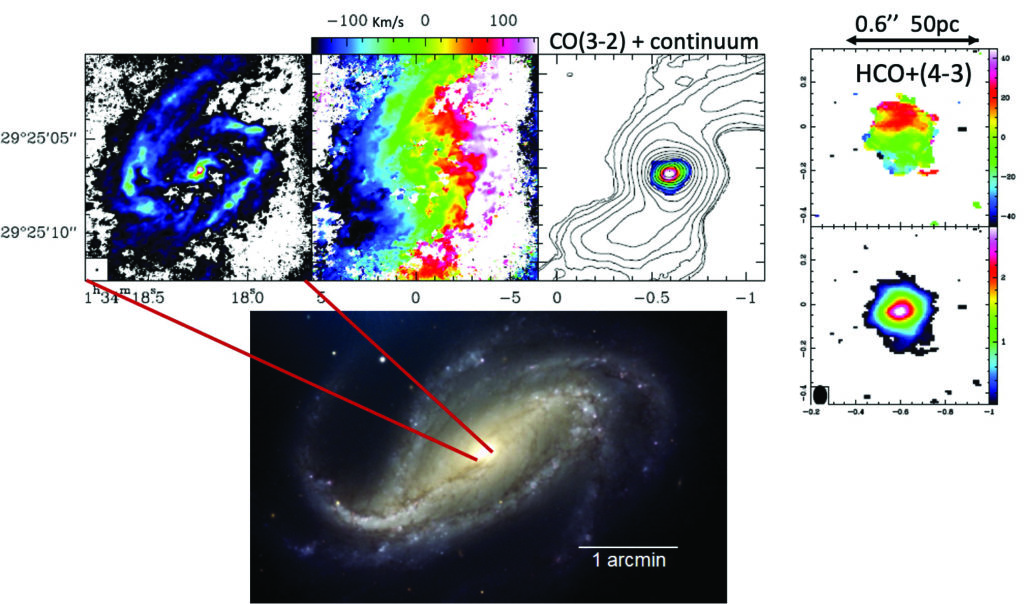

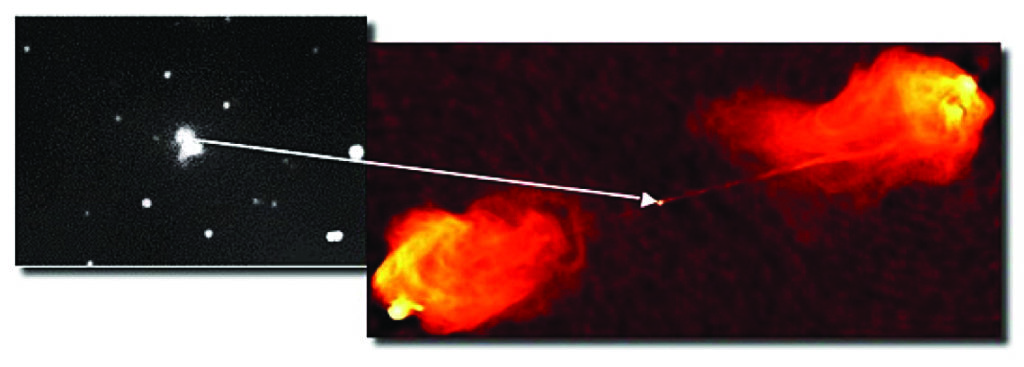

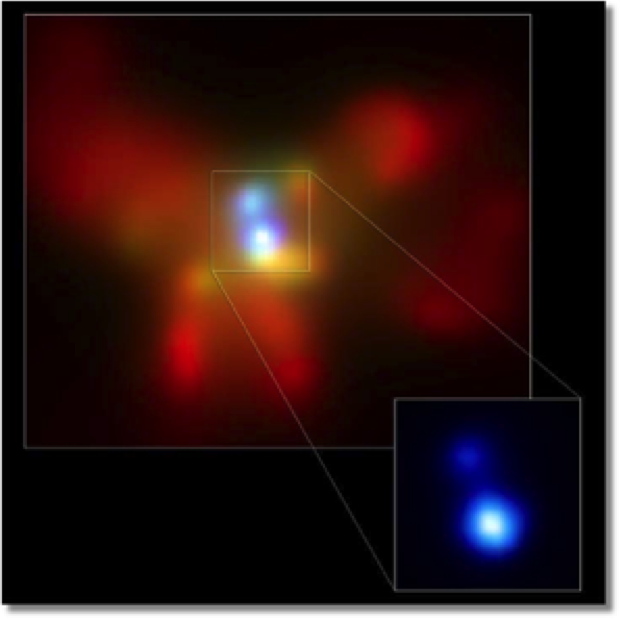

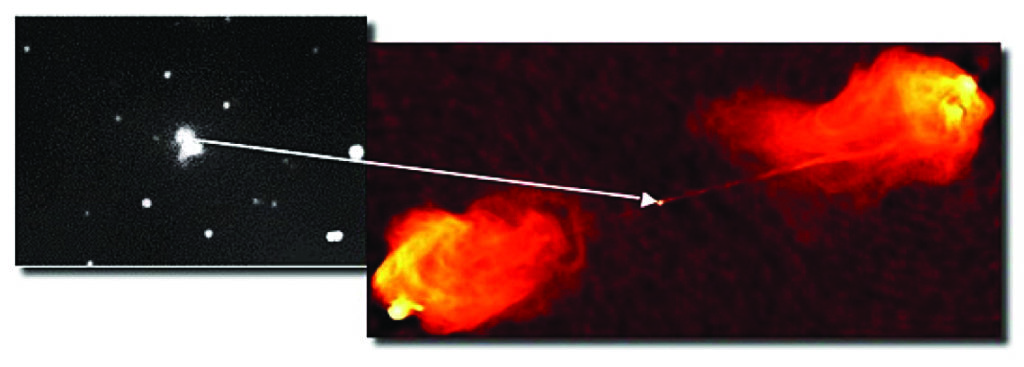

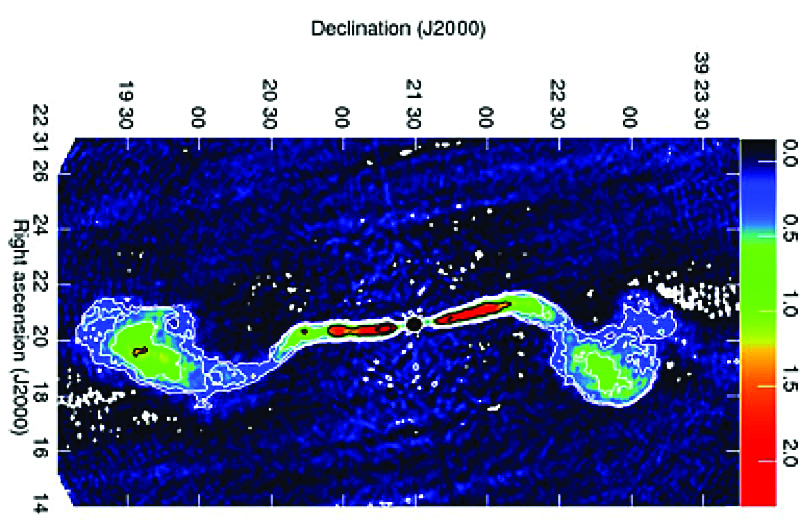

La deuxième date importante est 1952. À la fin des années quarante, on avait commencé à observer le ciel dans le domaine des ondes radio, entre autre en France avec des radars abandonnés par les allemands après la seconde guerre mondiale. Les américains Baade et Minkowski découvrent alors que deux sources émettant un rayonnement radio intense sont des galaxies : M87 (celle de l’image du trou noir !) et Cygnus A (Figs. 3 et 4). M 87 possède un jet sortant du cœur de la galaxie (on comprendra plus tard son importance). Cygnus A est une galaxie lointaine qui semble constituée de deux galaxies en collision (là aussi on verra plus loin l’importance de cette observation). Ces « radiogalaxies », ainsi que celles qui sont découvertes par la suite, sont beaucoup plus puissantes dans le domaine radio que les autres galaxies, typiquement par un facteur 10 000.

Figure 3 – À gauCHE, la galaxie Cygnus A en lumière visible. À drOiTE, image radio en fausses couleurs de la galaxie (petit point au centre) obtenue dans les années 1980, montrant de grands lobes radio très brillants à leurs extrémités, et un filament joignant la galaxie au lobe de droite. La distance projetée sur le ciel entre les extrémités des deux lobes est de 300 000 années-lumière. (Nra0 pour l’image radio)

Quelle est l’explication de ce rayonnement ? Elle ne se fait pas attendre car, par un concours de circonstances dont la science est coutumière – observation et théorie s’épaulant mutuellement – on découvre qu’il correspond à un processus qui se produit dans les nouveaux accélérateurs nommés « synchrotrons ». Il s’agit du rayonnement de particules chargées plongées dans un champ magnétique, se déplaçant à une vitesse très proche de celle de la lumière (on dit qu’elles sont « relativistes »). On l’appelle naturellement « rayonnement synchrotron ». Le britannique Goeffrey Burbidge – il faut préciser son prénom car son épouse, Margaret, joua un rôle considérable dans l’étude des quasars et des galaxies actives – montre immédiatement que l’énergie totale stockée dans un tel système correspond à la transformation en énergie de 100 millions de masses solaires !

Figure 4 – La galaxie m87 prise au télescope Hubble. on distingue le jet provenant du noyau. (Nasa)

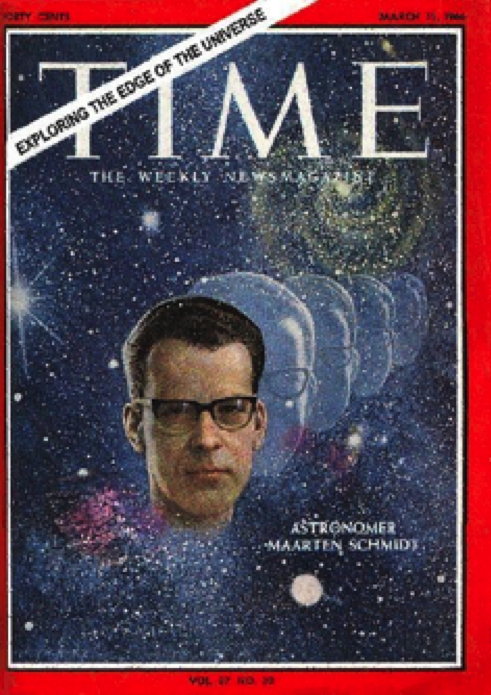

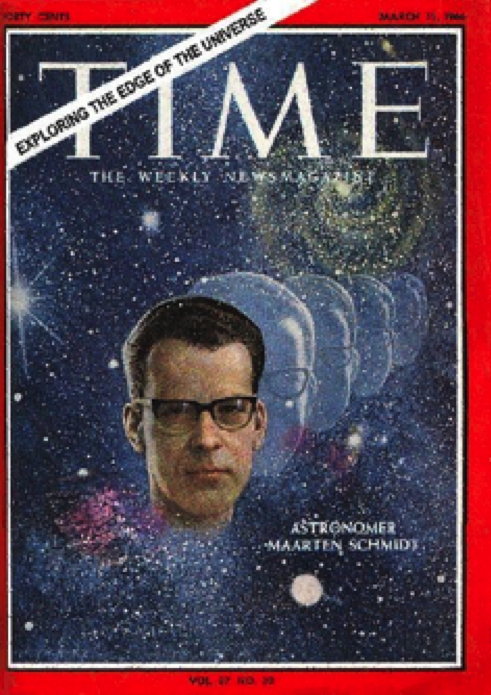

Le troisième événement fondateur se produit en 1963. Le 3ème catalogue de radio-sources de l’observatoire de Cambridge (en Angleterre) vient d’être publié, et la source numéro 273 (appelée 3C 273 donc) a la bonne idée de passer deux fois dernière la Lune en 1962 ; ce qui permet à un radioastronome australien nommé Hazard (ça ne s’invente pas !) de déterminer sa position avec exactitude. Pile à cette position se trouve une étoile bleue de 13ème magnitude. C’est faible, mais ce n’est pas un problème pour un jeune astronome néerlandais, Marteen Schmidt, qui travaille au Caltech (Pasadena, Californie) et peut utiliser le télescope Hale de 5 mètres du Mont Palomar. Il en prend le spectre et découvre un continu bleu sur lequel se superposent des raies inconnues brillantes et larges. Il comprend qu’il s’agit des raies de la série de Balmer de l’hydrogène, mais toutes décalées de 16% vers le rouge par rapport à leurs longueurs d’onde habituelles. D’autres radiosources sont rapidement identifiées, présentant également un décalage spectral vers le rouge (on utilise le terme anglais plus court de « redshift », ou la lettre z = (lobslémis)/ lémis, où lobset lémis sont les longueurs d’onde observée et émise). On les appelle bientôt « quasars », terme contracté de « quasi stellar objects », indiquant qu’ils ressemblent à de simples étoiles sur les photographies [1] (voir sur la figure 5 la page de garde du Time consacré à M. Schmidt). Presque immédiatement, en 1965, l’américain Allan Sandage découvre une population bien plus importante de quasars ne rayonnant pas dans le domaine radio.

Figure 5 – L’annonce de la découverte des quasars par marteen schmidt fait la une du Time Magazine, vol. 87, no 10, 11 mars 1966.

Il est rapidement admis que les redshifts sont dus à l’expansion de l’Univers, et que ces objets se trouvent par conséquent à des distances de plusieurs milliards d’années-lumière. Certains sont également variables en quelques jours (c’est le cas de 3C 273 qui figure depuis cent ans dans le catalogue d’étoiles variables de Harvard), ce qui signifie qu’ils sont petits, puisqu’on les confond avec des étoiles. Et on en arrive à la conclusion inévitable : les quasars ont une puissance de 100 à 1000 galaxies dans un rayon de l’ordre du Système solaire ! [2]

Dès 1964, deux astrophysiciens, le Russe Zeldovich et l’Américain Salpeter, émettent l’hypothèse qu’il s’agit de trous noirs. À l’époque, ceux-ci ont la cote chez les physiciens. J’ai moi-même assisté en 1966 à des cours de relativité générale donnée par le jeune Kip Thorne (qui a reçu en 2019 le prix Nobel pour les ondes gravitationnelles), et ceux qui y étaient avec moi avaient du mal à retenir leur rire lorsque Thorne nous expliquait qu’un homme franchissant l’horizon d’un trou noir pouvait devenir infiniment long ou infiniment plat, et que le temps s’arrêtait pour un observateur extérieur (Fig. 6). Nous avions du mal admettre que ces choses pouvaient avoir le moindre rapport avec les quasars ! Les astronomes et les physiciens n’étaient pas encore prêts à se parler comme ils le feront vingt ans plus tard…

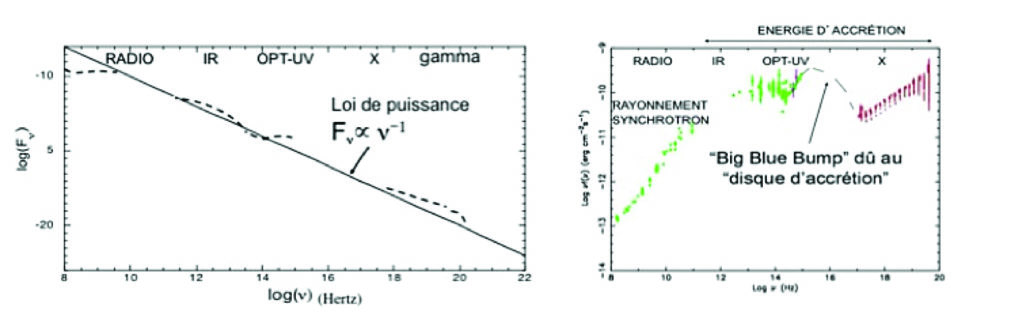

Figure 6. Dessin de PEZ.

Par analogie avec les radiogalaxies qui contiennent également une énorme quantité d’énergie, on attribue à cette époque tout le rayonnement des quasars à du synchrotron, depuis le domaine radio jusqu’au domaine X – car on a commencé à observer dans ces bandes dès 1960 à l’aide de satellites artificiels, et on a découvert qu’ils sont de puissants émetteurs infrarouges, ultraviolets et même X. Et pendant quelque temps, on pense que les quasars sont le lieu d’énormes explosions générant des particules relativistes. Puisque les étoiles à neutrons, très compactes, existent, alors les trous noirs, qui correspondent à un état à peine plus petit et massif, pourraient exister aussi. D’autant que l’on découvre dans un couple stellaire une étoile compacte qui semble bien être un trou noir, Cygnus X1. Et du coup, puisqu’on se convainc que des trous noirs de la masse d’une étoile existent, et puisque leur masse n’a pas grande importance dans la controverse, on admet la possibilité de trous noirs bien plus massifs.

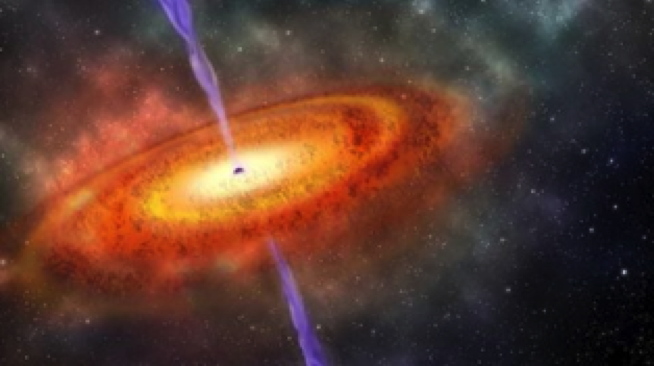

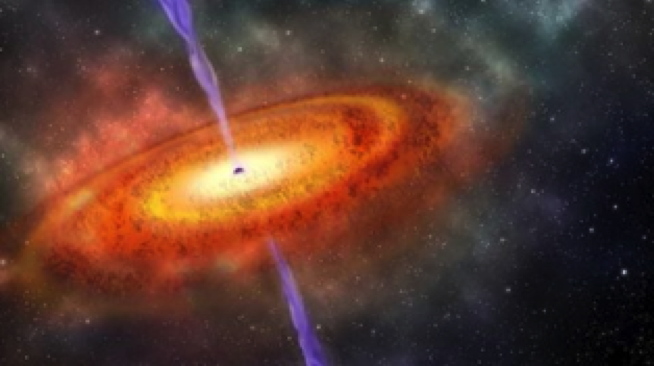

En 1973, deux astronomes soviétiques proposent dans un article devenu « viral » que les trous noirs stellaires sont alimentés par un « disque d’accrétion » (Fig. 7). Pourquoi un disque ? Parce que la matière qui s’approche d’un trou noir a une probabilité très faible d’y tomber directement, mais va tourner autour comme un satellite artificiel autour de la Terre. Grâce à une viscosité provoquée par la turbulence, elle spirale en perdant une grande partie de son énergie de mouvement sous forme de lumière et en se rapprochant lentement du trou noir. Lorsqu’elle atteint enfin son horizon, sa vitesse de rotation est pratiquement égale à celle de la lumière, et elle a perdu jusqu’à la moitié de son énergie de masse (E=Mc2).

Figure 7 – Vue d’artiste d’un disque d’accrétion, avec un jet au centre. Wikipedia

On avait d’autre part dès 1964 fait le parallèle entre les galaxies de Seyfert et les quasars : petite taille, couleur bleue, mêmes raies spectrales (une fois pris en compte le redshift des quasars). On avait réalisé dès lors que les quasars sont simplement des noyaux de galaxies ayant subi dans le passé une phase très « active » ; et c’est à ce moment qu’on avait créé le terme « Noyaux Actifs de Galaxies », AGN en anglais, qui désigne à la fois les quasars et les noyaux des galaxies de Seyfert, puis plus tard également les radiogalaxies comme M 87. Les galaxies de Seyfert sont moins lumineuses que les quasars, mais comme elles sont plus proches, elles sont plus brillantes et accessibles à de plus petits télescopes. C’est à cette époque que j’ai décidé de travailler sur ce sujet et de les observer.

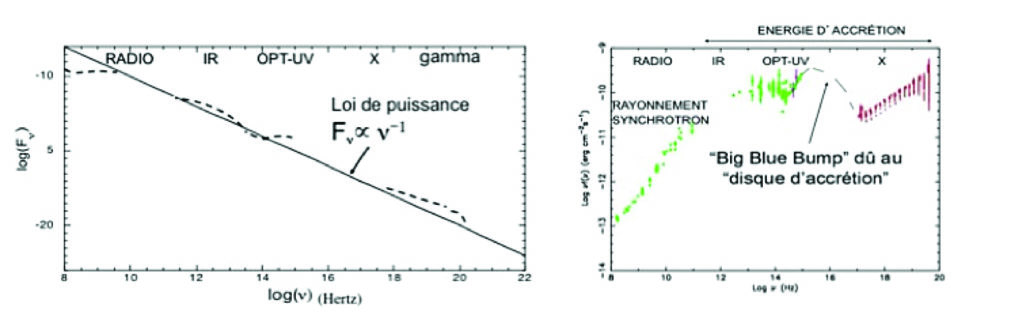

Et finalement en 1977, le britannique Martin Rees montre qu’inévitablement un noyau de galaxie qui contient un amas dense d’étoiles doit évoluer vers la formation d’un trou noir supermassif. En 1978, un jeune chercheur américain, Greg Schields, remarque que le rayonnement de 3C273 n’est pas synchrotron, mais bel et bien dû à ce disque d’accrétion qui va devenir désormais une composante fondamentale des AGN (Fig. 8). Et c’est à partir de ce moment seulement que le paradigme de l’accrétion sur un trou noir supermassif est accepté pour les AGN. Il n’a jamais été remis en cause depuis.

Figure 8 – Distribution de l’énergie du quasar 3C 273, avec deux représentations. Celle de gauche montre pourquoi on a pu confondre ce spectre avec du synchrotron en ν–1 (lire l’actualité p. 8, l’Astronomie n° 124). Crédit S. Collin-Zahn

Les trous noirs « dormants »

Comme le montrent leurs grands redshifts, les quasars sont des objets lointains, situés à des milliards d’années-lumière. Nous les voyons donc tels qu’ils étaient il y des milliards d’années. Que sont-ils devenus maintenant ? Le Britannique Lynden-Bell avait dès 1969 émis l’idée qu’ils se retrouvaient sous forme de quasars « morts » dans les noyaux des galaxies proches de nous, et même dans la nôtre, mais son idée avait fait long feu. Treize ans plus tard, le Polonais Soltan eut l’idée de déterminer la luminosité totale de tous les quasars observés, et il en déduisit, en supposant que l’efficacité de transformation de la masse en énergie était en moyenne de 10% – ce qui est le cas pour les quasars – la masse totale accumulée sous forme de trous noirs. Cette masse étant très supérieure à celle des AGN proches, la conclusion inévitable était qu’elle devait se trouver dans les noyaux des galaxies ordinaires. Curieusement, les calculs qu’il avait effectués avec des hypothèses simplistes se sont avérés justes lorsque l’on a pu déterminer les masses des trous noirs supermassifs situés dans les noyaux des galaxies proches de nous ! On sait donc maintenant que les galaxies ordinaires contiennent un trou noir supermassif éteint, triste résidu d’un quasar qui brilla intensément pendant des dizaines de millions d’années.

Ne croyons cependant pas ce trou noir complètement mort. Quand les quasars s’éteignent, leurs trous noirs deviennent « dormants », mais ils sont susceptibles de se réactiver dès que de la matière s’en approche un peu trop près. Et c’est bien ce qui s’est produit pour le trou noir de notre Galaxie dont nous reparlerons plus loin : bien qu’extrêmement faible en ce moment, il a subi il y a quelques centaines d’années une augmentation de son rayonnement dans le domaine gamma, dont les nuages moléculaires environnants ont gardé la preuve. Il est probable que ce phénomène s’est produit et se reproduira à de nombreuses reprises. L’ogre est toujours là, tapi au centre de la galaxie, et il attend son heure…

Pourquoi les AGN différent-ils tant les uns des autres ?

Avant d’aborder ce problème, il faut préciser qu’un trou noir est un objet extrêmement simple, en fait le plus simple qui existe dans l’Univers : il ne dépend que de deux paramètres, sa masse et sa rotation [3]. Or ce qui avait frappé les découvreurs des quasars et des radiogalaxies, c’est que des objets très différents (on pourrait mentionner les Blac ou lacertides, les blazars, les radiogalaxies, les objets violemment variables ou OVV…) présentent tous la propriété d’émettre une quantité de rayonnement non stellaire très supérieure à celle d’une galaxie « ordinaire ». Il est clair qu’ils tirent tous leur énergie d’un trou noir central. Donc, outre la masse et la rotation du trou noir, il existe des causes extérieures de différentiation.

Influence de l’inclinaison.

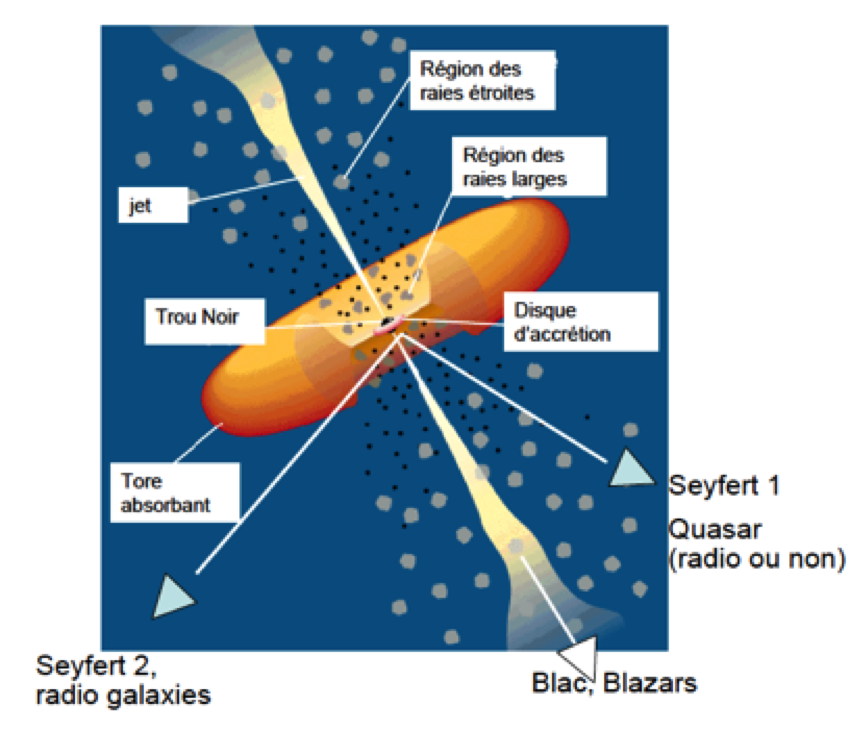

Le plus évident, et c’est bien ce qui a été découvert d’abord, c’est que, puisque que le trou noir est nourri par l’intermédiaire d’un disque, l’inclinaison du disque sur la ligne de visée doit jouer un rôle majeur dans l’apparence des objets.

Prenons les noyaux des galaxies de Seyfert. Il en existe deux sortes : les Seyfert 2, dont les raies, relativement étroites, correspondent à quelques centaines de km/s de largeur, et les Seyfert 1, dont les raies, larges, correspondent à plusieurs milliers de km/s. Comme il est naturel, les raies larges proviennent d’une région située à quelques années-lumière du trou noir, tandis que les raies étroites proviennent d’une région située plus loin, à quelques centaines d’années-lumière [4]. En 1985, une étude polarimétrique de la Seyfert 2 NGC 1068 montre que c’est en fait une Seyfert 1 vue en quelque sorte « par la tranche », c’est-à-dire dans une direction proche du plan du disque d’accrétion qui cache la région des raies larges. On en déduit que au moins certaines Seyfert 2 sont des Seyfert 1.

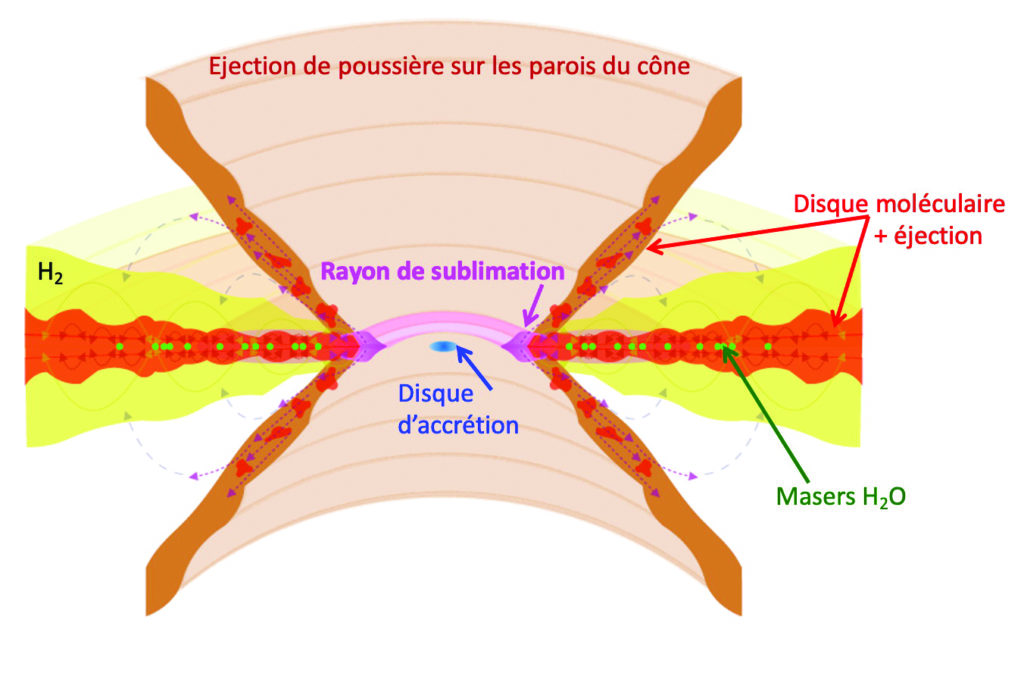

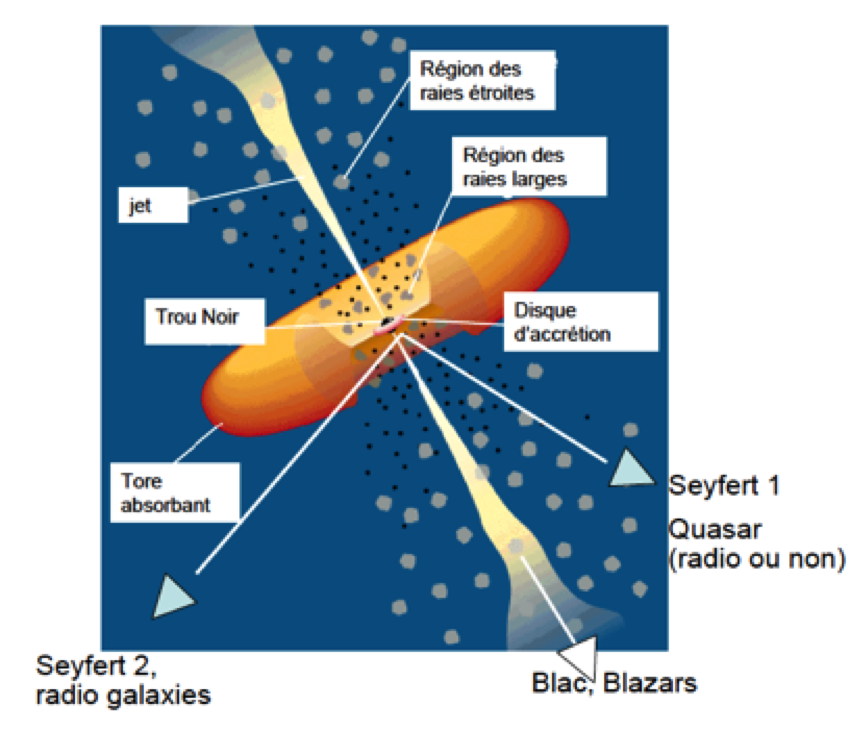

Cette découverte a été la première dans la direction d’une unification des AGN. Elle a abouti quelques années plus tard au schéma suivant, toujours d’actualité (Fig. 9). On reconnait les régions de production des raies larges des Sefert 1, et des raies étroites des Seyfert 2, plus distantes du noyau. On voit que le disque d’accrétion est prolongé par ce que l’on nomme « le tore moléculaire », ou « tore absorbant » sur la figure 9, sorte de disque épais fait de poussières et de molécules. Il constitue la partie externe du disque d’accrétion et cache la partie centrale de l’objet. On ignore d’ailleurs le mécanisme par lequel la matière transite depuis les régions plus extérieures du tore vers le disque lui-même. Sur ce schéma, nous voyons aussi que des objets comme les BLacs et les Blazars sont vus dans la direction d’un jet. On en comprendra plus tard la raison. On commence alors à représenter systématiquement les AGN avec un disque et un jet.

Figure 9 – Schéma unifié des AGN proposé en 1995 par Urry et Padovani

Influence de la masse et du taux d’accrétion

L’une des raisons évidentes de différentiation des trous noirs supermassifs, c’est qu’ils n’ont pas nécessairement la même masse ni la même luminosité. Précisons que désormais je dirai qu’un trou noir « rayonne » une certaine quantité d’énergie, alors qu’il est bien évident que ce n’est pas le trou noir qui rayonne, mais son environnement proche.

Parlons d’abord de la masse. Le principe de la détermination de la masse d’un objet massif quelconque consiste toujours à étudier le mouvement de la matière qui se trouve à proximité, sur laquelle il exerce une influence gravitationnelle dominante. S’il s’agit d’étoiles en orbite, on peut mesurer sa masse en appliquant les lois de Kepler-Newton (c’est ce qui a été fait pour le trou noir central de la Voie lactée). Dans le cas d’un ensemble d’étoiles animées de vitesses aléatoires autour du trou noir, sa masse est à peu près égale à la distance moyenne des étoiles divisée par le carré de la vitesse moyenne [5].

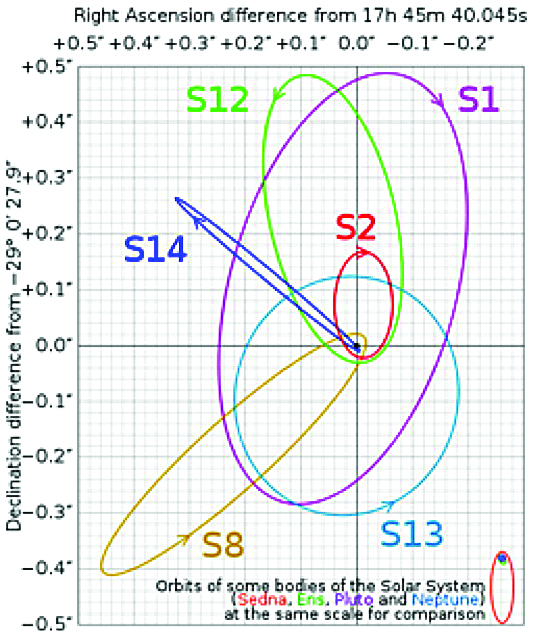

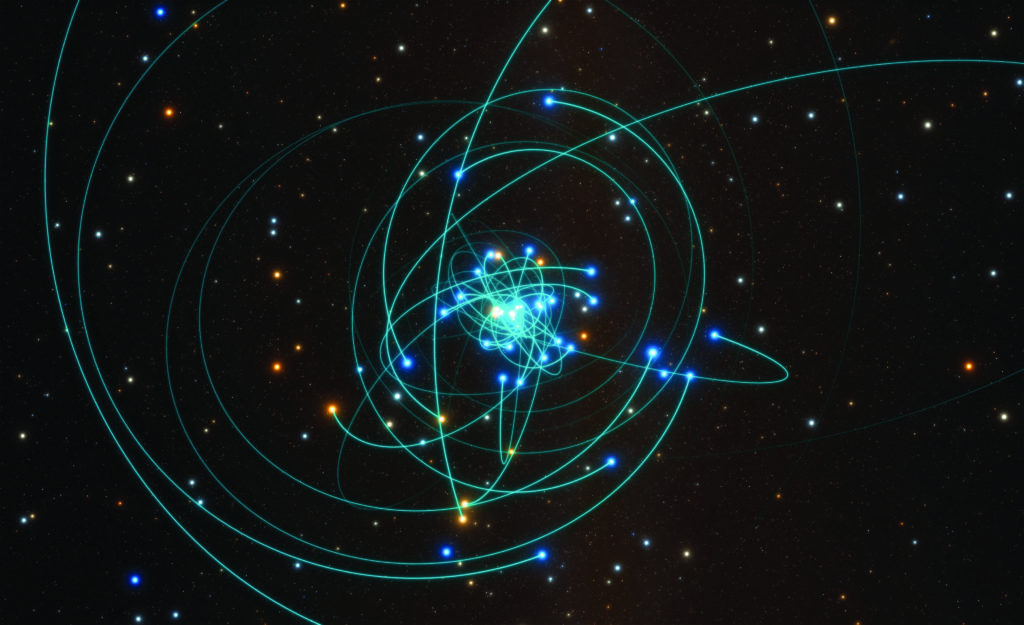

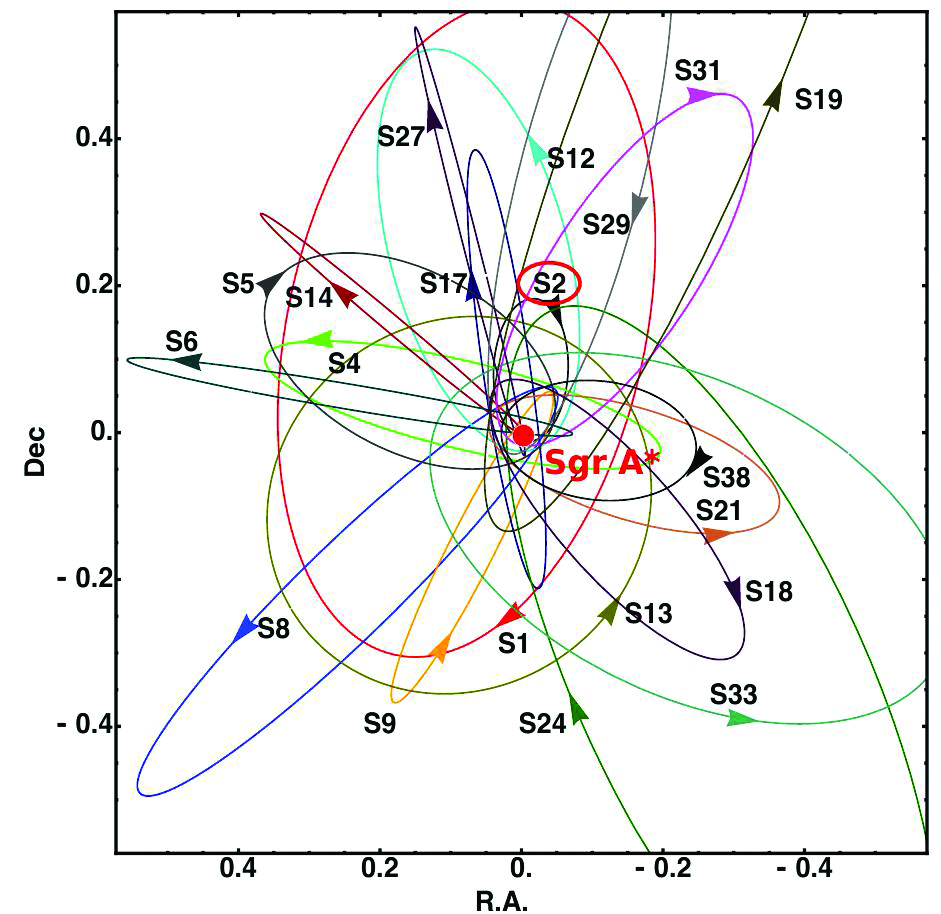

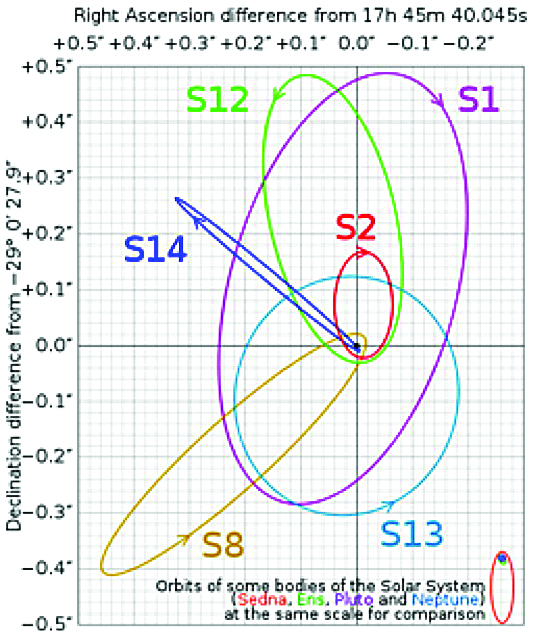

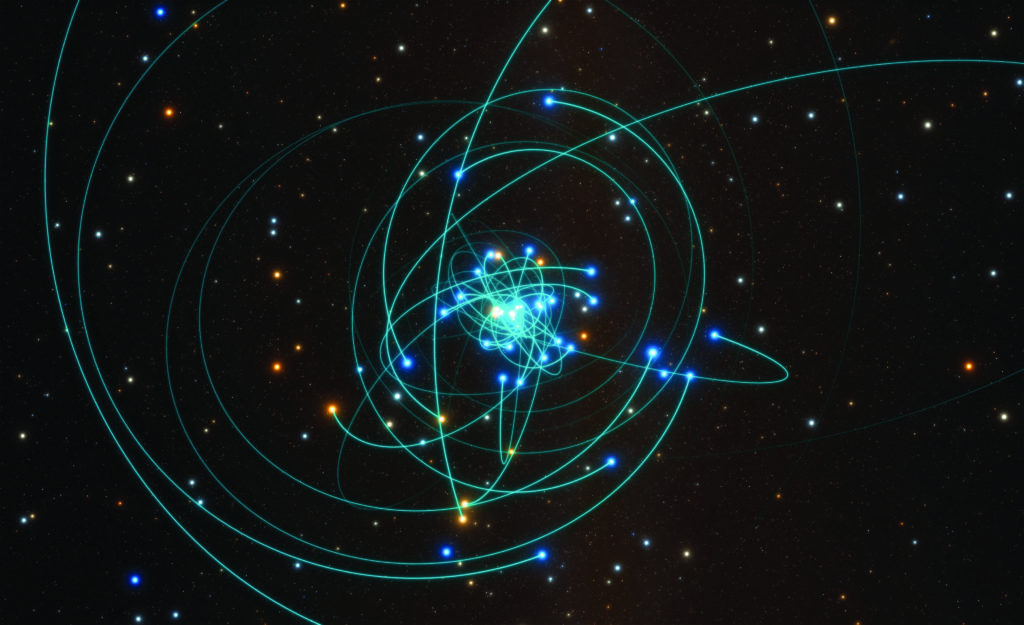

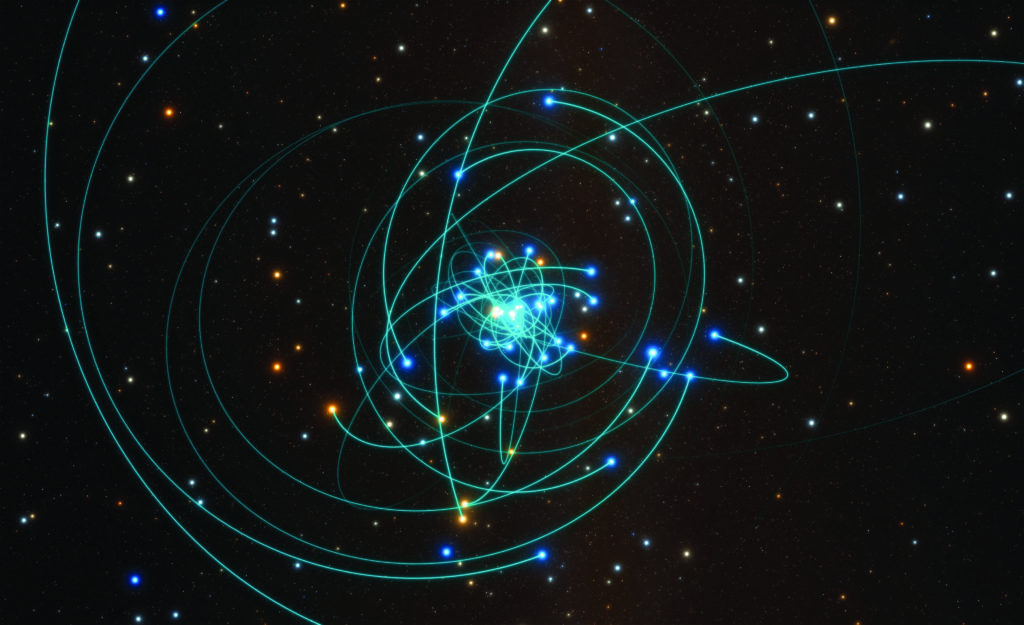

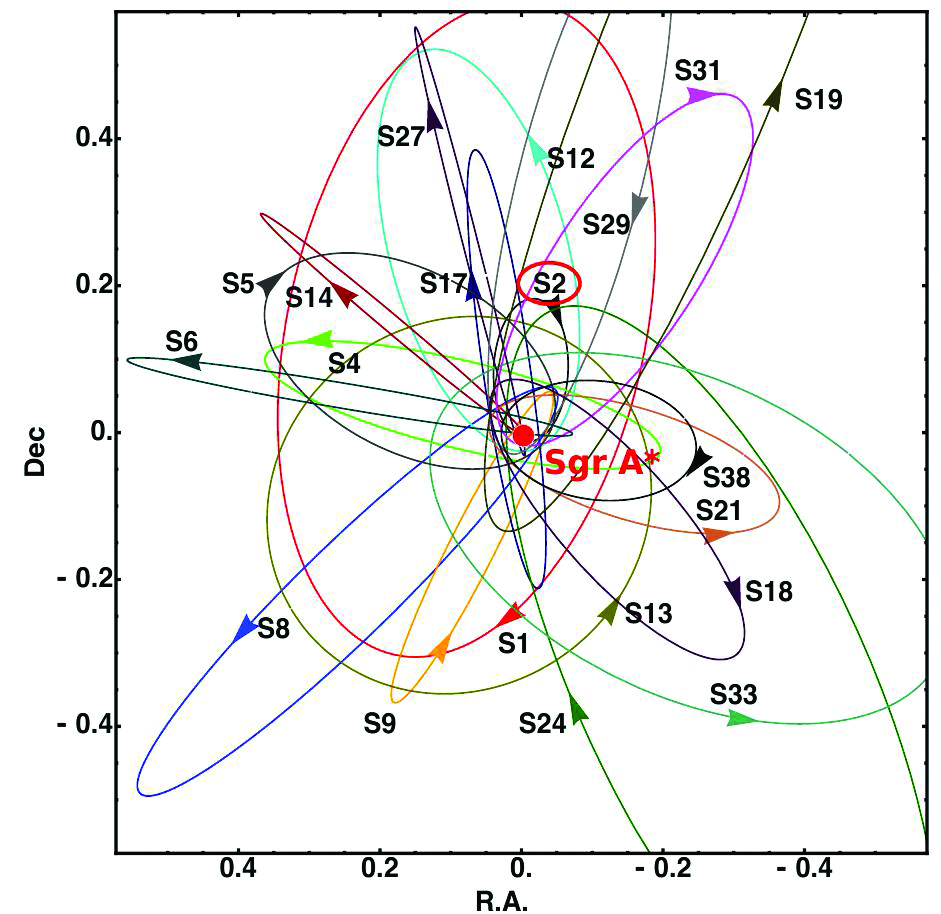

On ne mesure pas la masse d’un trou noir de la même façon s’il est actif ou dormant, ni s’il est proche ou lointain. Ainsi, pour une cinquantaine d’AGN relativement proches, les variations des raies spectrales larges [6] suivies pendant de nombreuses années ont fourni des masses assez précises (disons à un facteur deux près), qui, extrapolées aux autres AGN, ont donné les masses – moins précises – pour des milliers d’autres AGN. Pour les trous noirs dormants, on se sert de la dispersion de vitesse au centre du bulbe [7], là où la masse du trou noir est encore dominante. Naturellement, cette méthode ne peut être utilisée que pour des galaxies assez proches. Enfin, il faut mentionner deux objets exceptionnels où la masse du trou noir est mesurée avec une grande précision. Dans NGC 4258 (M106), on a pu observer les mouvements képlériens de sources à la surface du disque d’accrétion, et on en a déduit la masse du trou noir avec une grande précision (38 millions de masses solaires). Quant au centre de la Voie lactée, une campagne d’observation de vingt ans combinant les mesures de mouvements propres et de vitesses radiales a permis de déterminer la masse d’un objet invisible situé à la position d’une faible radio source, Sagittarius A* (Sgr A*). Il s’agit d’un trou noir de 4,15 millions de masses solaires, une bien petite masse au regard de ceux d’autres galaxies (Fig.10) [8]. Ce trou noir est entouré d’étoiles parcourant des orbites képlériennes. Certaines s’en approchent avec des vitesses de plusieurs milliers de kilomètre par seconde. On a découvert récemment qu’il possède un minuscule disque d’accrétion de moins de 1000 UA de rayon, et qu’il subit de violents sursauts d’activité qui se produisent probablement tout près de son horizon (voir l’Astronomie 130 et / ou, 131, 133, 135).

.

Figure 10 – orbites de quelques étoiles autour de sgr A*. Le trou noir est le point noir. (LESIA – Obs. de Paris)

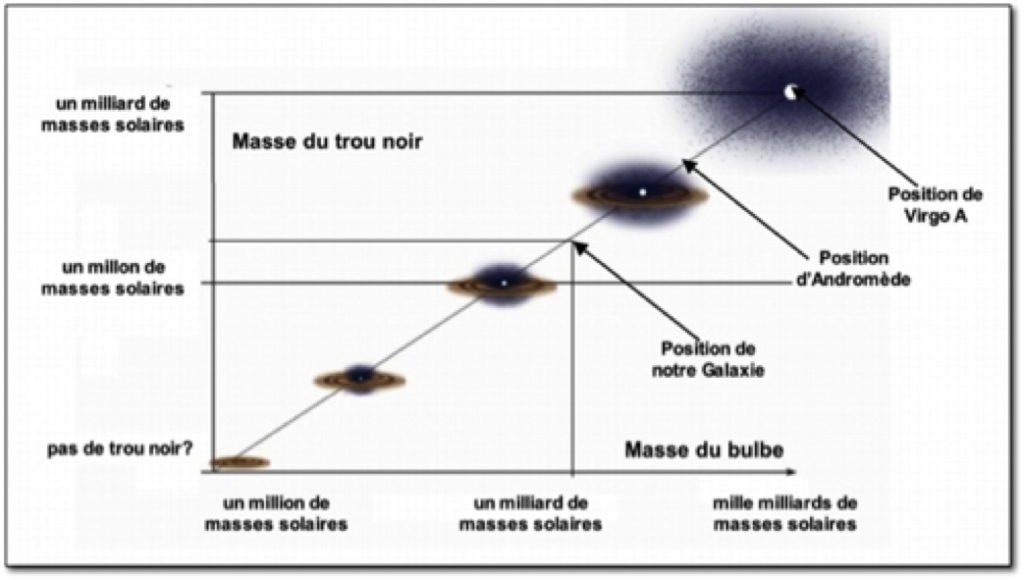

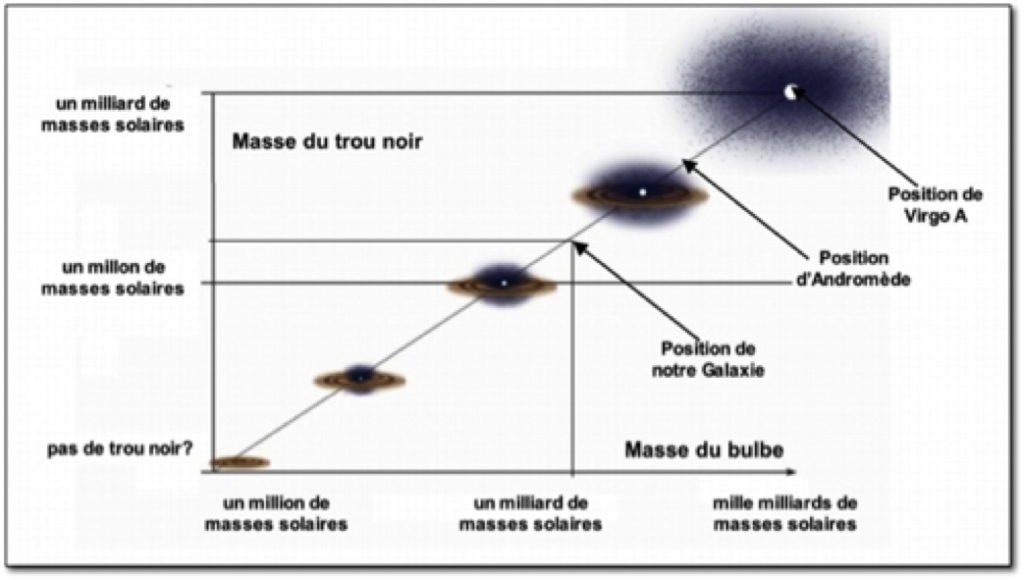

La découverte la plus inattendue concernant les trous noirs supermassifs, qu’ils soient actifs ou dormants, est la relation qu’ils entretiennent avec le bulbe de la galaxie au centre de laquelle ils se cachent : le trou noir a une masse voisine du millième de celle du bulbe (Fig. 11). Un trou noir, dont le rayon est de l’ordre du millième d’année-lumière, est donc relié fortement au bulbe, dont la dimension est dix à cent millions de fois plus grande ! En fait, aussi étrange que cela paraisse, c’est le trou noir qui a une influence déterminante sur son hôte, par l’intermédiaire des vents et des jets puissants qu’il génère et qui ont pour effet de chauffer et de chasser le gaz, interdisant toute croissance ultérieure de la galaxie. On a l’habitude d’appeler cette rétroaction le « feedback ». Mais il y a une autre cause possible à la relation trou noir/bulbe. En effet, les trous noirs grossissent lors des fusions de galaxies, et les simulations numériques montrent que les fusions ont pour effet de créer des galaxies elliptiques, ou de façon générale des galaxies à gros bulbe. Bref, comme toujours en astrophysique, il est probable que les choses soient complexes et que les deux phénomènes jouent un rôle tour à tour.

FIgure 11 – La relation entre la masse du trou noir et la masse du bulbe. (S. Collin-Zahn)

Pourtant, ce n’est pas la masse, mais la luminosité du trou noir qui détermine les propriétés des AGN. Intuitivement, on penserait que la luminosité est tout simplement proportionnelle à la quantité de gaz avalée par le trou noir par unité de temps – le taux d’accrétion. Et c’est effectivement ce qui se passe tant que ce taux n’est ni trop grand ni trop petit. La région centrale du disque d’accrétion est alors portée à une température de quelques dizaines de milliers de degrés et il rayonne avec une grande efficacité dans le domaine ultraviolet. C’est le cas des quasars et des galaxies de Seyfert. Mais lorsque le taux d’accrétion est très grand, le disque est si épais que la lumière ne peut pas s’en échapper comme piégée dans cette matière, et qu’elle est engloutie avec elle dans le trou noir. Ces cas sont rares et ne se produisent que lorsque le trou noir est encore peu massif et enrobé d’une épaisse gaine de gaz. À l’inverse, lorsque le taux d’accrétion est trop petit, le disque devient presque transparent, il chauffe et gonfle, les vitesses deviennent aléatoires au point que les particules tombent radialement dans le trou noir sans avoir le temps de rayonner. C’est le cas le plus fréquent des trous noirs dormants, dont fait partie Sagittarius A*.

En fait, ce n’est pas réellement le taux d’accrétion qui est trop grand ou trop petit, mais ce taux ramené à la masse du trou noir. Car pour une masse donnée, un trou noir ne peut rayonner au delà d’une limite appelée « limite d’Eddington [9], qui est proportionnelle à sa masse. Et la quantité qui paraît finalement la plus importante pour façonner les AGN, c’est la luminosité rapportée à la limite d’Eddington.

Les jets

Nous avons mentionné à plusieurs reprises le « jet ». Il est omniprésent dans les radiogalaxies où il domine souvent sur le rayonnement provenant du disque d’accrétion. Par contre, il est quasiment inexistant dans les galaxies de Seyfert et les quasars non radio. Constitué de particules se déplaçant aléatoirement avec des vitesses relativistes, il se déplace également dans son ensemble avec des vitesses proches de celle de la lumière, et il peut se propager très loin du trou noir qui lui a donné naissance.

Or il existe un phénomène que l’on nomme l’aberration relativiste qui se traduit par le fait que la lumière provenant d’une source lumineuse se déplaçant très rapidement est concentrée dans la direction du déplacement. Cet effet est comparable (mais plus accentué) à ce que nous ressentons lorsque nous nous déplaçons en vélo ou en voiture dans une pluie verticale qui nous paraît venir de l’avant. La conséquence est que la lumière est amplifiée pour un observateur regardant la source dans une direction proche du jet (tout comme à vélo sous la pluie, nous sommes plus mouillés devant que dans le dos). C’est ce qui explique que dans certains AGN radio, le rayonnement du jet domine totalement le spectre de l’ensemble de la galaxie. Ce sont les blazars et les Blac, qui sont supposés être vus dans une direction proche du jet (voir le schéma unifié, Fig. 9). L’effet est parfois tellement important qu’on ne voit le jet que dans une seule direction, comme c’est le cas pour M87 et pour Cygnus A montrés sur les figures 3 et 4).

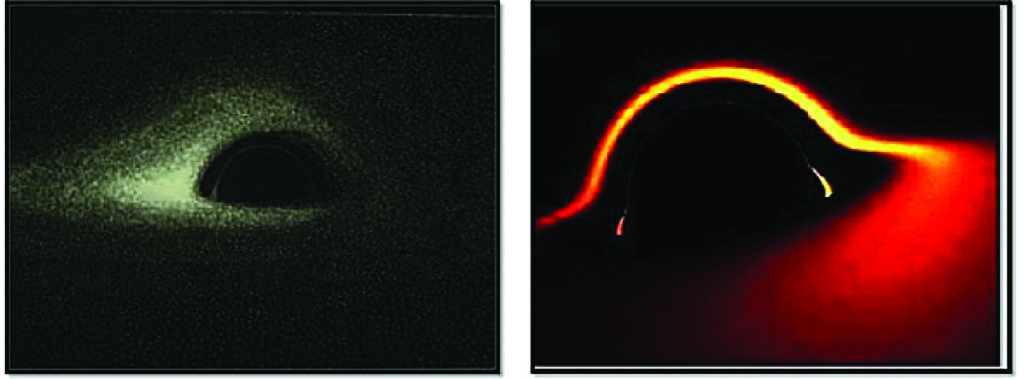

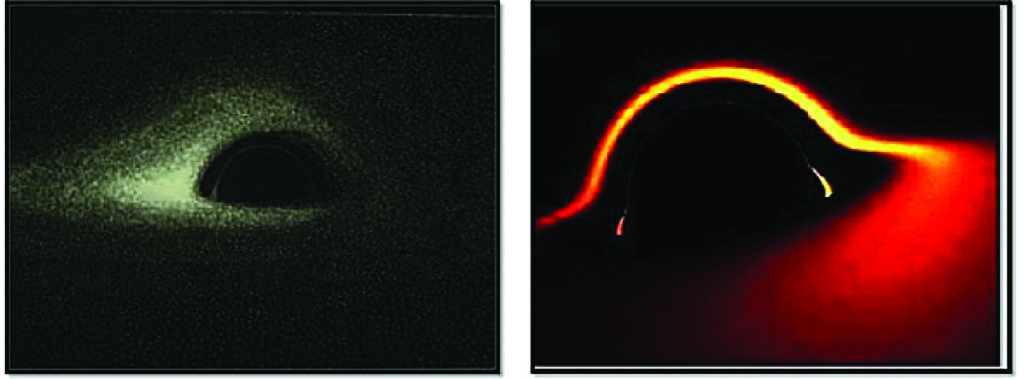

Une conséquence extrême de cet effet est que la lumière produite par le disque d’accrétion est tellement déviée qu’elle finit par parvenir depuis l’arrière du trou noir. Cet effet a été mis en évidence pour la première fois par deux Français travaillant à l’observatoire de Paris-Meudon, Jean-Pierre Luminet en 1983 pour un trou noir sans rotation, et Jean-Alain Marck en 1991 pour un trou noir en rotation (voir Fig. 12). On constate la similitude avec l’image du trou noir de M87 (Fig. 1).

Figure 12 – Simulation de disques d’accrétion : à gauche, pour un trou noir sans rotation, par Jean-Pierre Luminet, en 1983 ; à droite, pour un trou noir en rotation maximum, Jean-Alain Marck, 1991. (Observatoire de Paris-PSL)

Bien qu’ils fascinent depuis qu’on les observe en détail, les jets posent encore aux astrophysiciens bien des questions non résolues : comment expliquer qu’ils restent « collimatés » (c’est à dire très fins) en se propageant jusqu’à des millions d’années-lumière de leur galaxie ? Comment expliquer qu’ils émettent des photons dépassant les mille Giga électrons-volt ? Et surtout, dernière énigme, comment expliquer que les radiogalaxies qui émettent ces jets soient systématiquement des galaxies elliptiques ? La réponse à cette question pourrait bien venir d’un autre paramètre que nous avons négligé, la rotation du trou noir, ou son « spin ».

Le spin

Jusqu’à maintenant, parmi les deux paramètres intrinsèques des trous noirs, nous n’avons mentionné que l’influence de la masse. Nous avons vu qu’elle n’est pas fondamentale : des petits trous noirs (stellaires, même) peuvent avoir presque les mêmes propriétés que les trous noirs les plus massifs. Le deuxième paramètre intrinsèque est la rotation, ou « spin ». Il joue un rôle important à plusieurs titres.

Un trou noir est caractérisé par ce que l’on nomme la dernière orbite circulaire stable, (ISCO en anglais pour « Innermost stable circular orbit ») : c’est l’orbite en deçà de laquelle la matière finit inéluctablement par tomber radialement sur le trou noir sans avoir le temps de perdre de l’énergie. Le rayon de l’ISCO est plus petit pour un trou noir avec rotation (jusqu’à 1,2 rayon gravitationnel [10] pour une rotation maximale) que pour un trou noir sans rotation (6 rayons gravitationnels). Pour en donner une explication simpliste, disons que la matière autour d’un trou noir avec rotation est entrainée dans sa rotation, et peut ainsi se rapprocher du trou noir en continuant à tourner. Ce qui explique que jusqu’à 40% de l’énergie de masse peut être rayonnée pour un trou noir en rotation, contre seulement 6% pour un trou noir sans rotation. C’est une première conséquence du spin.

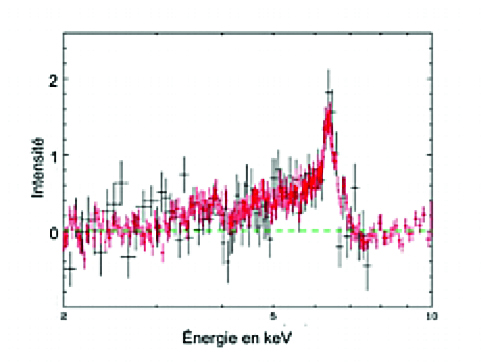

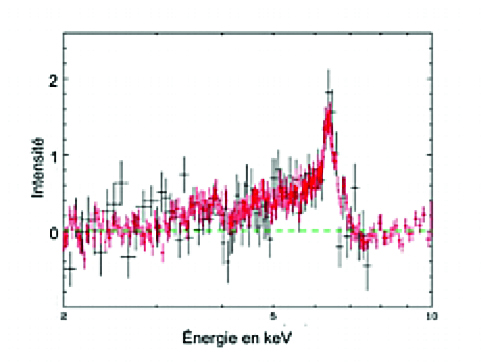

Par ailleurs, le gaz pouvant se rapprocher au plus près du trou noir s’il est en rotation va émettre des raies spectrales qui subissent le rougissement gravitationnel. Ainsi dans certains AGN, les raies du Fer dans le domaine des rayons X qui sont émises tout près du trou noir sont fortement déformées : elles présentent une aile rouge très étendue (Fig. 13). Cet effet permet d’affirmer que certains trous noirs sont en forte rotation.

Figure 13 – enregistrement d’une raie du fer dans le domaine X. L’extension de l’aile rouge montre que le gaz émissif est très proche du trou noir et signifie que celui-ci est en rotation rapide. (SMM-Newton, ESA)

La question qu’on se pose alors est : pourquoi certains trous noirs ont-ils un spin, et d’autres n’en ont-ils pas ?

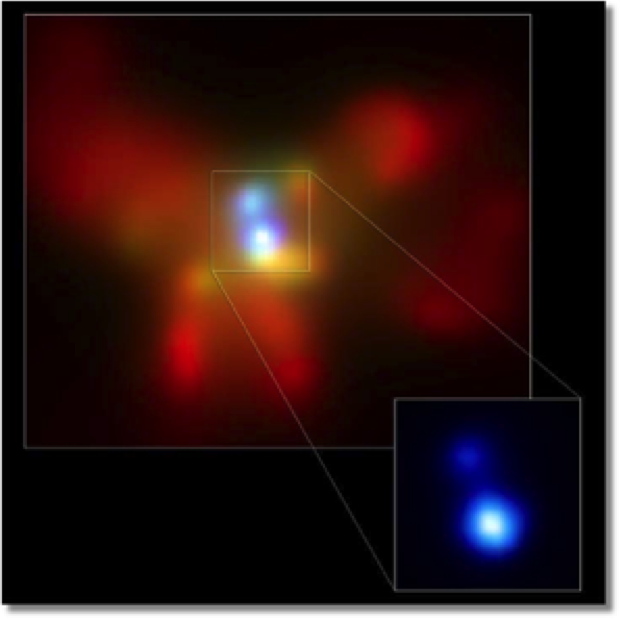

Il existe un processus, appelé Blandford–Znajek du nom de ses deux inventeurs en 1977, disant qu’il est possible d’extraire l’énergie d’un trou noir en rotation par l’intermédiaire du champ magnétique du disque. Des jets puissants pourraient être générés par ce mécanisme près de l’axe du disque d’accrétion. Or cette question rejoint celle de la prédominance de galaxies elliptiques parmi les radiogalaxies. Nous avons mentionné en effet que lorsque deux galaxies spirales se rencontrent et fusionnent, le produit est une galaxie elliptique. Les trous noirs des galaxies se rapprochent alors l’un de l’autre, et forment des trous noirs binaires (Fig. 14). Il est fort probable qu’après avoir tourné pendant quelque temps (disons dix millions d’années) l’un autour de l’autre, ils finissent par fusionner à leur tour, en donnant un trou noir supermassif ayant une forte rotation, comme c’est le cas pour les fusions de trous binaires de masses stellaires observées grâce à leurs ondes gravitationnelles [11]. Au cours du temps, la rotation se ralentira, et le jet disparaitra. Nous retrouvons ici la radiogalaxie Cygnus A mentionnée au début de cet article, dont nous avons vu qu’elle est constituée de deux galaxies en train de fusionner. De même la radiogalaxie M87 au centre de l’amas Virgo, a certainement « cannibalisé » plusieurs autres galaxies de l’amas, devenant elle aussi une galaxie elliptique possédant un jet très énergétique.

FIgure 14 – nGC 6240, deux galaxies en train de fusionner, observées en rayons X par le télescope Chandra. on distingue les deux noyaux actifs, distants de 800 parsecs. (Nasa)

L’environnement

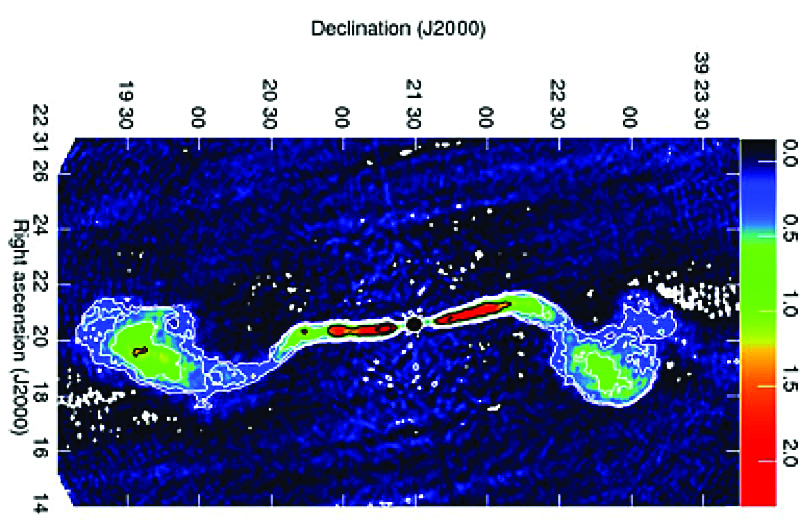

On a vu l’influence de la direction d’observation par rapport à l’axe du disque d’accrétion. Celui-ci peut changer fréquemment de direction en fonction de la matière qui parvient au centre d’une galaxie. C’est donc bien un effet environnemental. Un autre se manifeste dans la forme des sources dans les AGN radio. Elles sont constitués de deux jets symétriques naissant dans le noyau (on ne voit parfois que l’un d’entre eux à cause de l’aberration relativiste), qui s’étendent loin dans l’espace intergalactique. En 1974, Fanaroff et Riley les avaient séparés en deux catégories : les radiogalaxies FRII et les radiogalaxies FRI (voir la figure 3 montrant Cygnus A comme exemple de FRII, et la figure 15 comme exemple de FRI). Les FRII se terminent par des bords brillants – appelés « taches chaudes » ou « hot spots » – tandis que dans les FRI, la luminosité diminue lorsque la distance au centre augmente. La différence entre les deux types est probablement due à la quantité de gaz interstellaire présent dans la galaxie et dans le milieu intergalactique entourant la galaxie.

Figure 15 – Carte radio de la radiogalaxie 3C 449 de type Fr i.

Perspective

Il y aurait évidemment encore beaucoup à dire sur les trous noirs supermassifs. Un paradoxe sur lequel il a été peu insisté doit cependant être souligné : les trous noirs jouent le rôle d’absorbeurs de matière autant que d’éjecteurs par leurs jets ou par leurs vents. De ces derniers il a été peu question, car ils se produisent relativement loin du trou noir. Ils ont diverses causes, comme la pression du rayonnement ou l’évaporation due à la température élevée qu’atteint le gaz en se rapprochant du trou noir. Ils empêchent une partie importante de la matière de parvenir jusqu’au trou noir. Ils peuvent être dévastateurs pour l’environnement galactique et jouer un rôle important dans la relation entre les trous noirs et les galaxies. L’avenir nous en dira certainement beaucoup sur ce sujet encore assez nouveau.

Suzy COLLIN-ZAHN | Observatoire de Paris

Notes

[1] Une autre de ces radiosources, 3C48, avait été identifiée dès 1960 à une faible étoile bleue, mais on n’avait pas réussi à interpréter les raies de son spectre, et pour cause : elles étaient décalées de 37% par rapport à leurs longueurs d’onde habituelles.

[2] Je passe sous silence une discussion qu’on a appelée « la controverse du redshift » avec les partisans d’un redshift dû à une loi physique inconnue. Elle a débuté en 1965 et ne s’est apaisée – pas complètement – qu’en 1978 après une confrontation violente dans un congrès – à laquelle j’ai assisté.

[3] En fait , il dépend également d’un troisième paramètre, la charge, mais on il est admis que celle-ci est nulle, car la matière qui pénètre dans un trou noir n’est pas chargée.

[4] J’ai contribué moi-même dans ma thèse en 1968 à établir ce modèle.

[5] Cette relation suppose que l’ensemble des étoiles a atteint un état d’équilibre.

[6] J’ai annoncé la première en 1968 que les raies spectrales larges devaient varier en quelques années. Mais c’est en 1982 seulement que la méthode de détermination des masses a été formalisée et que des observations intensives ont commencé.

[7] Le bulbe est cette région brillante centrale sphéroïdale, importante dans les galaxies spirales des premiers types, et à laquelle se réduisent complètement les galaxies elliptiques

[8] Notons que des chercheurs français ont participé activement à la mise au point de l’optique adaptative nécessaire aux observations.

[9] Cette limite, découverte par le célèbre astronome britannique Arthur Eddington, correspond à l’égalité entre la force du rayonnement qui repousse la matière et la force gravitationnelle du trou noir qui l’attire.

[10] Le rayon gravitationnel est égal à GM/c2, où G est la constante de la gravitation et c la vitesse de la lumière. Il est de 1,5 km pour un astre ayant la masse du Soleil. On voit qu’il est proportionnel à la masse, ce qui explique que la densité moyenne des trous noirs supermassifs soit relativement faible, contrairement à ce que l’on pense souvent.

[11] Ces fusions pourront être observées par l’instrument spatial LISA lorsqu’il sera mis en service… dans une vingtaine d’années!

Glossaire

Quasar : galaxie rendue extrêmement lumineuse à cause de la présence en son centre d’un trou noir supermassif très actif, car disposant de beaucoup de gaz à avaler.

Seyfert (galaxies de) : Galaxies découvertes par Carl Seyfert, ayant un noyau bleu très brillant d’aspect stellaire dont le spectre présente des raies en émission intenses et larges.

AGN : « Active Galactic Nuclei » en anglais, expression utilisée pour désigner les galaxies dont le trou noir central est alimenté par de la matière y tombant en quantités importantes. Les quasars, les galaxies de Seyfert et les radio galaxies sont des AGN.

BLac (ou lacertides) : radiogalaxies dont la direction d’observation est proche du jet, ce qui a pour effet d’amplifier le rayonnement qu’il émet.

Blazar : quasars radio (plus lumineux que les radiogalaxies) dont la direction d’observation est proche du jet, ce qui a pour effet d’amplifier le rayonnement qu’il émet.

radiogalaxies : galaxies dont le rayonnement radio est beaucoup plus intense que le rayonnement visible.

OVV : objets présentant des variations optiques violents et rapides.

par Sylvain Bouley | Avr 10, 2021 | Zoom Sur

L’équipe internationale en charge de l’instrument GRAVITY a annoncé récemment la détection de la précession de Schwarzschild sur l’orbite de l’étoile S2, la plus proche du trou noir supermassif au centre de la Voie Lactée.

Pour comprendre ce que cette détection signifie, il est utile de faire un pas en arrière et de considérer l’évolution des idées sur la notion d’orbite des corps célestes, avant de se lancer dans le cœur du sujet des détails de cette détection. Nous allons voir que la mesure de GRAVITY constitue une dernière étape sur une route jalonnée depuis deux millénaires et demi par Eudoxe de Cnide, Kepler et Einstein.

Orbites des corps célestes pour les anciens Grecs : Eudoxe de Cnide

Tout commence par Pythagore (autour de 550 avant notre ère). Son école fort ésotérique apporte deux avancées considérables. Tout d’abord, les Pythagoriciens tiennent pour principe premier des choses le nombre. Ce début de mathématisation du monde est promis à un brillant et long avenir. Ensuite, les Pythagoriciens proposent une vision toute nouvelle sur la géométrie. Le fameux théorème de Pythagore (le carré de l’hypoténuse de tout triangle rectangle …) était déjà connu en pratique des Égyptiens, qui avaient noté cette particularité dans tel ou tel triangle particulier. L’apport crucial de Pythagore, c’est de poser que ceci est valable pour tout triangle rectangle, début de systématisation de la géométrie, début d’une vision scientifique moderne, se dégageant d’un savoir purement pratique (tel que l’était, par exemple, celui des Égyptiens antiques).

Platon (autour de 400 avant notre ère) propose un modèle du cosmos basé sur des sphères imbriquées (on reconnaît là l’influence de la mathématisation du monde proposée par les Pythagoriciens). La Terre est au centre, entourée des sphères de l’eau, de l’air et du feu. Les astres se meuvent au-delà, à des distances croissantes (vient d’abord la Lune, puis les autres planètes connues et le Soleil, et enfin la sphère des étoiles lointaines fixes). Ce modèle est développé par Eudoxe de Cnide (contemporain de Platon) qui postule que les astres se déplacent le long des sphères imbriquées de Platon en suivant des orbites circulaires et uniformes. Nous voici devant le premier modèle explicite d’orbite d’un corps céleste : Eudoxe peut être ainsi considéré comme le premier astronome au sens moderne du terme. Nous allons voir que l’observation récente de GRAVITY est une héritière très lointaine de ce pionnier.

Figure 1 – Les systèmes du monde Copernic (gauche) et d’Eudoxe (à droite) et de. source : Histoire générale des sciences, dir. r. taton, tome ii.

Orbites des corps célestes de la renaissance à l’époque classique : Kepler

Malgré les développements considérables apportés par Ptolémée (au Ier siècle de notre ère) au modèle d’Eudoxe, on peut considérer que les éléments de base de la compréhension du cosmos n’ont pas évolué de façon radicale avant le XVIe siècle. Cette gigantesque plage de temps illustre bien le caractère véritablement stupéfiant des avancées des VIe et Ve siècles de la Grèce antique. Il revient à trois scientifiques des XVIe et XVIIe siècles de proposer le cadre conceptuel suivant : Nicolas Copernic (~1530), Tycho Brahé (~1580) et Johannes Kepler (~1610). La révolution copernicienne consiste à placer non plus la Terre, mais le Soleil au centre du cosmos. Les astres sont toujours considérés en orbite circulaire et uniforme autour du Soleil (voir la Figure 1 qui compare le système du monde hérité d’Eudoxe à celui de Copernic). Tycho Brahé réalise des observations d’une superbe précision, et sur une très grande quantité de sources, qui seront la base de la systématisation suivante, entreprise par Kepler au tournant du XVIIe siècle.

Kepler est le véritable point de référence auquel doit se comparer le résultat de l’équipe GRAVITY. Faisant la synthèse des apports de Copernic et de Tycho, il aboutit aux fameuses lois de Kepler, qui apportent deux éléments nouveaux fondamentaux. Tout d’abord, il a la première intuition du rôle de moteur joué par le Soleil dans le mouvement des astres, alors que les descriptions précédentes se contentaient d’entériner le fait que les astres tournent, soit autour de la Terre, soit autour du Soleil, sans voir de lien de cause à effet entre la présence du corps central et le mouvement des astres autour de celui-ci. Ensuite, Kepler est amené, grâce aux superbes observations de Tycho, à battre en brèche la théorie du mouvement circulaire et uniforme des astres (datant d’Eudoxe, donc de 2000 ans en arrière) et à le remplacer par un mouvement elliptique. Avec Newton (~1680), sa loi du mouvement et sa loi de gravitation universelle, les avancées de Kepler sont confirmées et incluses dans un système d’explication beaucoup plus vaste, qui forme l’une des pierres angulaires de l’astronomie jusqu’à Einstein.

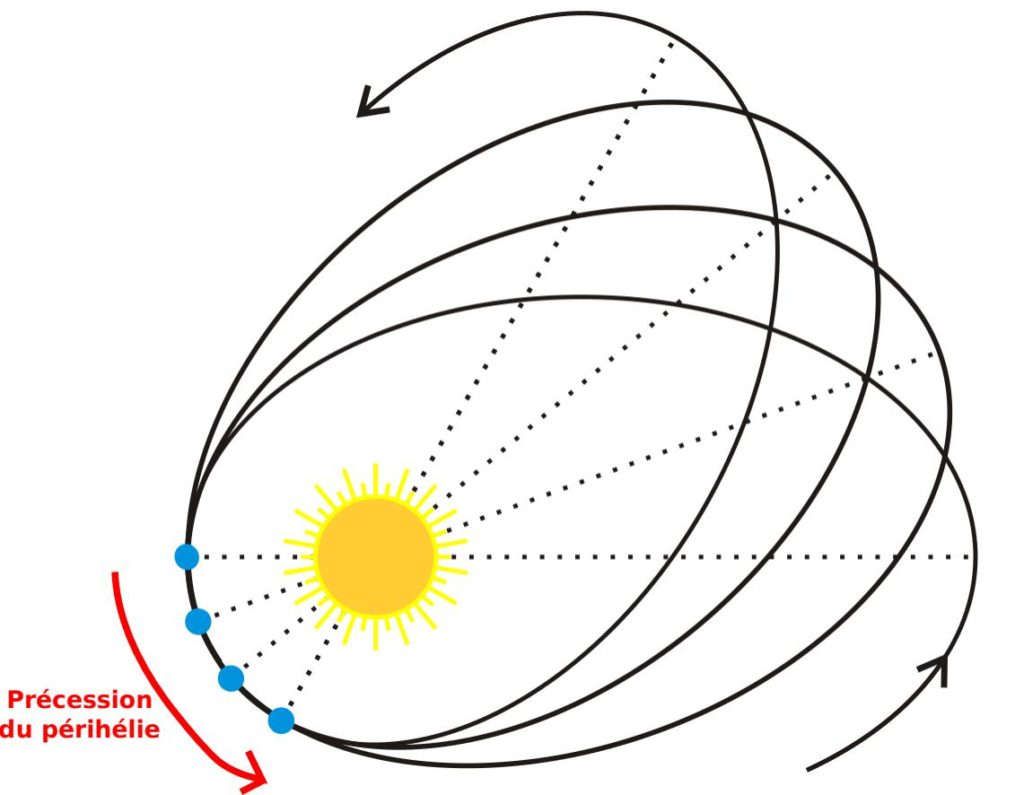

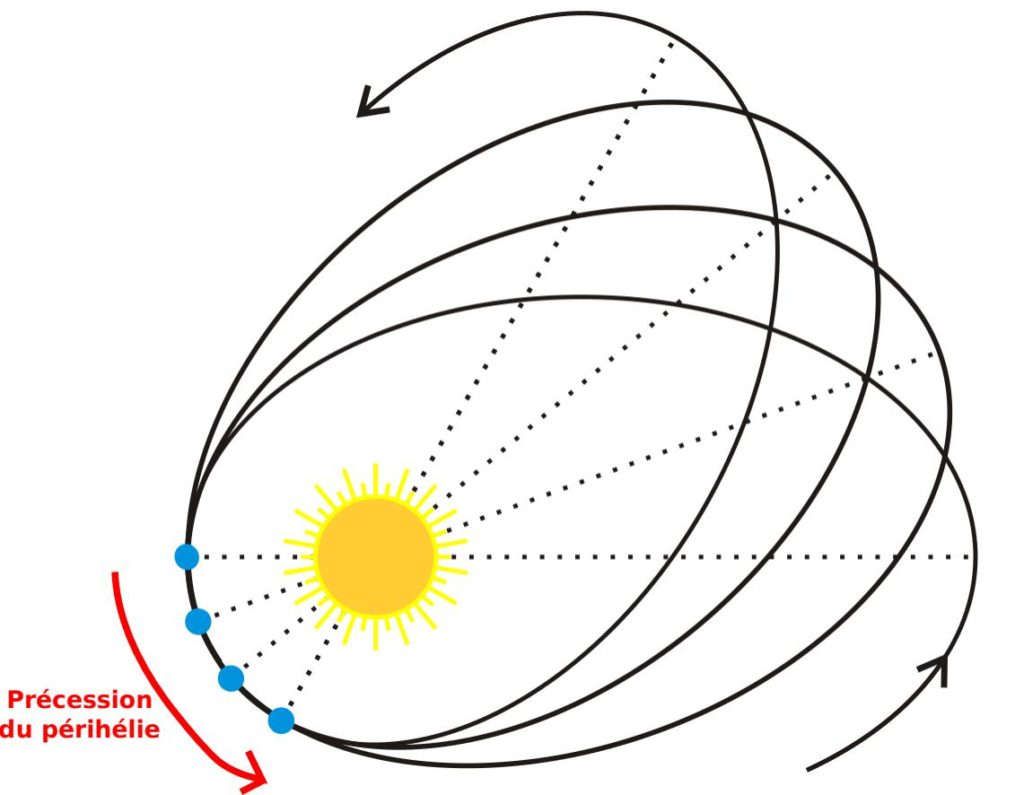

Orbites des corps célestes de la relativité générale : Einstein

Einstein est l’héritier direct de Newton. C’est lui qui reformule les lois de la gravitation en 1915, aboutissant aux lois de la relativité générale, qui englobent et dépassent considérablement la théorie newtonienne. Ce n’est pas le lieu ici d’expliquer son cheminement. Il convient par contre de discuter l’une des conséquences de la relativité générale sur les orbites des corps célestes. Einstein aboutit à la prédiction que les orbites des planètes autour du Soleil ne doivent pas suivre des ellipses kepleriennes. Elles vont peu à peu se décaler pour former une rosace, dans un mouvement de précession du périhélie, le point de l’orbite le plus rapproché du Soleil (Figure 2). Einstein se souvient alors que l’astronome français Le Verrier avait mis en évidence en 1859 à l’Observatoire de Paris le fait que la planète Mercure (la plus proche du Soleil, et donc la plus fortement soumise à sa gravitation) exhibait un mouvement inexpliqué, en désaccord avec les lois de Kepler et de Newton. Einstein se jette sur ce problème et détermine ce que prédit sa propre théorie. Celle-ci explique exactement l’incohérence rapportée par Le Verrier. Einstein, d’après ce qu’il a lui-même rapporté, « est resté sans voix pendant plusieurs jours à cause de [s]on excitation » suite à cette toute première vérification expérimentale de sa nouvelle théorie, qui valide son travail acharné réalisé pendant la décennie qui précède. La mesure récente de l’équipe GRAVITY est la dernière vérification expérimentale de ce même effet, dans un contexte très différent.

Figure 2 – orbite d’une planète autour du soleil d’après la relativité générale. L’ellipse suivie par la planète se décale peu à peu, entraînant le périhélie dans un lent mouvement de précession indiqué par la succession des cercles bleus (très exagéré bien entendu sur ce schéma). (source : modifié à partir de Wikipedia – article apsidal precession).

Détecter la précession de Schwarzschild sur l’orbite de l’étoile S2 : GRAVITY

L’instrument GRAVITY du Very Large Telescope (VLT) de l’ESO a déjà été présenté dans l’Astronomie Magazine par deux articles de Guy Perrin (avril 2011, octobre 2016). Rappelons seulement ici qu’il s’agit de recombiner la lumière issue des quatre télescopes géants de 8 mètres de diamètre du VLT, afin de réaliser un interféromètre en longueur d’onde infrarouge. Cet instrument, qui a vu sa première lumière en 2016, permet ainsi d’atteindre une précision de 30 microsecondes d’angle dans la mesure du déplacement d’un objet sur le ciel. Il faut s’attarder un instant sur ce chiffre. Il s’agit de la taille angulaire d’un cheveu situé à Barcelone et vu depuis Paris… Cette stupéfiante précision a été cruciale dans la détection dont nous allons parler maintenant.

GRAVITY observe en particulier les abords du trou noir de 4 millions de fois la masse du Soleil qui se trouve au centre de notre Galaxie, Sagittarius A* (Sgr A* dans la suite). Cet objet compact est entouré d’un amas d’étoiles dont la plus proche, appelée S2, parvient à son péricentre à 120 unités astronomiques seulement du trou noir (la taille du système solaire environ, voir la Figure 3). A cette distance, des effets de relativité générale sur l’orbite sont attendus, et en particulier l’effet de précession du péricentre, le même que celui qui affecte Mercure autour du Soleil.

L’objectif de la collaboration GRAVITY était de mettre en évidence la précession du péricentre de l’étoile S2 autour de Sgr A*. On parle de précession de Schwarzschild pour préciser qu’on s’intéresse à l’effet obtenu près d’un trou noir considéré comme sans rotation, appelé trou noir de Schwarzschild. Cette dénomination fait référence au découvreur de cet objet, Karl Schwarzschild, qui publia la première solution de trou noir (sans savoir alors qu’il s’agissait de ce type d’objet exotique) en janvier 1916 (soit 2 mois seulement après qu’Einstein ait publié son propre article sur les équations de la relativité générale en novembre 1915).

Il convient d’insister sur le fait que, si l’effet observé par GRAVITY est le même que celui étudié par Einstein dès 1915, le contexte est entièrement différent. La détection de l’effet de précession du péricentre dans l’environnement proche d’un trou noir supermassif est une validation beaucoup plus puissante de la théorie que cette même validation dans l’environnement solaire.

Figure 3 – L’amas d’étoiles situé autour du trou noir supermassif sgr A* au centre de la Galaxie. L’étoile s2 observée par Gravity, la plus proche du trou noir, est entourée en rouge. (Gillessen et al. ,2009)

En quoi consiste la détection par GRAVITY

La détection d’un mouvement de précession du péricentre nécessite à la fois un suivi sur le très long terme de l’étoile S2 (qui a une période orbitale de 15 ans), et une précision de mesure extrême au moment du passage au péricentre. La très longue base temporelle a été rendue possible par les observations continues de S2 effectuées depuis 2002 par la caméra infrarouge NACO du VLT. Les données GRAVITY ont quant à elles permis de suivre avec une précision fantastique le passage de S2 à son péricentre en mai 2018. C’est vraiment la combinaison de ces deux jeux de données (avec l’ajout des données spectroscopiques obtenues par l’instrument SINFONI du VLT) qui a permis une détection claire cette année.

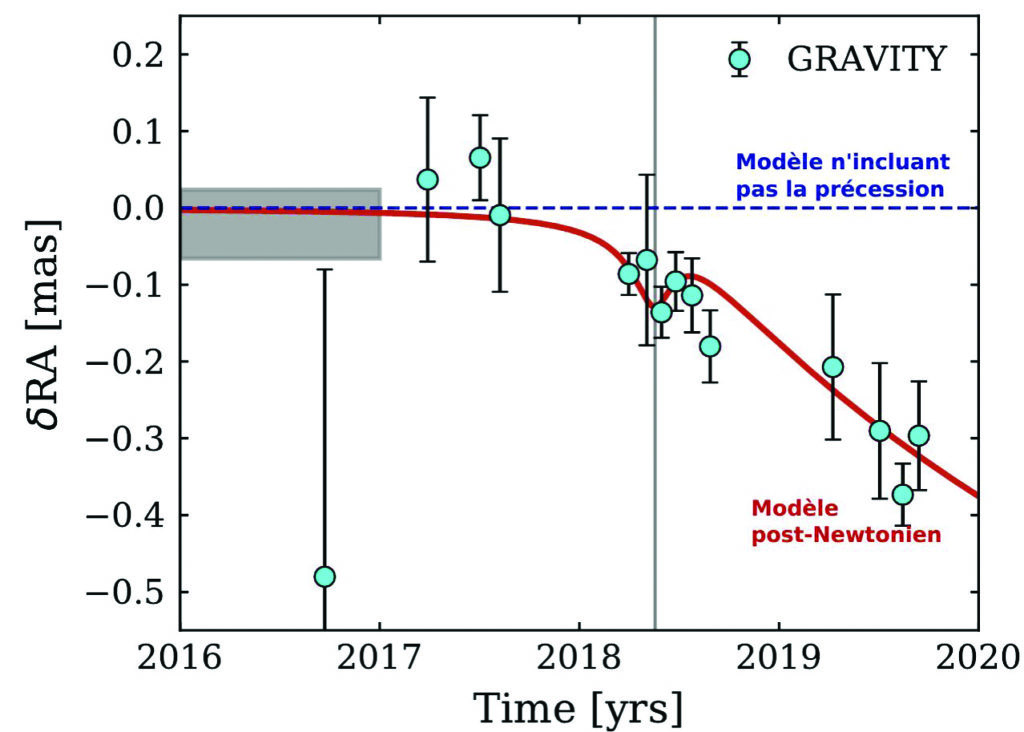

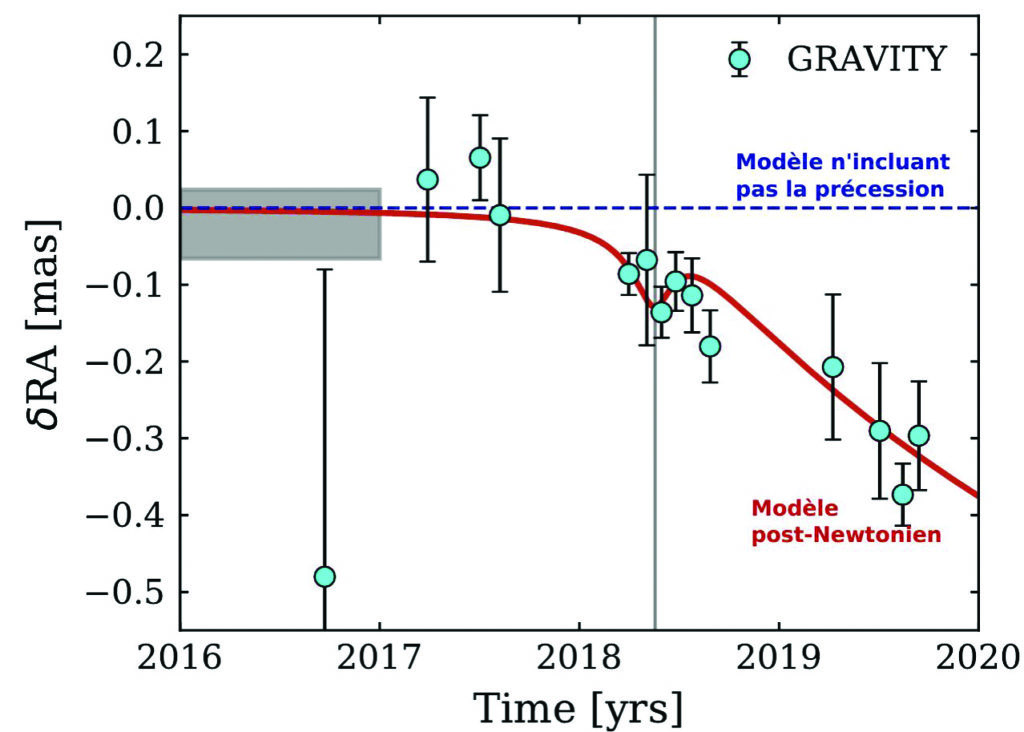

Une fois les données orbitales enregistrées par NACO et GRAVITY, il a fallu ajuster un modèle théorique d’orbite à la trajectoire de S2. L’équipe GRAVITY a utilisé une approximation de la relativité générale, le formalisme post-Newtonien, qui permet de simplifier le problème tout en conservant une précision suffisante pour le cas traité ici. La Figure 4 montre le résultat crucial de l’article récent de la collaboration GRAVITY. Le modèle post-Newtonien ajuste parfaitement les données, alors qu’un modèle n’incluant pas la précession de Schwarzschild est exclu. Une étude statistique précise a permis de démontrer que la détection de la précession de Schwarzschild peut être considérée comme décisive.

Figure 4 – Détection par Gravity de la précession de schwarzschild sur l’orbite de l’étoile s2. Les points de données en couleur cyan sont parfaitement ajustés par le modèle post- newtonien (approximation de la relativité générale complète, en rouge), alors qu’un modèle n’incluant pas la précession de schwarzschild (en bleu) est exclu. (Gravity collaboration, 2020)

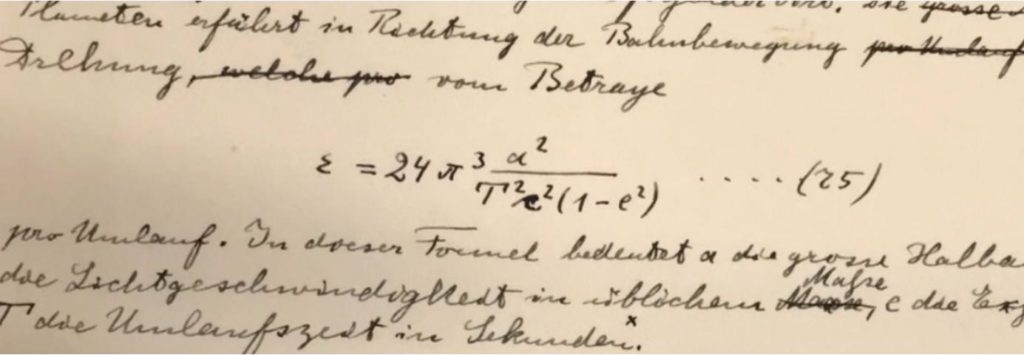

De 1915 à 2020

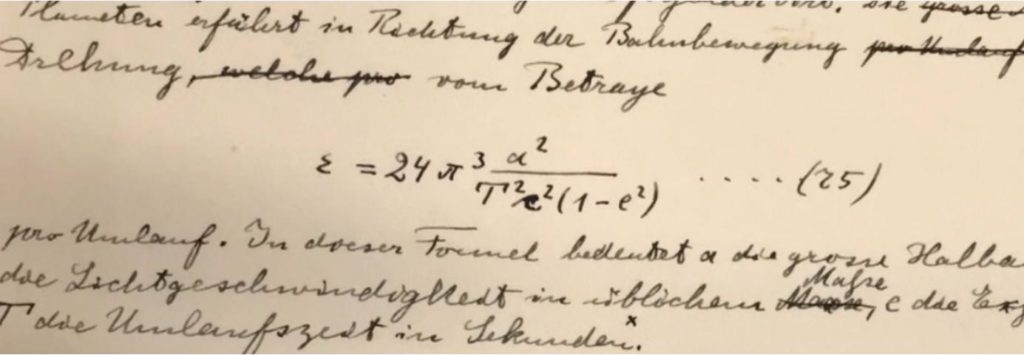

Comme l’avait fait Einstein en 1915 pour Mercure, l’équipe GRAVITY a pu monter le parfait accord entre la prédiction de la relativité générale et la mesure de la précession de Schwarzschild de l’orbite de l’étoile S2. La Figure 5 compare une lettre d’Einstein portant sur son test de 1915 sur Mercure avec la formule de la précession de Schwarzschild utilisée dans l’article récent de la collaboration GRAVITY. C’est bien le même phénomène qui est étudié !

FIgure 5 – Texte d’einstein de 1915 relatif à la détection du mouvement de précession relativiste de mercure autour du soleil validant sa théorie. (en Médaillon) extrait de l’article de la collaboration Gravity mettant en évidence le même effet sur l’étoile s2 autour du trou noir supermassif au centre de notre Galaxie. Nous laissons à nos lecteurs les plus assidus le soin de montrer l’équivalence des deux formules.

Frédéric VINCENT | CNRS – Observatoire de Paris