Les sursauts radio rapides, histoire d’une théorie sur un phénomène astronomique

Les sursauts radio rapides ont été découverts au début des années 2010. Ils ont des propriétés auxquelles personne ne s’attendait. Très vite, des explications ont été proposées. Fabrice Mottez est l’auteur de l’une de ces explications et nous raconte dans cet article l’origine de cette proposition.

Il y a quelques années, un train dans lequel je voyageais s’arrêta sur la voie. À l’époque, la SNCF n’informait pas ses voyageurs de la nature des incidents concernant leur voyage. Dans les haut-parleurs de la voiture, une voix nous demanda simplement de ne pas descendre sur les voies. Alors, tranquillement, des voyageurs firent part de leur interprétation du phénomène. Dehors, rien ne paraissait anormal ; nous n’avions aucune information et toutes les explications données étaient plausibles compte tenu du peu d’informations dont nous disposions. Avez-vous constaté ce phénomène : moins les gens en savent, plus ils ont d’explications à proposer ? Voici le récit d’une recherche de nature théorique, commencée vers 2012, à propos d’un phénomène observé pour la première fois en 2006 et qu’on appellerait bientôt « sursaut radio rapide » (FRB pour fast radio burst en anglais).

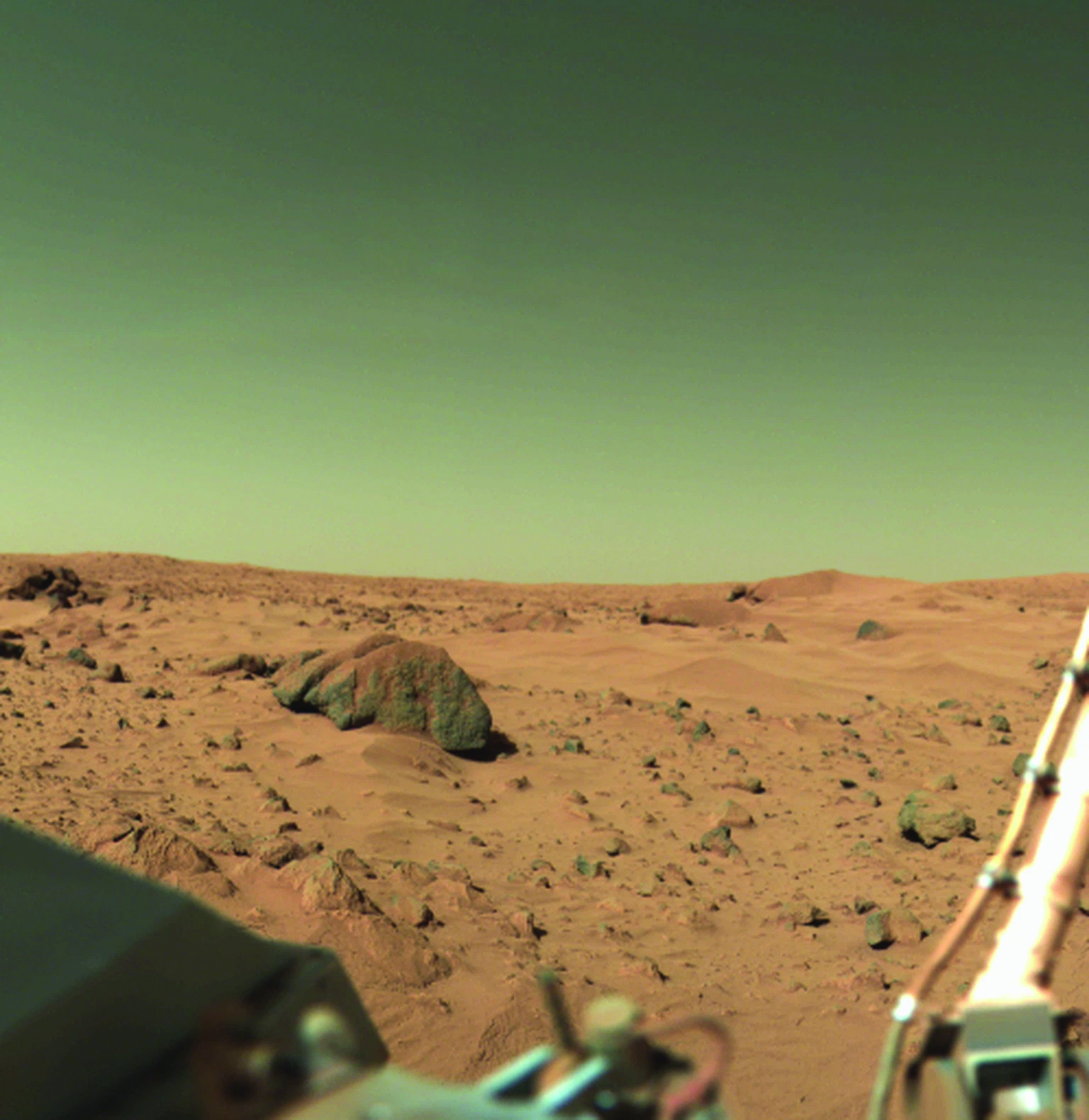

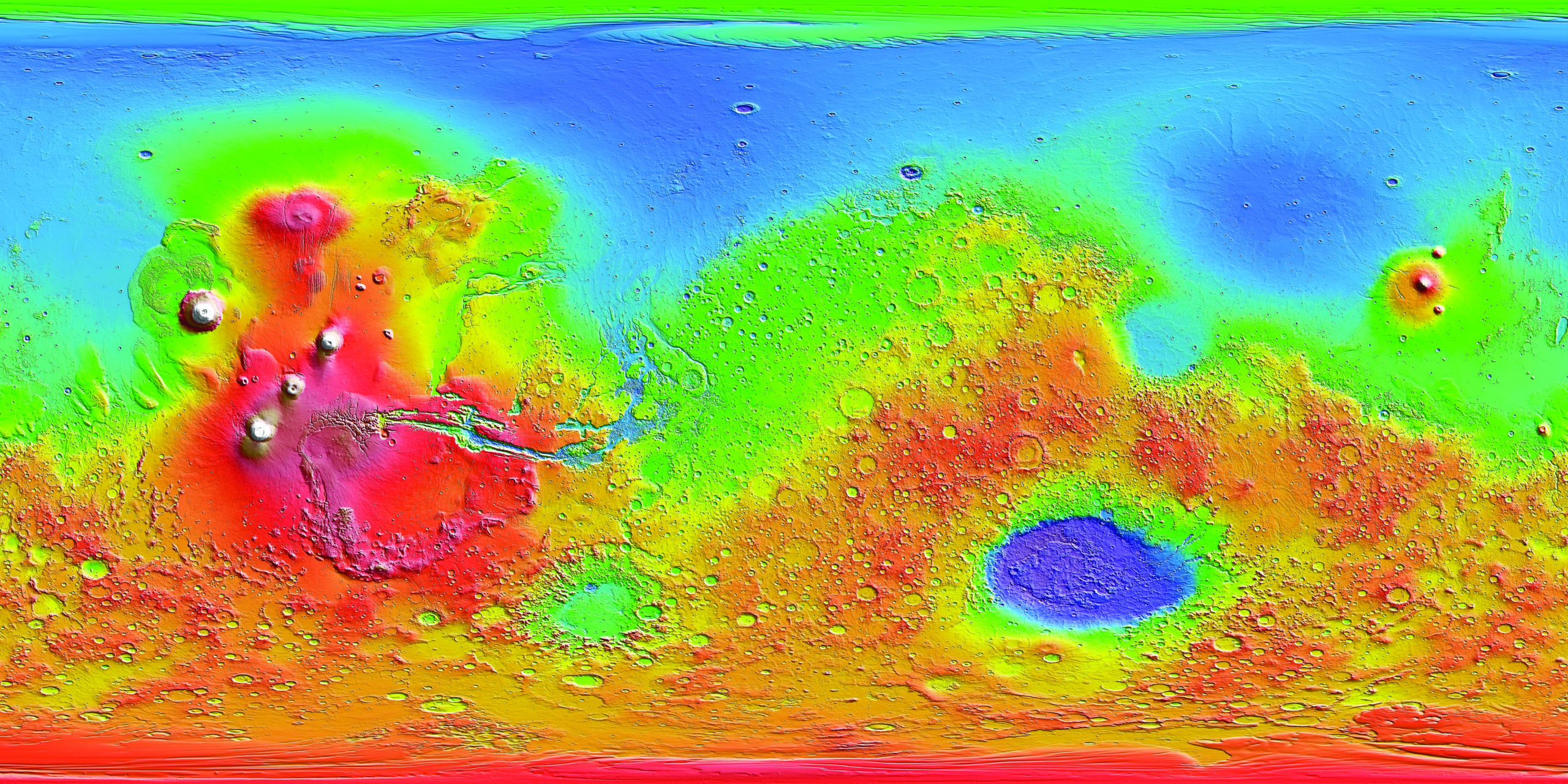

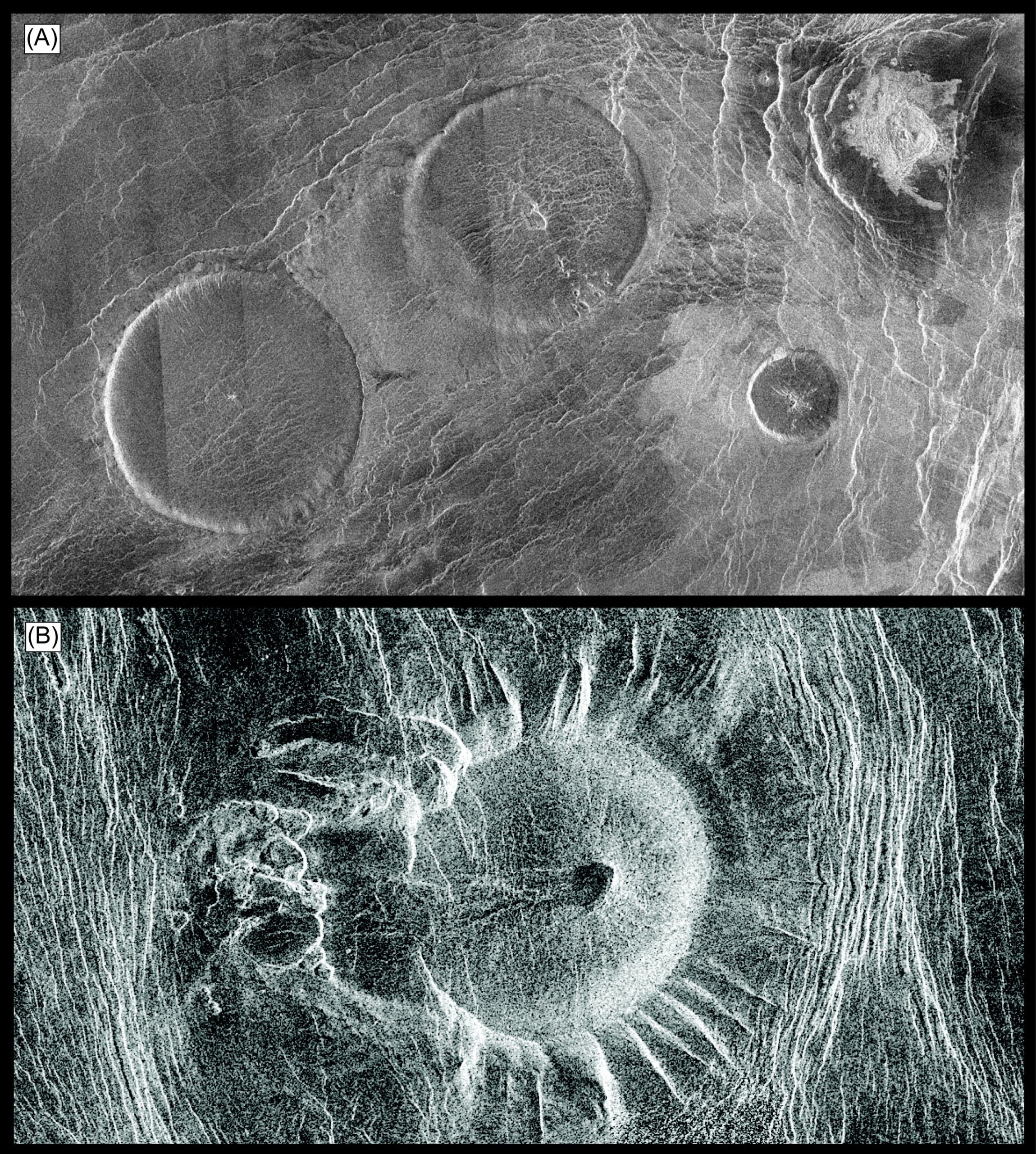

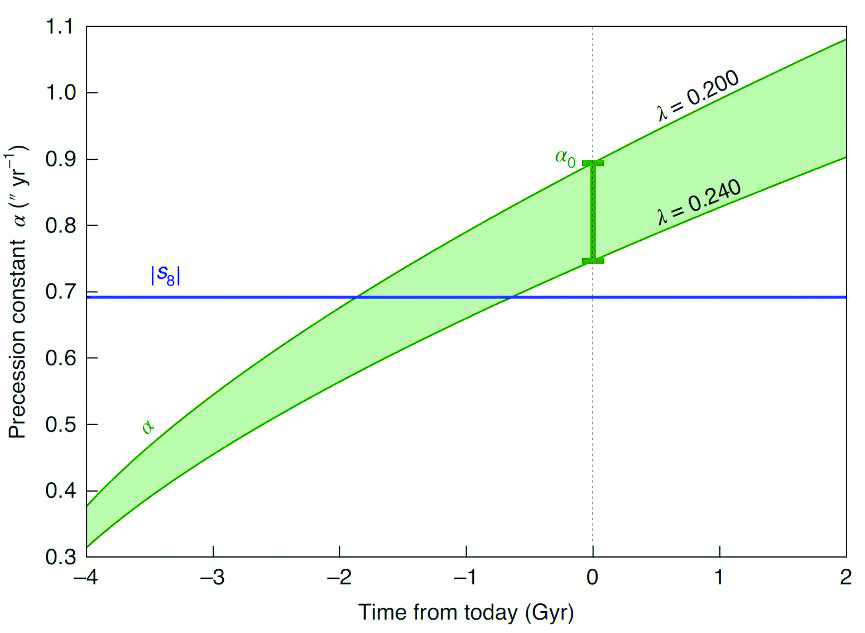

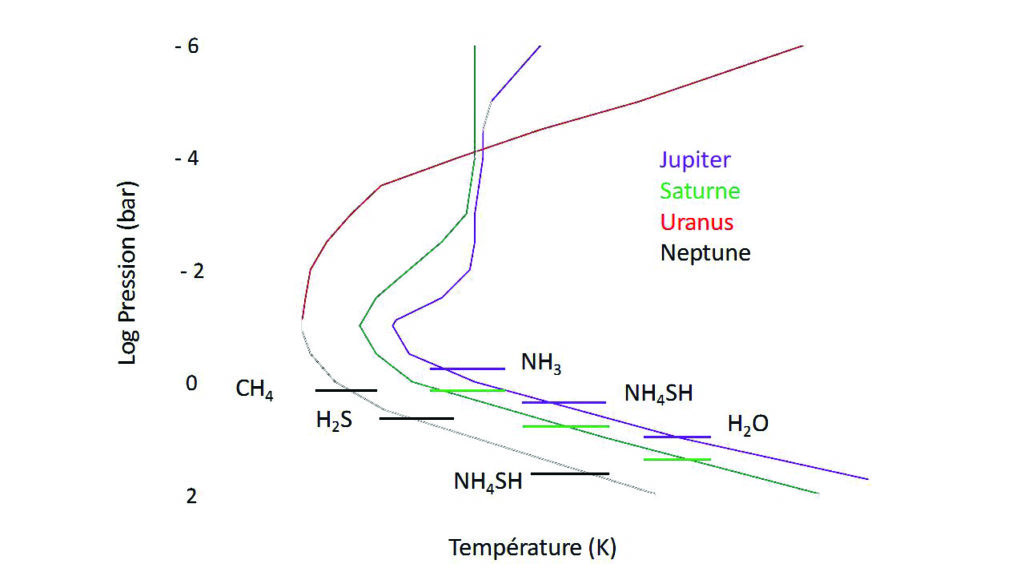

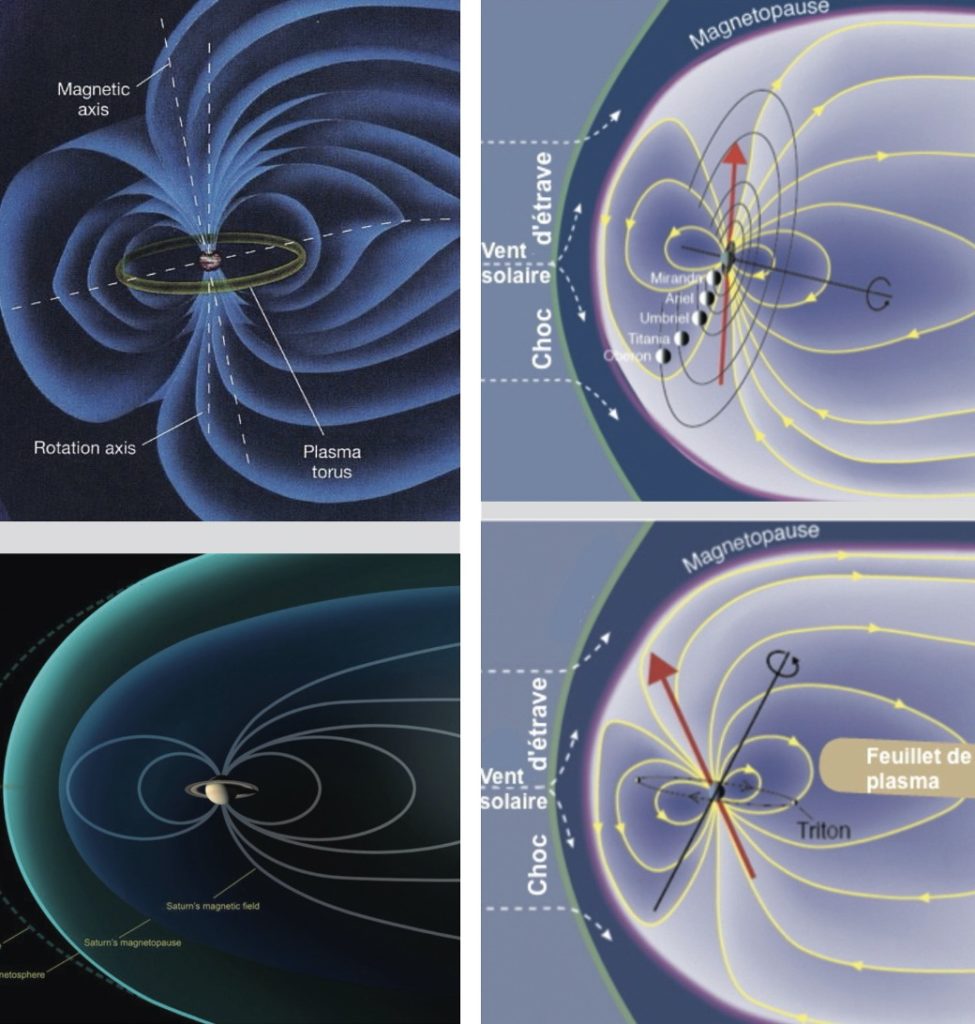

Fig 1. Spectre du FRB011025 (obtenu le 25 octobre 2010) avec le radiotélescope de Parkes, en Australie. L’axe horizontal représente le temps exprimé en millisecondes. L’axe vertical représente les fréquences exprimées en mégahertz. Le signal apparaît en noir, il se détache clairement du bruit de fond. Le fait que le signal aux basses fréquences arrive en retard par rapport aux hautes fréquences est un effet de propagation lié aux électrons rencontrés par l’onde entre la source et les observateurs. La durée du signal à une fréquence donnée est de l’ordre de 1 à 10 millisecondes. (Sarah Burke-Spolaor & Keith Bannister, The Astrophysical Journal 792 :19, 2014)

Les FRB sont des signaux radio qui durent quelques millisecondes seulement (leur brièveté explique leur découverte tardive), mais les études statistiques montrent qu’il y aurait plusieurs milliers d’événements de ce type chaque jour dans notre ciel. Le fait étonnant, qui a intéressé les théoriciens comme moi, est l’éloignement de ces émetteurs radio, à des milliards d’années-lumière de nous. De plus, pour expliquer la brièveté du phénomène, il faut que sa source soit petite, de l’ordre de la centaine de kilomètres, voire moins. Pour qu’on en capte le signal d’aussi loin, il faut a priori un événement extrêmement énergétique. Ces deux observations semblent relier le phénomène aux étoiles à neutrons, qui sont à la fois des astres très petits, très énergétiques et capables d’émettre des ondes radio, bien que l’intensité généralement observée de ces dernières soit plus faible de plusieurs ordres de grandeur que celle des FRB.

En 2012, une dizaine d’événements avaient été observés. À cette époque, les théoriciens dont j’étais disposaient d’assez peu d’informations. Cela nous permettait d’avancer une grande quantité d’explications possibles : une explosion d’étoile à neutrons, ou sa transformation en trou noir sous l’effet d’une étoile voisine lui fournissant un flux continu de matière, ou bien la fusion de deux étoiles à neutrons, ou encore la chute d’une étoile dans un trou noir ou autre chose de ce genre. Ces événements très violents émettent en principe beaucoup de rayons X et gamma, que nous aurions dû capter. Or, on ne capte ni de rayons X ni de gamma lors des FRB. En outre, on ne s’attend pas à ce que des événements par nature uniques dans l’existence d’une étoile soient fréquents au point d’être observables des milliers de fois par jour. Le phénomène sur lequel nous nous penchions était qualifié de mystérieux et personne ne l’avait envisagé. Pourtant, une fois observé, il y eut plus de théories proposées que d’événements répertoriés ! Ainsi, dire qu’un phénomène est mystérieux ne signifie pas forcément que l’on n’a pas d’explication à avancer.

Avec deux collègues émérites (c’est-à-dire à la retraite mais continuant à faire de la recherche), Jean Heyvaerts et Silvano Bonazzola, nous étudions dans les années 2010 un sujet totalement « hors mode », a priori sans lien avec les FRB : des astéroïdes autour d’une étoile à neutrons. Personne en dehors de nous ne s’intéressait à ce phénomène, car personne ne pensait qu’il serait observable.

Le contexte général de nos recherches était l’environnement des étoiles à neutrons. C’est seulement en 1968 que fut confirmée l’existence des étoiles à neutrons grâce aux observations des radioastronomes, bien que trois physiciens géniaux aient décrit leur structure dès 1939. De nos jours, nous n’avons plus aucun doute sur le fait que les étoiles à neutrons existent. Nous en observons environ deux mille, généralement sous la forme d’émissions radio ou de hautes énergies pulsées à la fréquence de rotation de l’étoile sur elle-même. Nous appelons ces phénomènes répétitifs des pulsars. Les pulsars sont donc les catégories d’étoiles à neutrons les plus faciles à observer, bien que les étoiles à neutrons ne soient pas toutes associées à un pulsar.

Une étoile à neutrons est un astre très compact (une boule de 25 km de diamètre), ayant une ou deux fois la masse du Soleil. Cela représente la masse d’un Soleil et demi contenue dans une boule un peu plus petite que l’agglomération parisienne. Les étoiles à neutrons (du moins celles observées en tant que pulsars) tournent très vite sur elles-mêmes (le pulsar le plus rapide a une période de 1,6 milliseconde, les plus lents, un peu plus d’une seconde, contre 27 jours pour le Soleil), avec des champs magnétiques ultra-intenses, de l’ordre de 108 teslas. Et les champs magnétiques sont de très bons « ingrédients » pour fabriquer des ondes radio, lesquelles sont observables depuis la Terre. Et les champs magnétiques sont aussi ma spécialité.

Il doit y avoir environ un milliard d’étoiles à neutrons dans notre Galaxie. Il faut qu’elles soient disposées par rapport à nous selon des angles particuliers pour que nous puissions observer leur rayonnement, c’est-à-dire pour qu’elles apparaissent comme des pulsars ; c’est pour cela que nous n’en voyons que deux mille, tandis que nous estimons leur nombre à un milliard.

Certaines étoiles à neutrons ont un champ magnétique mille fois plus intense que ceux des pulsars et tournent un peu moins vite sur elles-mêmes (une rotation en une à dix secondes). On les appelle des magnétars.

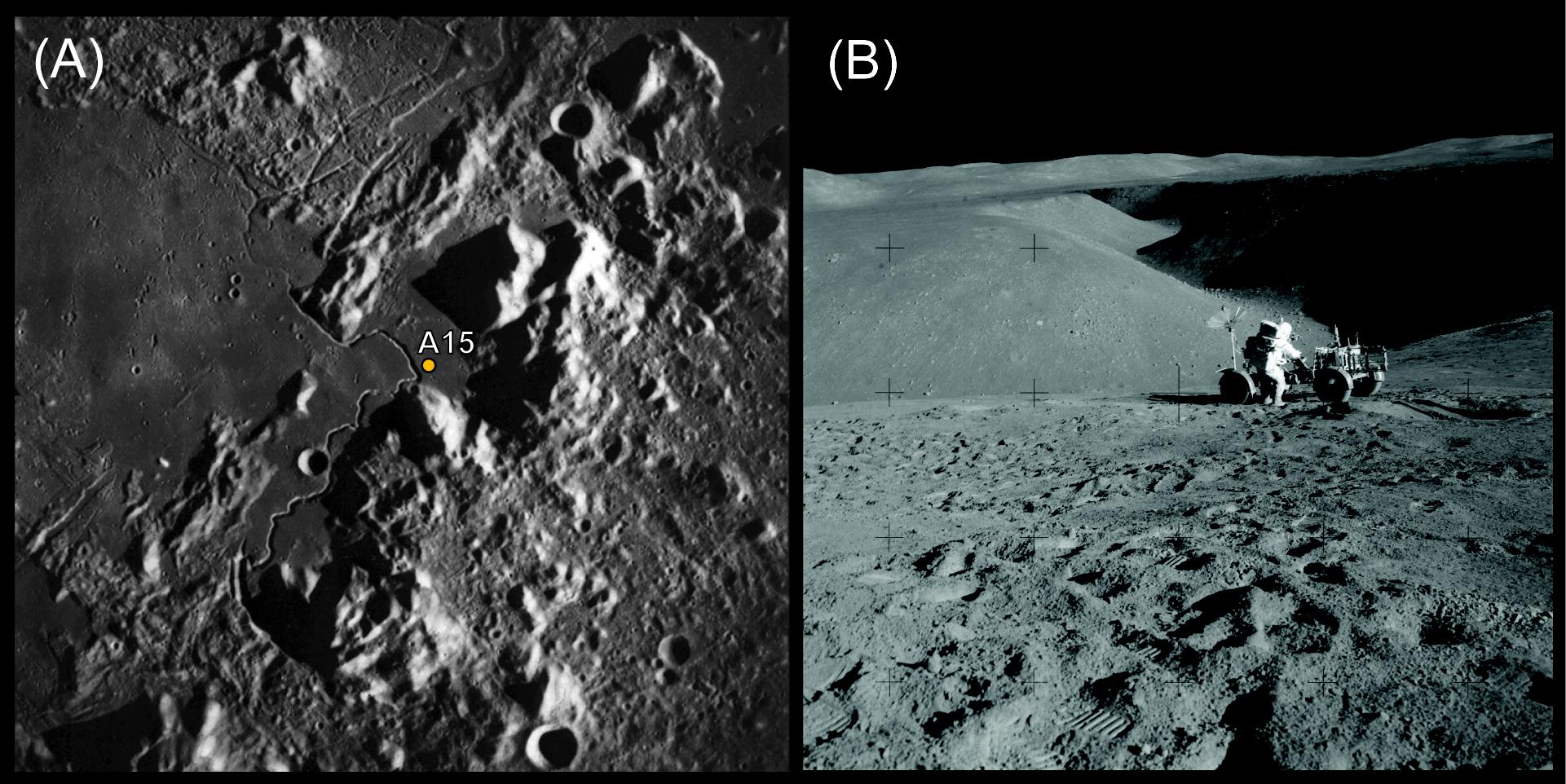

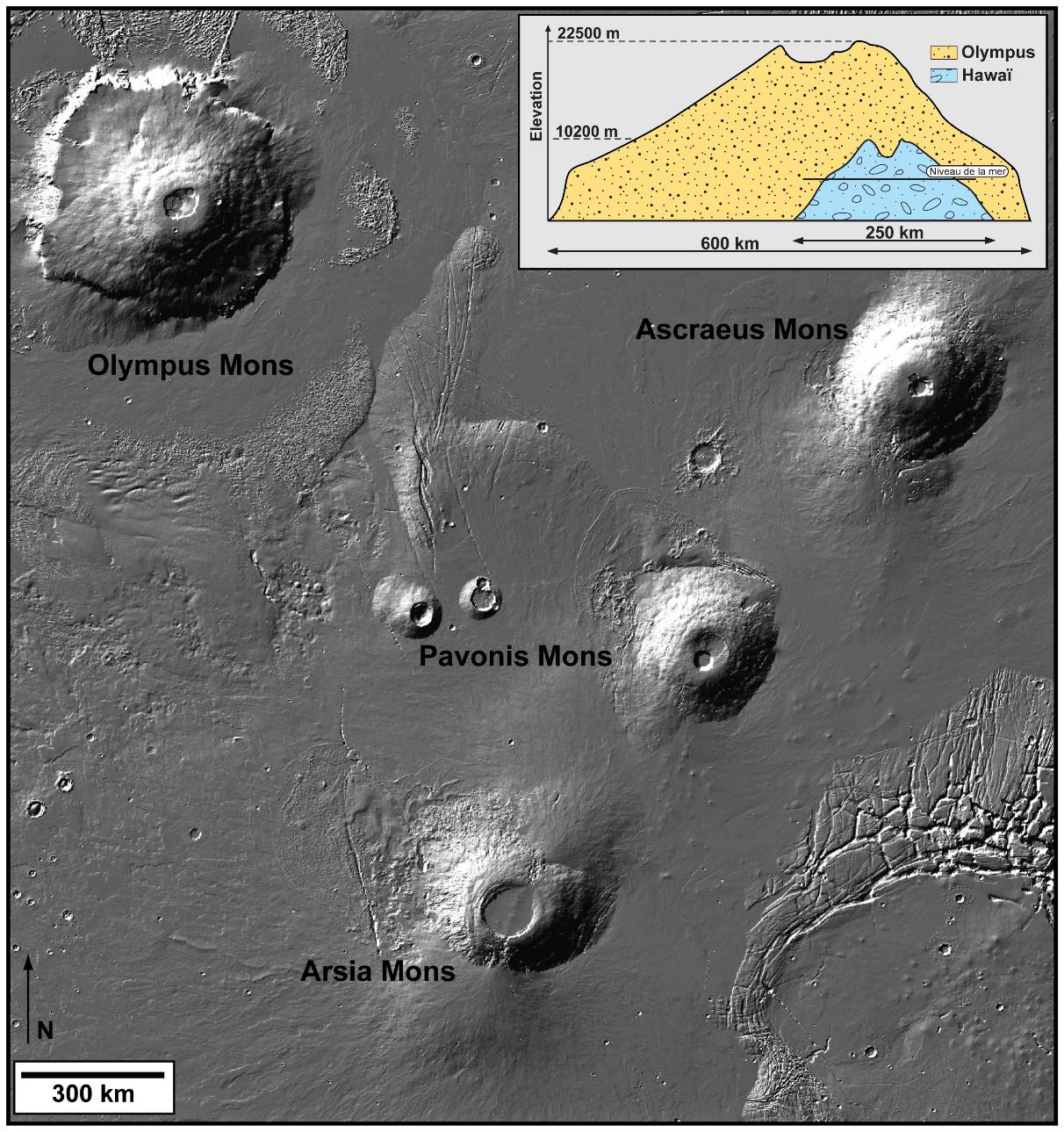

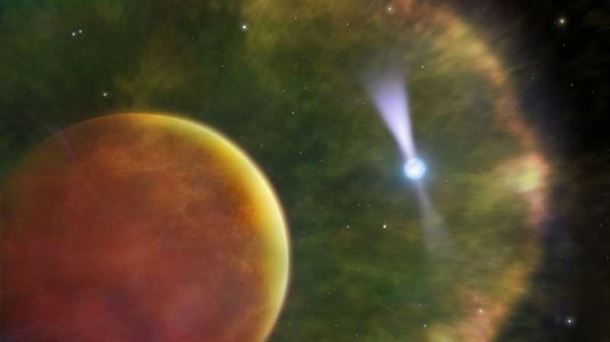

Nous n’avons aucune preuve expérimentale que de telles étoiles puissent être environnées d’astéroïdes. Simplement, un article de radioastronomes publié vers 2008 montrait que des fluctuations de la période avec laquelle nous recevons les signaux d’un pulsar particulier, PSR J1937+21, pourraient être dues à la présence d’astéroïdes. Contrairement aux astéroïdes, nous avions des preuves que des planètes de pulsars existent. Ce furent même les premières exoplanètes découvertes, en 1992 : quatre planètes autour du pulsar PSR B1957+12, bien avant la fameuse planète 51 Peg b orbitant autour d’une étoile de la séquence principale. Une poignée de pulsars sont maintenant connus pour héberger des planètes.

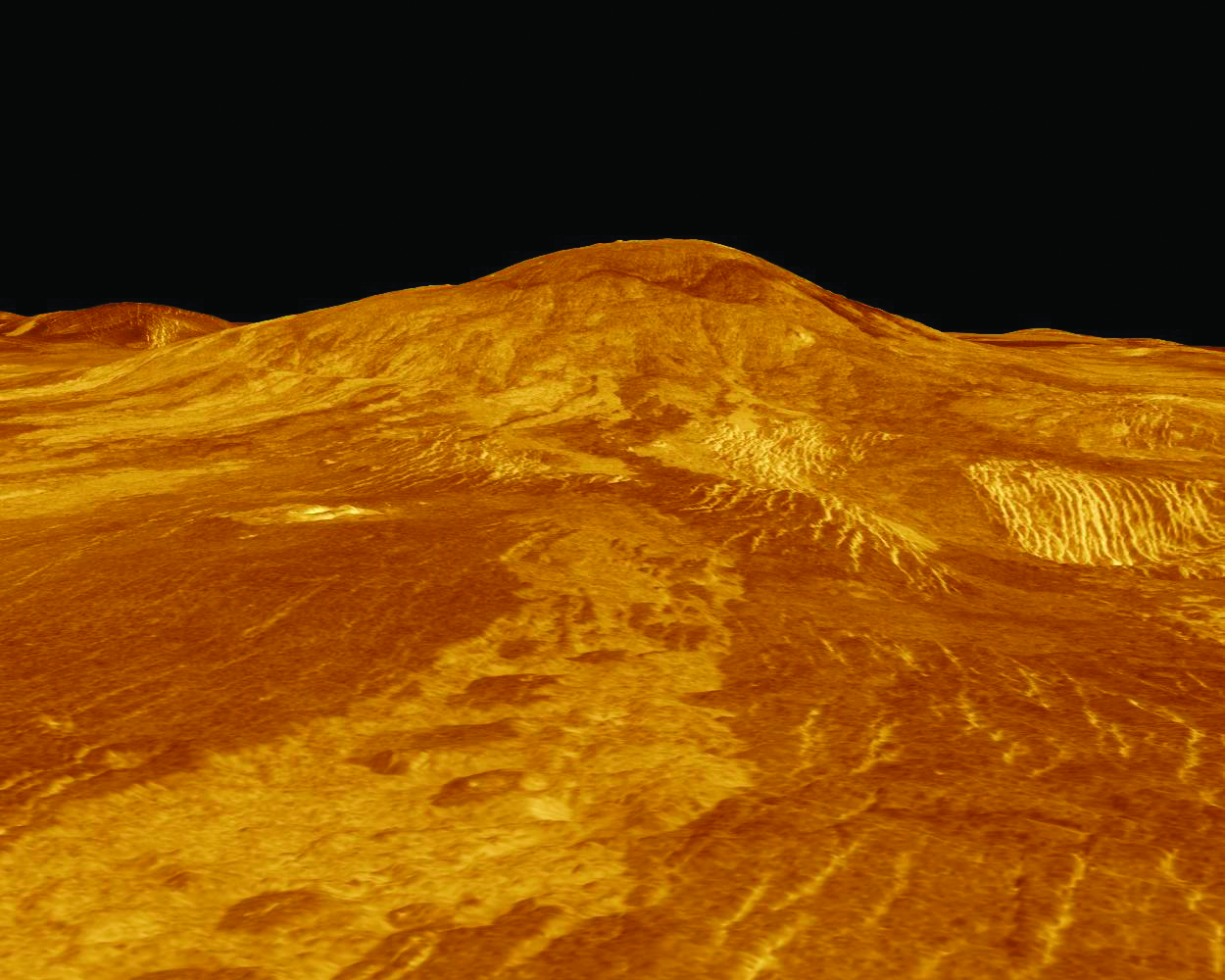

2. Vue d’artiste d’une planète orbitant autour d’un pulsar. (Mark A. Garlick; Dunlap Institute for Astronomy & Astrophysics, University of Toronto)

Vers 2009, je faisais des calculs pour interpréter quelque chose qui n’avait rien à voir avec les FRB, dont j’ignorais alors l’existence. Je voulais comprendre le comportement particulier d’un pulsar nommé PSR 1931+24. Celui-ci est parfois actif (en émettant des ondes radio) et parfois inactif (inobservable). Il alternait les phases d’activité et d’inactivité de manière quasi périodique en une trentaine de jours. Cette périodicité et d’autres propriétés suggéraient que les variations d’activité du pulsar pouvaient être causées par son interaction avec une planète.

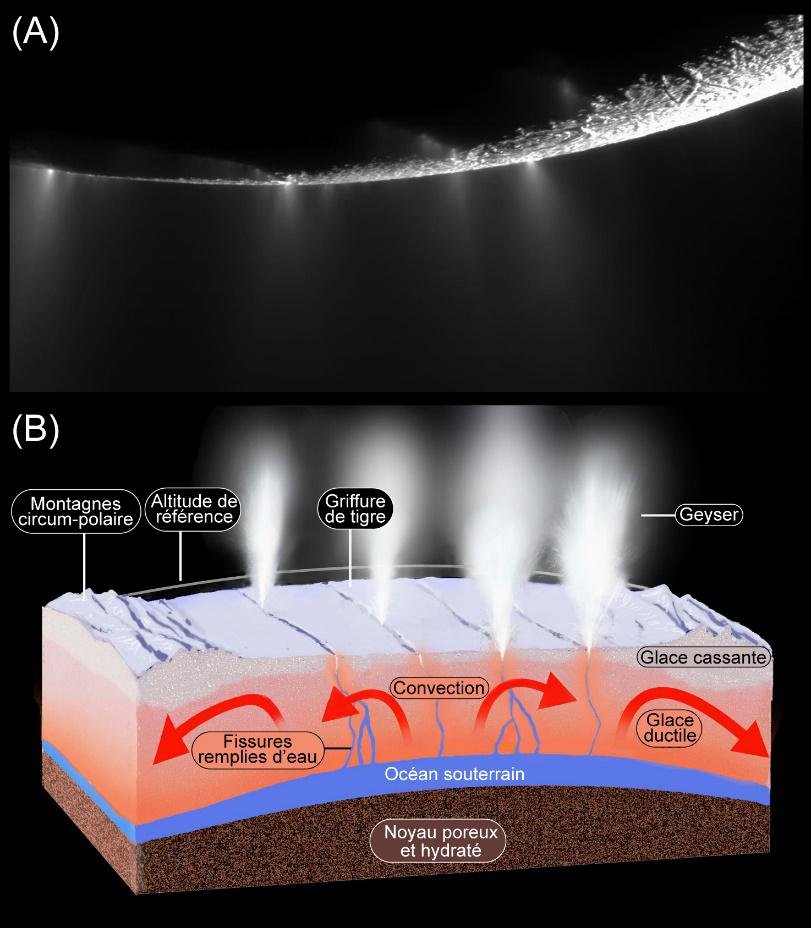

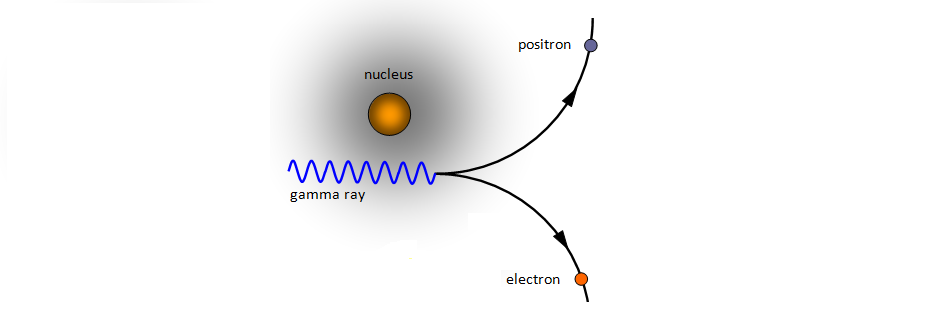

Les étoiles à neutrons émettent un vent d’électrons et de positrons. Les positrons sont des anti-électrons, des particules prédites en 1931 par le physicien Paul Dirac, puis détectées expérimentalement en 1932 par un autre physicien, Carl David Anderson. Le positron est de même masse que l’électron, mais de charge électrique opposée à celle de l’électron, c’est-à-dire positive. La notion d’antimatière a un je-ne-sais-quoi de fascinant qui a beaucoup inspiré les scientifiques et les auteurs de science-fiction. Certains imaginaient dans les années 1950-1960 des galaxies d’antimatière côtoyant dans l’Univers des galaxies de matière comme la nôtre. Des recherches menées dans les années 1970 ont montré qu’en fait, la matière est relativement rare dans l’Univers (elle ne constitue que 20% de sa masse, ou son équivalent en énergie), mais l’antimatière, elle, est presque complètement inexistante. Cependant, dans un pulsar, il arrive que des photons de très haute énergie constituant des rayons gamma se désintègrent en interagissant avec d’autres photons ou avec un champ magnétique, en produisant un électron et son antiparticule, un positron. Les paires d’électron-positron ainsi créées dans les pulsars sont assez nombreuses et énergétiques pour alimenter un vent se propageant depuis l’étoile vers l’espace. Ce vent est peu dense mais extrêmement rapide : il progresse quasiment à la vitesse de la lumière. Comme la théorie de la relativité d’Einstein s’applique pleinement dans ce cas, on dit que ce vent est ultra-relativiste. (Autrement dit, en faisant des calculs de mécanique classique – donc approchés par rapport à la réalité –, on n’obtiendrait avec le vent d’un pulsar des résultats complètement faux.)

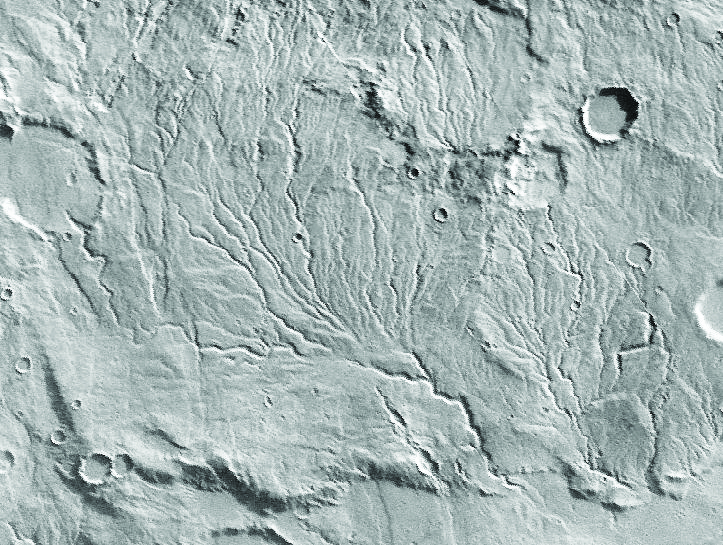

Fig. 3. Dans la plupart des expériences menées sur notre belle planète dans des accélérateurs de particules, des paires électron-positron peuvent être créées lorsqu’un photon de rayonnement gamma interagit avec le champ électrique d’un atome rencontré sur son passage. C’est ce qui est illustré sur cette figure. Pour transformer un photon en une telle paire de particules, il est nécessaire que l’énergie initiale du photon gamma dépasse l’énergie de masse de l’électron plus celle du positron. C’est pour cela que seuls des photons gamma permettent cette réaction, les autres (X, visible, etc.) n’ont pas assez d’énergie. Dans une magnétosphère de pulsar, il y a peu d’atomes, mais beaucoup de photons dans la gamme des rayons X. Les paires électron-positron sont alors créées par interaction entre un photon gamma et un photon X. (DR)

Se trouver face à ce genre de phénomène a quelque chose de déroutant, et l’idée même n’en vient pas spontanément. Pour se faire une place dans ce monde de théories, il n’y a pas de routine possible. Il faut chercher à être à la fois créatifs et rigoureux. L’équilibre n’est pas aisé, et pour distinguer ce qui est possible de ce qui ne l’est pas, on rencontre souvent de sérieuses difficultés de calcul.

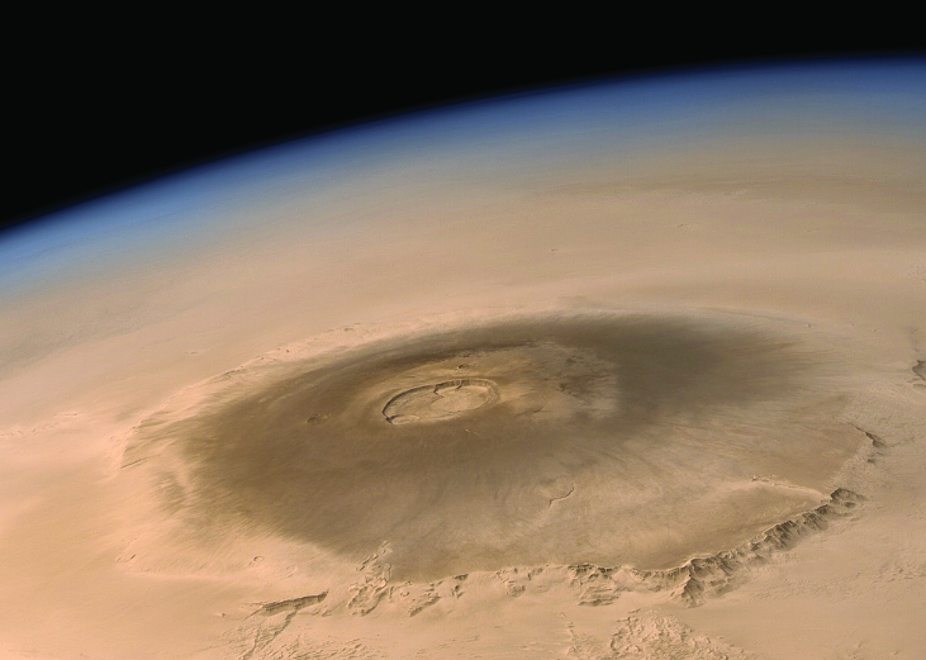

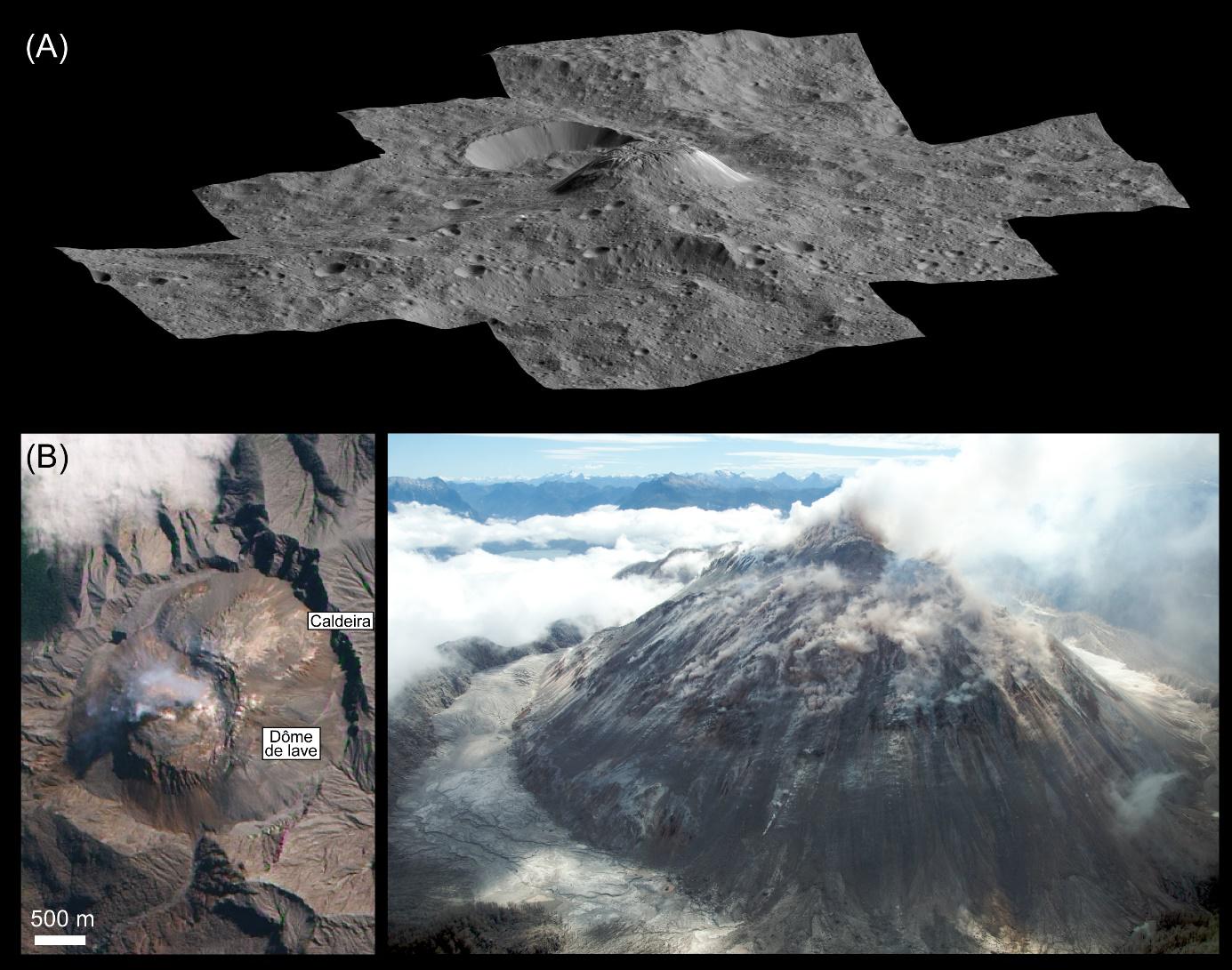

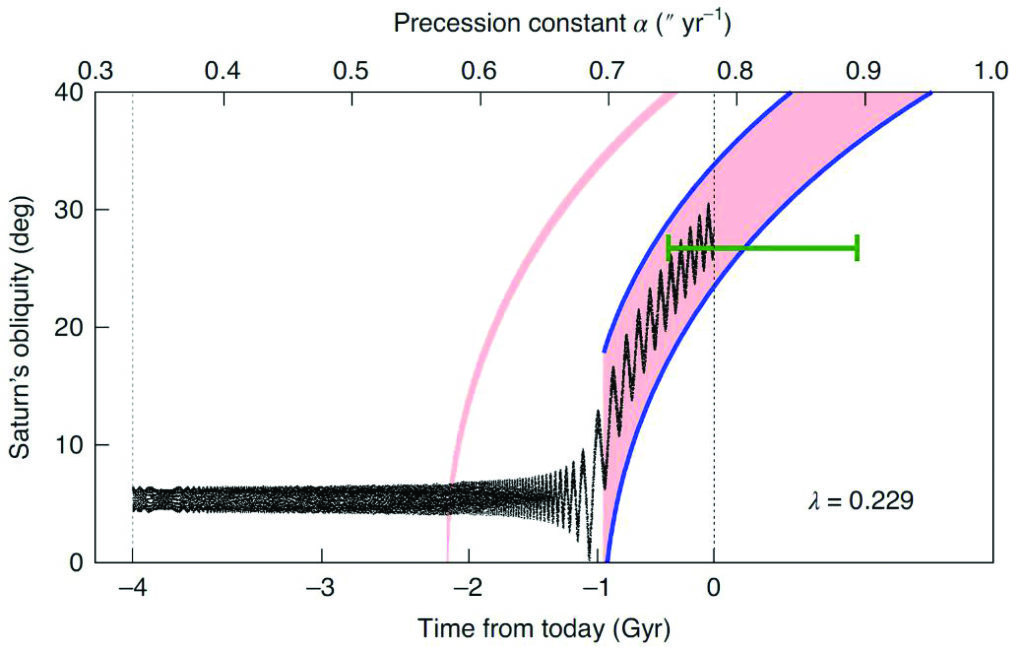

En 2012, j’avais calculé que, dans un vent ultra-relativiste, des astéroïdes ou des planètes d’étoiles à neutrons pouvaient émettre des ondes radio dans un faisceau extrêmement fin (bien plus fin que celui d’un laser) et avec une densité d’énergie très élevée. Si la Terre passait dans un tel faisceau, on capterait un signal radio même si la source était à des millions d’années-lumière (on a mieux calculé depuis qu’elle était même à des milliards d’années-lumière), c’est-à-dire dans des galaxies extrêmement éloignées.

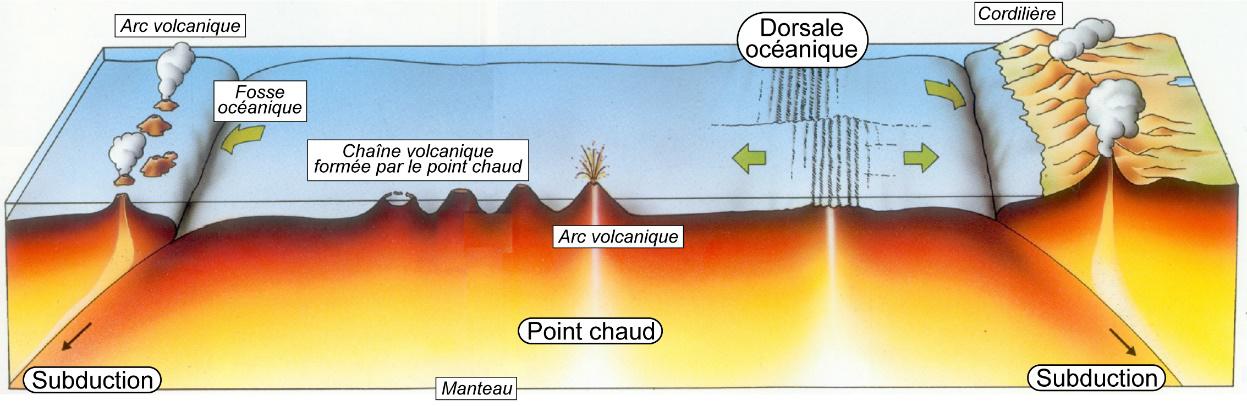

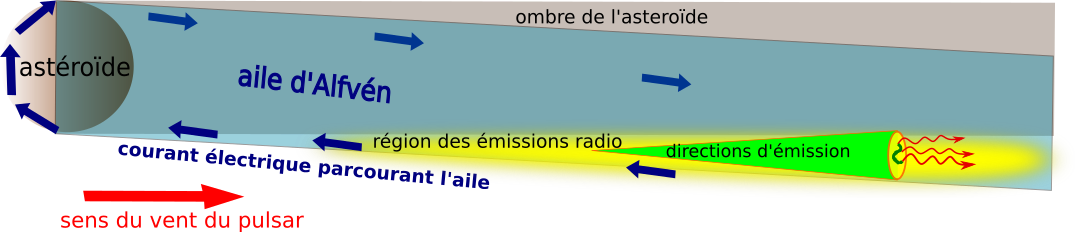

Voici comment est élaboré ce modèle : imaginez un gros caillou conducteur d’électricité (les roches le sont toutes un peu), immergé dans ce vent ultra-rapide et accompagné d’un champ magnétique. Il se forme à l’arrière de ce caillou un sillage analogue à celui que laisse derrière lui un bateau, quasi stationnaire dans le référentiel du navire. S’agissant d’un astre dans un vent magnétisé d’électrons et de positrons, les ondes stationnaires sont des ondes de perturbation du champ magnétique, que l’on appelle des ondes d’Alfvén (voir l’éclairage du numéro de janvier 2022), et ces ondes stationnaires attachées à la planète ou à l’astéroïde sont appelées des ailes d’Alfvén.

Les ailes d’Alfvén sont bien expliquées, notamment celles du satellite Io, qui se déplace dans la magnétosphère de Jupiter. Je les avais étudiées avec un collègue radioastronome, Philippe Zarka, et un étudiant que nous encadrions alors, Sébastien Hess. Mais l’environnement de Jupiter n’est pas ultra-relativiste. En 2011, nous avions montré avec Jean Heyvaerts que les ondes d’Alfvén apparaissent dans un vent ultra-relativiste d’électrons et de positrons, dont nous avions calculé les propriétés. Nous avions aussi montré qu’une interaction entre une planète immergée dans le vent émis par le pulsar PSR 1931+24 (donc très proche de l’étoile à neutrons) pouvait expliquer l’intermittence quasi périodique de ce vent.

Le défaut de notre modèle, à ce stade de développement, était de n’indiquer aucune forme de rayonnement que pourraient capter les télescopes ou les radiotélescopes des astronomes. Or, une théorie n’impliquant pas de phénomènes observables n’intéresse en général pas grand monde. De plus, le fait que PSR 1931+24 puisse s’allumer et s’éteindre régulièrement était une preuve insuffisante de la pertinence du modèle développé par Jean Heyvaerts et moi. Jean décéda subitement en 2013. Vers 2014, j’essayais de calculer quel genre d’ondes radio pourrait engendrer un astre orbitant dans le vent ultrarelativiste d’un pulsar.

Mes calculs montrèrent que le faisceau d’ondes radio émis par le vent au moment où il traverse l’aile d’Alfvén de la planète ou du satellite se trouve focalisé vers l’avant (donc dans la direction opposée à l’étoile). Toute l’énergie était concentrée dans un cône dont l’angle au sommet est de l’ordre de 1/10 000 de degré. Ce faisceau, avec une forte densité de rayonnement encore mieux focalisée qu’un faisceau laser, avait donc tout ce qu’il fallait pour être vu de très loin (puisque la densité de rayonnement est forte), mais seulement très brièvement (au moment précis où la ligne de visée de l’observateur croise ce faisceau). J’étais un peu déçu, car je pensais qu’il faudrait une chance incroyable pour observer un tel phénomène. Quant à PSR 1931+24, sa planète n’avait pas la bonne orientation par rapport à nous pour nous permettre d’observer une telle émission.

Je racontai cela à mon ami Philippe, le radioastronome, lors d’un repas à la cantine de l’Observatoire, en 2013. Je lui dis que je croyais ces signaux inobservables. C’est là qu’il me parla des FRB. Ou plutôt du seul FRB observé à l’époque, qu’on appelait le « signal de Lorimer », un signal ultra-énergétique qu’un radioastronome australien appelé Duncan Lorimer avait découvert en 2010 en ré-épluchant les archives d’un radiotélescope australien (il réanalysait le signal brut avec de nouvelles techniques). Ce que je racontais à Philippe correspondait exactement à ce que Lorimer avait observé. C’était en 2013. À cette époque, Lorimer s’était laissé convaincre que son signal n’était pas un artefact, et il embauchait une thésarde nommée Emily Petroff. Petroff et Lorimer découvrirent et caractérisèrent vers 2012-2013 d’autres signaux de ce genre, puis des signaux analogues furent observés avec d’autres radiotélescopes. C’est à ce moment-là que le terme FRB fut inventé. Philippe et moi nous sommes mis au travail ensemble et, en 2014, nous avons publié un article montrant que des planètes (nous ne pensions pas encore à des astéroïdes) autour d’un pulsar pouvaient expliquer les FRB. On connaissait une dizaine de FRB en 2014, on dépasse le millier actuellement.

Nous présentions le seul modèle prédisant que les FRB pourraient se répéter périodiquement : du fait que les planètes tournent régulièrement, à chaque passage, on a une chance de capter un FRB. Tous les autres modèles de FRB associés à des sources très éloignées prévoyaient des phénomènes catastrophiques extrêmement énergétiques, mais uniques. Dans les mêmes années, des radioastronomes prouvèrent que les FRB se produisent réellement à des milliards d’années-lumière de nous. Notre modèle était donc le seul à prévoir la production d’un FRB par une source située à la bonne distance, ainsi que sa répétition périodique.

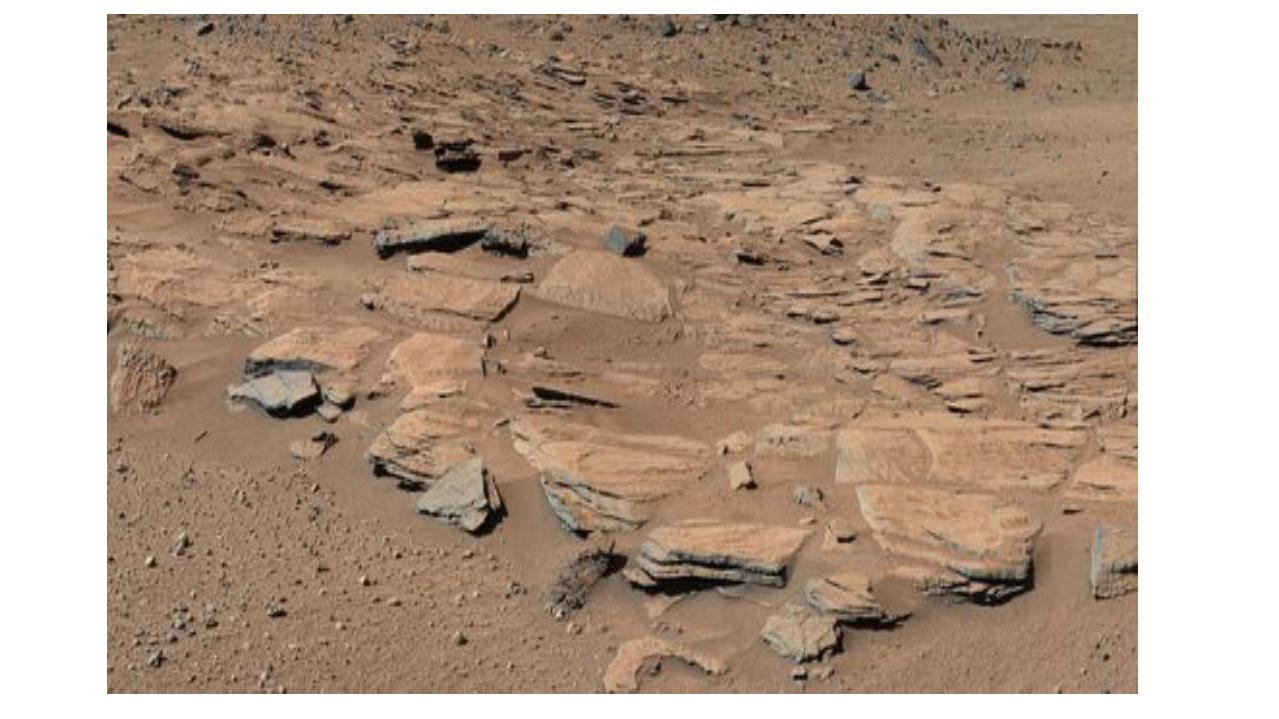

Fig. 4. Schéma illustrant le sillage d’un astéroïde dans le vent d’un pulsar ou d’un magnétar et l’emplacement des sources d’émission radio perçues depuis la Terre sous la forme de FRB. L’étoile à neutrons est à gauche (hors image) et le vent issu de la magnétosphère de cette étoile (flèche rouge) se déplace vers la droite. L’astéroïde possède un sillage électromagnétique nommé aile d’Alfvén, parcouru par un courant électrique intense (flèches bleues). L’interaction du vent du pulsar avec ce courant, qui a lieu dans l’aile, hors de l’ombre de l’astéroïde (zone en jaune), crée des émissions d’ondes radio. Dans le repère de l’astéroïde (ou celui de la Terre), celles-ci sont émises dans un faisceau étroit (figuré en vert). En réalité, l’angle formé par l’aile avec la direction du vent, ainsi que l’ouverture de l’angle au sommet du cône sont beaucoup plus faibles que sur cette image. Ces émissions radio sont très puissantes dans la direction du cône et nulles dans les autres directions. Quand ce cône croise brièvement les radiotélescopes terrestres, à des milliards d’années-lumière de distance, le signal correspond à un FRB. (F. Mottez)

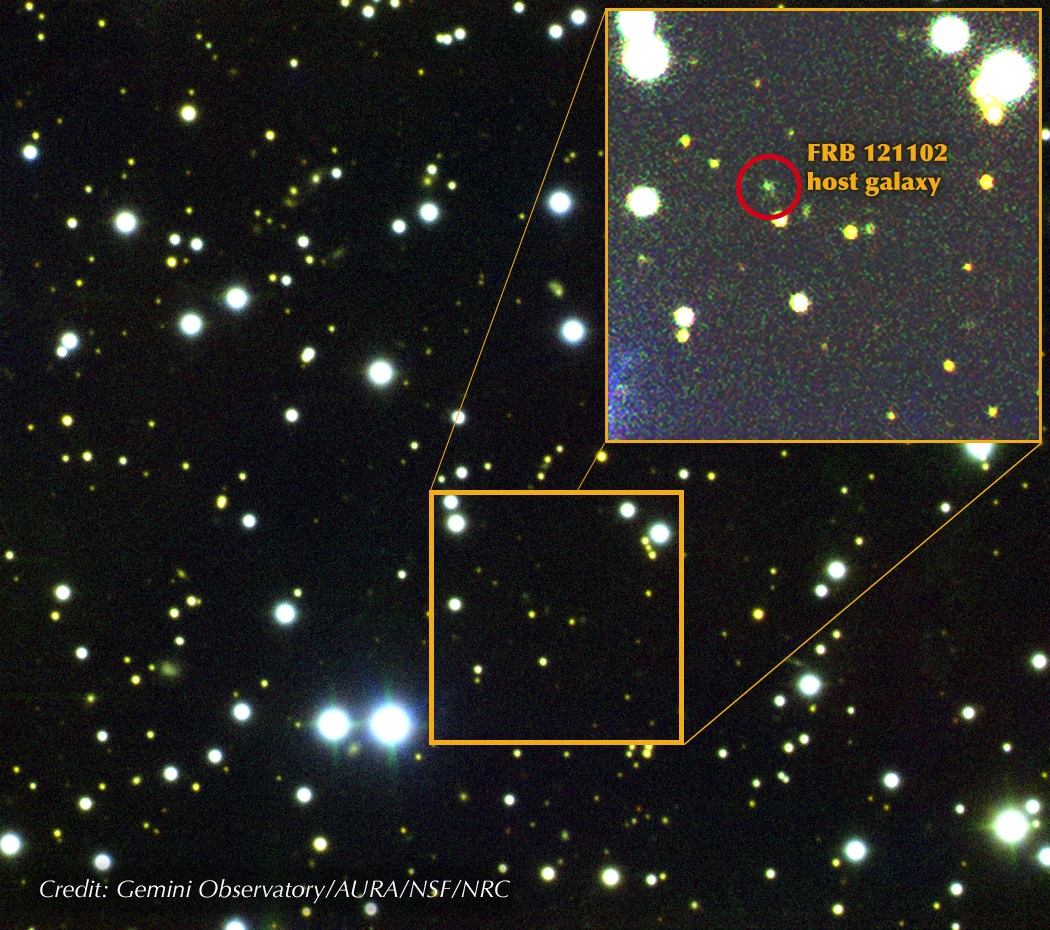

Quelques mois plus tard, des radioastronomes d’Arecibo découvrirent un FRB se répétant. Il fut baptisé FRB121102, car il avait été enregistré la première fois le 2 novembre 2012 (et identifié ultérieurement). Quelle joie pour nous ! Mais les répétitions étaient irrégulières, et donc notre modèle ne collait pas parfaitement. Alors, avec Philippe et l’un de mes anciens étudiants, Guillaume Voisin, nous avons repensé à des astéroïdes. Il nous semblait que ceux-ci, par leur nombre et leurs positions variées autour de l’étoile, feraient disparaître le caractère périodique associé à une seule planète. Nous nous disions qu’en jouant un peu avec les paramètres, nous devrions y arriver.

Avec une collègue de l’Institut d’astrophysique de Paris, Kumiko Kotera, nous avons étudié le chauffage des astéroïdes. S’ils sont trop proches d’une étoile à neutrons, dont la température de surface est d’un million de degrés et qui émettent des ondes radio de très grande énergie, il faut s’attendre à ce que les astéroïdes s’évaporent, et donc… qu’il n’y en ait plus. Alors, exit notre modèle. L’onde électromagnétique qui chauffe des astres autour des pulsars est une onde émise à la fréquence de rotation du pulsar sur lui-même et qui se propage à la vitesse de la lumière. Comme une étoile à neutrons fait typiquement de 1 à 1 000 tours par seconde, c’est une onde de fréquence entre 1 Hz et 1 000 Hz, dont la longueur se mesure en centaines de kilomètres. Or, j’avais observé que, dans un four à micro-ondes (qui chauffe un peu à la manière de cette onde d’étoile à neutrons), on peut faire bouillir un bol rempli d’eau, mais que les gouttes tombées à côté du bol restent tièdes et ne s’évaporent pas. Avec Kumiko, nous avons expliqué cette observation par une théorie physique bien connue (la théorie de Mie), que nous avons appliquée aux astéroïdes de pulsar : pour qu’un corps absorbe l’énergie d’une onde (telle celle émise par un pulsar) et soit chauffé par elle, il faut que les dimensions de ce corps soient comparables ou plus grandes que la longueur de cette onde. Nous avons montré que les astéroïdes baignés dans les ondes des pulsars sont comme les gouttes d’eau dans un four à micro-ondes : ils sont assez petits pour ne pas être suffisamment chauffés et demeurent donc dans leur état solide de gros caillou.

Ensuite, j’ai préféré attendre que les données d’observation s’accumulent avant de me remettre au travail sur ce sujet. En fait, je ne croyais plus à ce modèle, pour certaines raisons techniques, liées notamment à la durée du phénomène, que je pensais plus variable que celle des FRB observés. Mais Philippe insistait pour s’y remettre. En 2020, je me suis laissé convaincre. Philippe, Guillaume et moi avons conçu un autre modèle montrant que des astéroïdes d’étoile à neutrons peuvent causer des FRB. En gros, notre nouveau modèle tenait bon, alors que des dizaines d’autres devenaient caduques au vu de récentes observations.

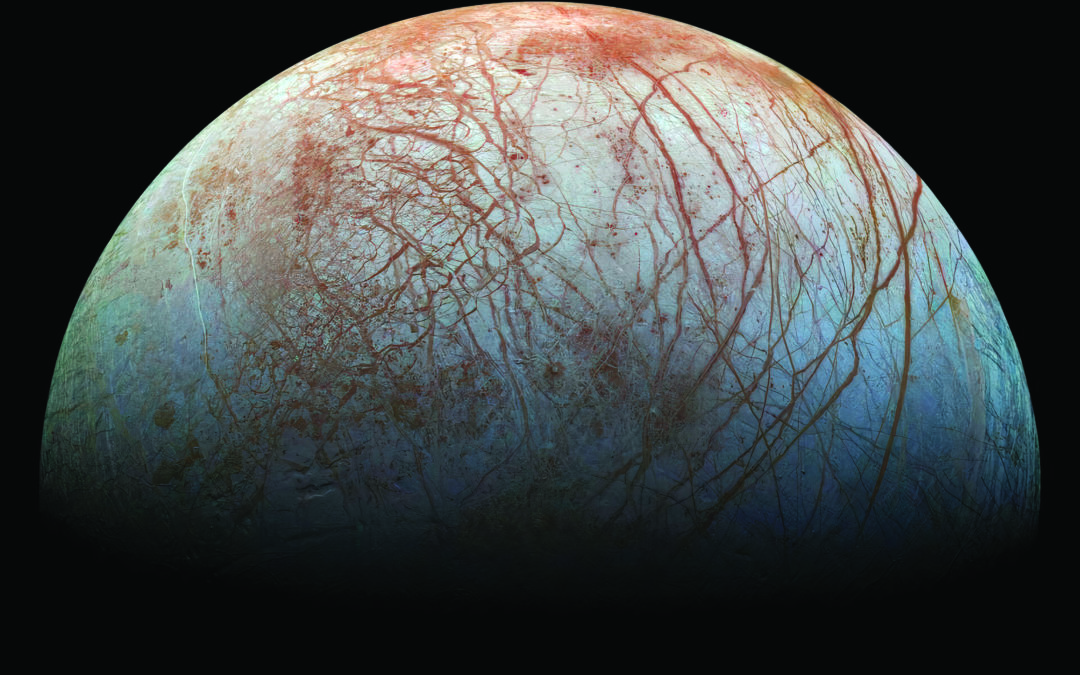

5. A l’issue d’une enquête difficile, il a été possible de localiser le FRB121102, le premier identifié comme ayant des sursauts se répétant aléatoirement. Il est situé dans une galaxie naine dénuée de caractéristiques remarquables, dont la distance est de l’ordre de 3 milliards d’années-lumière. (Gemini Observatory/AURA/NSF/NR)

Durant cette période 2018-2020, des observateurs découvraient un autre FRB répéteur (on en connaît actuellement plus d’une vingtaine). Celui-ci est périodique, mais statistiquement seulement : des sursauts se produisent aléatoirement, mais seulement lors d’intervalles de temps de quelques jours se répétant tous les 16 jours. Guillaume eut une idée judicieuse pour interpréter ce comportement : il serait dû à la présence de deux familles particulières d’astéroïdes, les troyens et les hildas, également observés dans l’environnement de Jupiter. Nos « ingrédients » étaient donc un pulsar (pas suffisamment bien orienté pour être observé, comme c’est le cas le plus fréquent), entouré d’une grosse planète (qu’on ne voit pas) et d’astéroïdes troyens et hildas liés à cette planète et à l’étoile à neutrons.

De nos jours, notre théorie n’est toujours pas dans le mainstream, ce n’est pas celle que les collègues citent le plus souvent. Cependant, elle reste en lice. Deux familles de modèles, avec de multiples variantes, sont plus populaires (à lire dans le prochain numéro de l’Astronomie), et une poignée d’autres avec un statut semblable à la nôtre.

Une autre théorie est souvent assimilée à la nôtre, car elle implique aussi une étoile à neutrons et des astéroïdes. Elle a été développée notamment par Bing Zang, de l’université du Nevada (É.-U.). Contrairement à la nôtre, qui laisse les astéroïdes en orbite autour d’une étoile à neutrons, la sienne fait tomber les astéroïdes directement sur l’étoile.

Les théories actuelles expliquent beaucoup de choses, mais pas tout. Elles progressent petit à petit, au fil des observations et des idées nouvelles. On peut espérer qu’il y aura finalement un consensus. Pour le moment, les chercheurs ne sont pas tous prêts à admettre qu’une seule et même théorie puisse expliquer l’ensemble des FRB. Il pourrait en effet exister plusieurs sortes de FRB, avec des causes différentes.

Que notre théorie soit bonne ou mauvaise, qu’elle survive ou non aux futures observations, nous aurons fait notre travail de chercheurs scientifiques, car la science avance ainsi, avec des essais, des échecs et des succès. Une théorie ne peut être acceptée seulement parce qu’elle fonctionne. Il faut aussi vérifier s’il n’y en a pas d’autres possibles. Et pour en être sûr, il faut toutes les essayer.

Fabrice MOTTEZ | CNRS, Observatoire de Paris